ALBERT: A Lite BERT for Self-Supervised Learning of Language Representations

مقدمة

منذ ظهور BERT قبل عام، اعتمدت أبحاث اللغة الطبيعية على نموذج جديد، مستفيدة من كميات كبيرة من النصوص الموجودة مسبقًا لتدريب معلمات النموذج باستخدام الإشراف الذاتي، دون الحاجة إلى توضيح البيانات. بدلاً من الحاجة إلى تدريب نموذج تعلم آلي لمعالجة اللغة الطبيعية (NLP) من الصفر، يمكن البدء من نموذج مُعد مسبقًا بمعرفة اللغة.

الميزات الرئيسية

تحسين الأداء في معالجة اللغة الطبيعية

في "ALBERT: A Lite BERT for Self-supervised Learning of Language Representations"، الذي تم قبوله في ICLR 2020، نقدم ترقية لـ BERT تعزز الأداء الرائد في 12 مهمة معالجة لغة طبيعية، بما في ذلك مجموعة بيانات Stanford Question Answering (SQuAD v2.0) ومعيار القراءة SAT-style RACE.

تقليل عدد المعلمات

يحقق ALBERT تقليلًا بنسبة 80% في عدد معلمات كتلة الإسقاط، مع انخفاض طفيف في الأداء، حيث سجل 80.3 في SQuAD2.0، مقارنة بـ 80.4.

مشاركة المعلمات

تتمثل إحدى القرارات التصميمية الحاسمة في ALBERT في مشاركة المعلمات عبر الطبقات، مما يقلل من عدد المعلمات بنسبة 90% لكتلة الانتباه-التغذية الأمامية.

حالات الاستخدام

يستخدم ALBERT في مجموعة متنوعة من التطبيقات في معالجة اللغة الطبيعية، بما في ذلك:

- تحسين محركات البحث

- تحليل المشاعر

- أنظمة الأسئلة والأجوبة

التسعير

ALBERT متاح كتنفيذ مفتوح المصدر على TensorFlow، مما يسهل الوصول إليه من قبل الباحثين والمطورين.

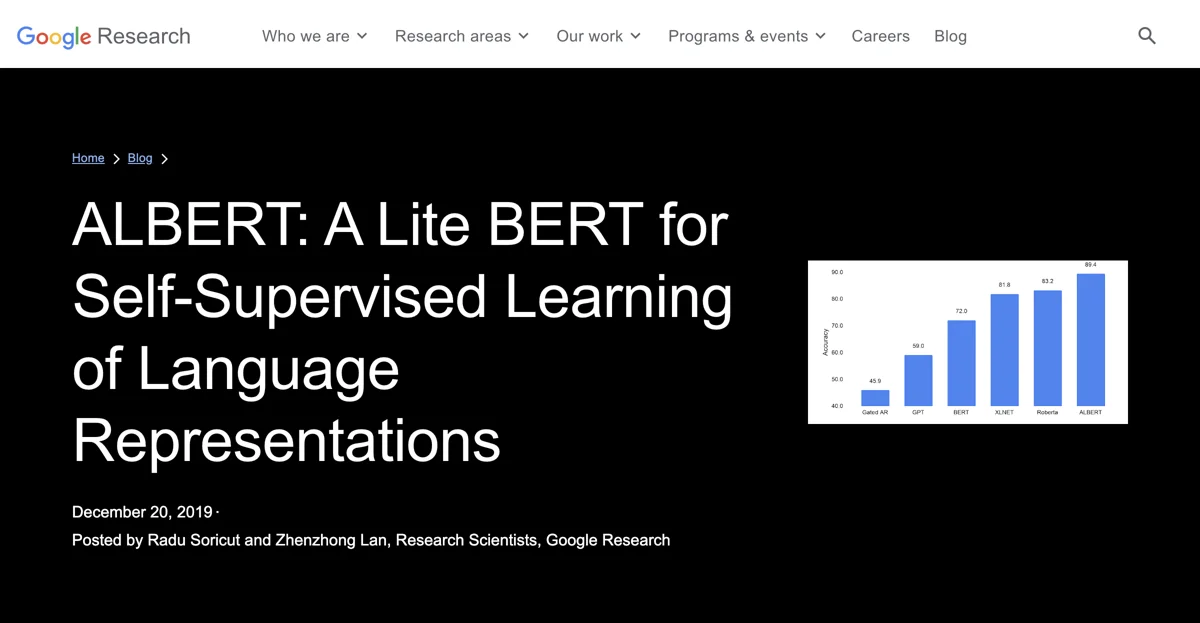

المقارنات

عند مقارنة ALBERT مع نماذج أخرى مثل BERT وXLNet، يظهر ALBERT أداءً متفوقًا في العديد من المهام.

نصائح متقدمة

لتحقيق أفضل النتائج مع ALBERT، يُنصح بتدريبه على مجموعات بيانات أكبر واستخدام تقنيات تحسين متقدمة.

الخاتمة

تظهر نجاحات ALBERT أهمية تحديد الجوانب التي تعزز التمثيلات السياقية القوية. من خلال التركيز على تحسين هذه الجوانب، يمكن تحسين كفاءة النموذج وأدائه في مجموعة واسعة من مهام معالجة اللغة الطبيعية.

الكلمات الرئيسية

ALBERT, BERT, معالجة اللغة الطبيعية, التعلم الذاتي, الذكاء الاصطناعي