ALBERT: A Lite BERT for Self-Supervised Learning of Language Representations

Einleitung

Im Dezember 2019 veröffentlichten die Forschungswissenschaftler Radu Soricut und Zhenzhong Lan von Google Research einen Artikel über ALBERT, eine verbesserte Version des BERT-Modells, das die Leistung in der natürlichen Sprachverarbeitung (NLP) revolutioniert hat. ALBERT nutzt selbstüberwachtes Lernen, um Sprachrepräsentationen zu erlernen, und bietet eine Reihe von Vorteilen gegenüber seinem Vorgänger.

Was ist ALBERT?

ALBERT steht für "A Lite BERT" und ist ein Modell, das entwickelt wurde, um die Effizienz und Leistung in NLP-Aufgaben zu verbessern. Es wurde als Open-Source-Implementierung auf TensorFlow veröffentlicht und bietet vortrainierte Sprachmodelle, die sofort verwendet werden können.

Hauptmerkmale von ALBERT

- Parameterreduktion: ALBERT erreicht eine Reduktion der Parameter um bis zu 89 % im Vergleich zum BERT-Basismodell, ohne die Leistung erheblich zu beeinträchtigen.

- Effiziente Nutzung von Kapazitäten: Durch die Aufteilung der Einbettungsmatrix in kontextunabhängige und kontextabhängige Repräsentationen wird die Effizienz des Modells maximiert.

- Parameterteilung: ALBERT teilt Parameter über die Schichten hinweg, was die Redundanz verringert und die Modellgröße weiter reduziert.

Leistungsverbesserungen

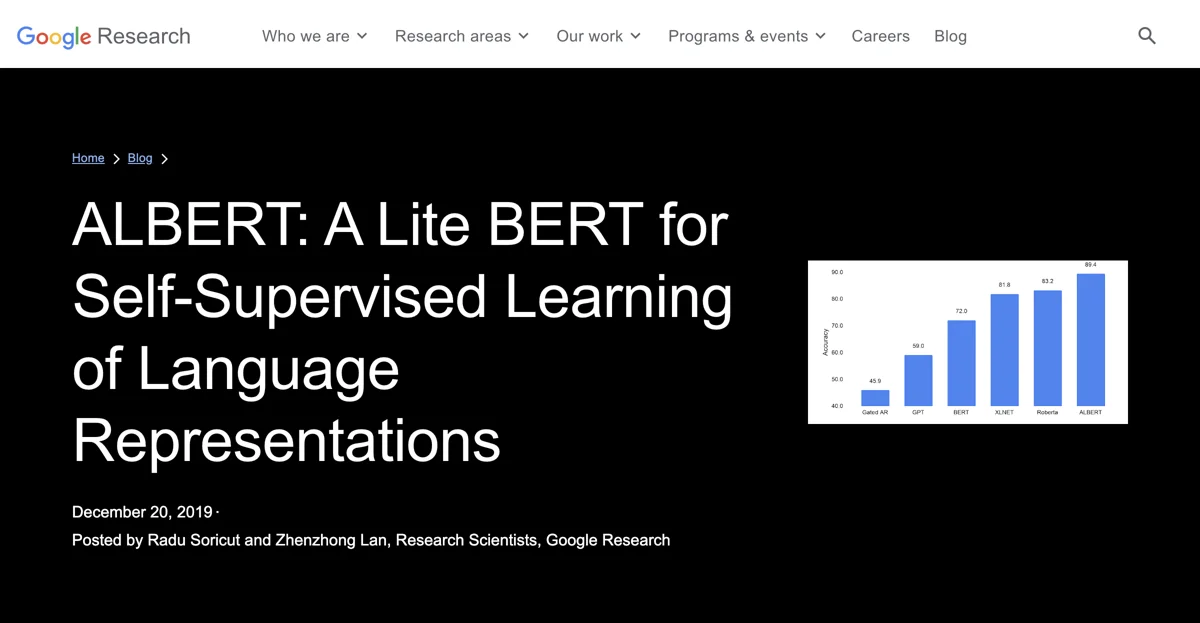

ALBERT hat in mehreren Benchmarks, einschließlich SQuAD v2.0 und RACE, signifikante Leistungssteigerungen erzielt. Zum Beispiel erzielte das ALBERT-xxlarge-Modell eine Punktzahl von 88.1 auf SQuAD2.0, was eine Verbesserung von 4.2 Punkten gegenüber BERT darstellt.

Anwendung von ALBERT

ALBERT kann in verschiedenen NLP-Anwendungen eingesetzt werden, darunter:

- Frage-Antwort-Systeme

- Textklassifizierung

- Sprachübersetzung

Preisgestaltung

ALBERT ist als Open-Source-Software verfügbar, was bedeutet, dass es kostenlos genutzt werden kann. Die Implementierung auf TensorFlow ermöglicht es Entwicklern, das Modell an ihre spezifischen Bedürfnisse anzupassen.

Praktische Tipps

- Experimentieren Sie mit verschiedenen Konfigurationen: Nutzen Sie die Flexibilität von ALBERT, um die besten Ergebnisse für Ihre spezifischen Anwendungen zu erzielen.

- Nutzen Sie vortrainierte Modelle: Beginnen Sie mit den vortrainierten Modellen, um Zeit und Ressourcen zu sparen.

Vergleich mit anderen Modellen

Im Vergleich zu anderen Modellen wie XLNet und RoBERTa bietet ALBERT eine ähnliche oder bessere Leistung bei einer erheblich reduzierten Modellgröße. Dies macht es zu einer attraktiven Wahl für Entwickler und Forscher.

Häufig gestellte Fragen (FAQ)

F: Ist ALBERT besser als BERT?

A: Ja, ALBERT bietet eine verbesserte Effizienz und Leistung bei vielen NLP-Aufgaben.

F: Wo kann ich ALBERT finden?

A: ALBERT ist auf GitHub als Open-Source-Projekt verfügbar.

Fazit

ALBERT stellt einen bedeutenden Fortschritt in der natürlichen Sprachverarbeitung dar. Durch die Kombination von Effizienz und Leistung ist es eine hervorragende Wahl für Forscher und Entwickler, die an NLP-Projekten arbeiten. Probieren Sie ALBERT noch heute aus und entdecken Sie die Möglichkeiten, die es bietet!