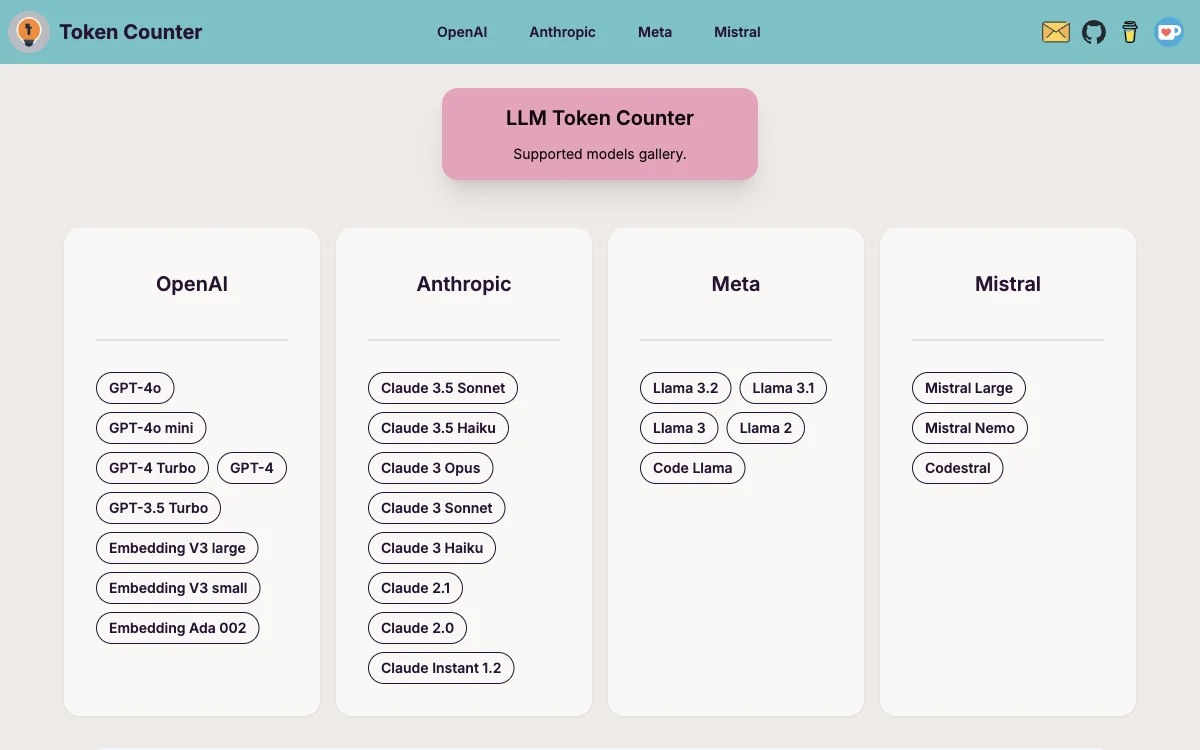

Der LLM Token Counter ist ein innovatives Werkzeug, das speziell entwickelt wurde, um Benutzern bei der effizienten Verwaltung von Token-Grenzen für eine breite Palette von weit verbreiteten Sprachmodellen (LLMs) zu helfen. Dazu gehören Modelle wie GPT-3.5, GPT-4, Claude-3, Llama-3 und viele andere. Das Tool ist darauf ausgelegt, die Nutzung von generativer KI-Technologie zu optimieren, indem es kontinuierlich unterstützte Modelle erweitert und seine Fähigkeiten verbessert.

Warum einen LLM Token Counter verwenden?

Aufgrund der inhärenten Beschränkungen von Sprachmodellen ist es entscheidend, sicherzustellen, dass die Token-Anzahl Ihres Prompts innerhalb der festgelegten Grenze liegt. Das Überschreiten dieser Grenze kann zu unerwarteten oder unerwünschten Ausgaben des Modells führen.

Wie funktioniert der LLM Token Counter?

Der LLM Token Counter nutzt Transformers.js, eine JavaScript-Implementierung der bekannten Hugging Face Transformers-Bibliothek. Tokenizer werden direkt in Ihrem Browser geladen, was die Berechnung der Token-Anzahl clientseitig ermöglicht. Dank der effizienten Rust-Implementierung der Transformers-Bibliothek ist die Token-Berechnung bemerkenswert schnell.

Wird mein Prompt geleakt?

Nein, Ihr Prompt wird nicht geleakt. Die Berechnung der Token-Anzahl erfolgt clientseitig, was sicherstellt, dass Ihr Prompt sicher und vertraulich bleibt. Ihre Datenschutz ist von größter Bedeutung, und dieser Ansatz garantiert, dass Ihre sensiblen Informationen niemals an den Server oder eine externe Entität übertragen werden.