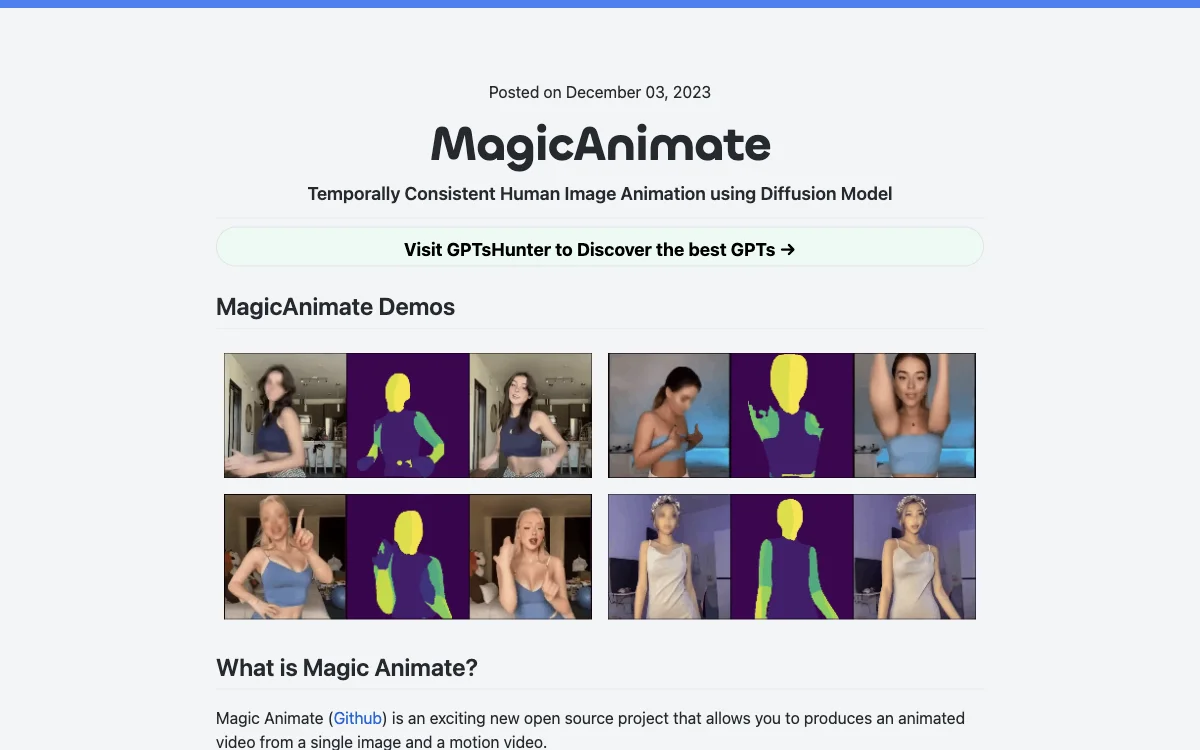

MagicAnimate ist ein innovatives Open-Source-Projekt, das es ermöglicht, aus einem einzelnen Bild und einem Bewegungsvideo ein animiertes Video zu erstellen. Dieses Tool basiert auf einem Diffusionsmodell und zeichnet sich durch seine Fähigkeit aus, zeitliche Konsistenz zu bewahren, das Referenzbild treu zu erhalten und die Animationstreue erheblich zu verbessern. Es kann Referenzbilder mit Bewegungssequenzen aus verschiedenen Quellen animieren, einschließlich Cross-ID-Animationen und ungesehenen Domänen wie Ölgemälden und Filmcharakteren. MagicAnimate integriert sich nahtlos mit T2I-Diffusionsmodellen wie DALLE3 und bringt textgesteuerte Bilder mit dynamischen Aktionen zum Leben.

Entwickelt wurde MagicAnimate vom Show Lab, der National University of Singapore und Bytedance. Zu den Vorteilen gehört die derzeit höchste Konsistenz unter allen Tanzvideo-Lösungen. Allerdings gibt es auch Nachteile, wie Verzerrungen im Gesicht und an den Händen, sowie einen Stilwechsel von Anime zu Realismus, insbesondere in den Gesichtern der Videos. Dies könnte eine Anpassung des Checkpoints erfordern.

Für den Einstieg müssen die vortrainierten Basismodelle für StableDiffusion V1.5 und MSE-finetuned VAE heruntergeladen werden. Die Installation erfordert Python>=3.8, CUDA>=11.3 und ffmpeg. MagicAnimate bietet Online-Demos auf Huggingface und Replicate an und kann auch auf Colab ausgeführt werden. Darüber hinaus steht eine API zur Verfügung, um animierte Videos zu generieren.