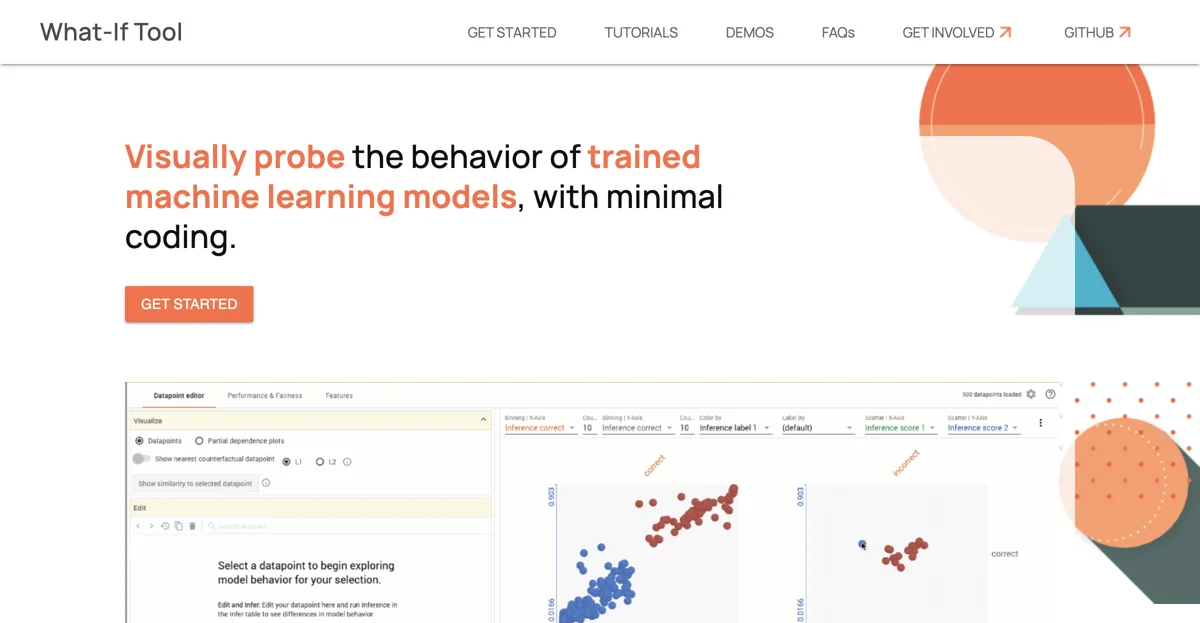

Das What-If Tool bietet eine innovative Möglichkeit, das Verhalten von trainierten Machine-Learning-Modellen visuell zu untersuchen. Es ermöglicht Benutzern, die Leistung von Modellen in hypothetischen Szenarien zu testen, die Bedeutung verschiedener Datenmerkmale zu analysieren und das Modellverhalten über mehrere Modelle und Teilmengen von Eingabedaten hinweg zu visualisieren. Besonders hervorzuheben ist die Fähigkeit des Tools, verschiedene Fairness-Metriken für ML-Systeme zu bewerten.

Das Tool ist in verschiedene Plattformen und Workflows integrierbar, darunter Colaboratory-Notebooks, Jupyter-Notebooks, Cloud AI Notebooks, TensorBoard und TFMA Fairness Indicators. Es unterstützt eine Vielzahl von Modellen und Frameworks, einschließlich TF Estimators, Modelle, die von TF Serving bereitgestellt werden, und Modelle, die in eine Python-Funktion eingebunden werden können. Darüber hinaus ist es mit verschiedenen Daten- und Aufgabenarten kompatibel, wie binäre Klassifikation, Multi-Klassen-Klassifikation, Regression sowie tabellarische, Bild- und Textdaten.

Das What-If Tool fördert auch die Gemeinschaftsarbeit, indem es Entwickler einlädt, zur Weiterentwicklung und Verbesserung des Tools beizutragen. Es bietet regelmäßige Updates mit neuen Funktionen und Verbesserungen und wird durch Forschungsarbeiten unterstützt, die auf Konferenzen wie IEEE VAST '19 präsentiert wurden. Ein besonderer Fokus liegt auf der Erforschung von KI-Fairness, wobei das Tool die Möglichkeit bietet, fünf verschiedene Arten von Fairness zu testen und zu verstehen.