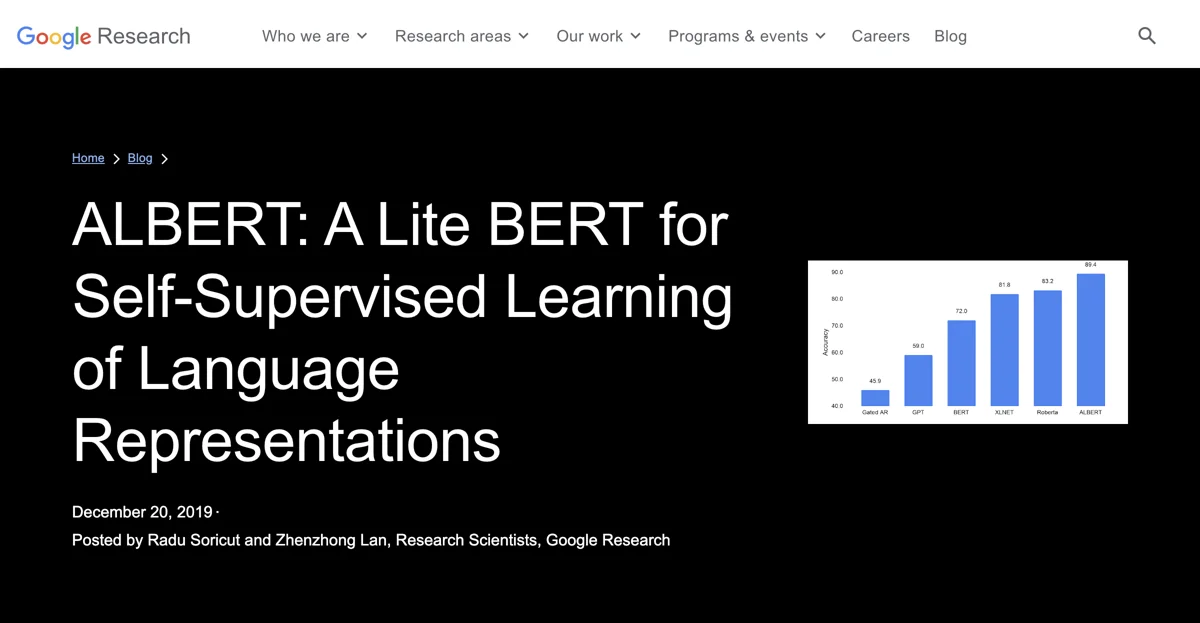

ALBERT es una mejora a BERT para el aprendizaje auto-supervisado de representaciones de lenguaje. Su investigación ha permitido empezar con un modelo que ya tiene conocimiento del lenguaje. Se presenta como una implementación de código abierto en TensorFlow con varios modelos preentrenados. Su diseño busca una asignación más eficiente de la capacidad del modelo. Logra una reducción del 80% en los parámetros del bloque de proyección y del 90% en los del bloque de atención-alimentación, lo que permite un modelo más eficiente. ALBERT obtiene un buen rendimiento en 12 tareas de NLP, incluyendo SQuAD v2.0 y RACE. En RACE, establece un nuevo récord de puntuación de 89.4. El éxito de ALBERT demuestra la importancia de mejorar la arquitectura del modelo para mejorar la eficiencia y el rendimiento en NLP, y se libera a la comunidad de investigación.

ALBERT

Descubre cómo ALBERT mejora el rendimiento en tareas de NLP con un diseño eficiente y reducción de parámetros.

Mejores alternativas a ALBERT

Juego Human or AI

El Juego Human or AI te desafía a identificar si las imágenes son humanas o generadas por IA

techtrust.ai

techtrust.ai ofrece servicios de tecnología con potencial

Socially Sourced Startup Ideas

Socially Sourced Startup Ideas ayuda a encontrar ideas emprendedoras en redes sociales

screenpipe

Screenpipe es una herramienta que captura actividades de escritorio y ofrece diversas funcionalidades

Melon

Melon es una herramienta AI que potencia el pensamiento y las conexiones de aprendizaje

Intuition Machines

Intuition Machines es una plataforma de IA que ofrece soluciones innovadoras

GPTs Finder

GPTs Finder ofrece actualizaciones horarias de GPTs para usuarios.

BeanBook

BeanBook es una app que permite rastrear, explorar y hacer preguntas sobre café con la ayuda de IA

Boba

Boba es un copiloto AI para la ideación generativa

Wiseone

Wiseone es una herramienta AI que mejora la productividad en la web

Project Knowledge Exploration

Project Knowledge Exploration es una plataforma que mejora la experiencia del usuario

Runway

Runway es una compañía de investigación de IA que impulsa la creatividad

Notably

Notably es una plataforma de investigación AI que facilita el análisis de datos

PaperBrain

PaperBrain es una herramienta que simplifica la literatura científica

Unriddle

Unriddle es una herramienta AI que agiliza la investigación

Journey AI

Journey AI converts customer research into journey maps quickly

genei

genei es una herramienta AI que optimiza la investigación y la escritura

Replio

Replio es una plataforma AI que transforma encuestas en entrevistas conversacionales

Layer

Layer es una herramienta AI que reduce el tiempo de investigación en un 40%.

Iris.ai RSpace™

Iris.ai RSpace™ es una solución AI que potencia la investigación

Fairgen

Fairgen es una plataforma de IA que mejora la investigación de mercado