StableBeluga2 es un modelo de lenguaje basado en Llama2 70B que ha sido afinado en un conjunto de datos de estilo Orca. Este modelo es desarrollado por Stability AI y está licenciado bajo la STABLE BELUGA NON-COMMERCIAL COMMUNITY LICENSE AGREEMENT.

Para comenzar a chatear con StableBeluga2, se puede utilizar el siguiente código: primero, se importan las librerías necesarias como torch y las clases AutoModelForCausalLM y AutoTokenizer de transformers. Luego, se crea el tokenizador y el modelo cargándolos con los parámetros adecuados, incluyendo la precisión de punto flotante y la asignación de memoria.

El formato de prompt que se debe utilizar con StableBeluga2 es el siguiente: se define un prompt del sistema que le indica al modelo cómo debe comportarse y luego se agrega el prompt del usuario. El modelo generará una respuesta basada en estos prompts.

StableBeluga2 tiene algunas limitaciones. Dado que es una tecnología nueva, no se pueden predecir con certeza sus salidas potenciales. Además, dado que las pruebas se han realizado principalmente en inglés, no se puede garantizar que funcione correctamente en otros idiomas o en todos los escenarios posibles. Por lo tanto, los desarrolladores deben realizar pruebas de seguridad y ajustes específicos para sus aplicaciones antes de implementar este modelo.

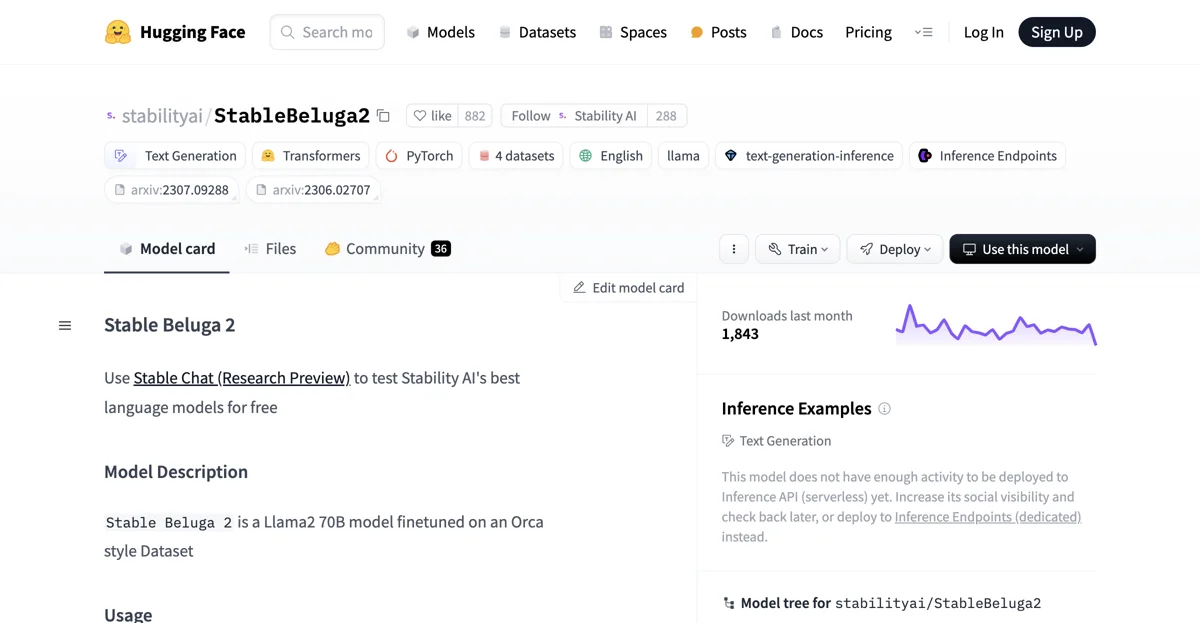

En cuanto a su uso, actualmente no tiene suficiente actividad para ser implementado en la API de Inferencia (sin servidor), pero se puede implementar en puntos finales de inferencia dedicados. También se pueden encontrar ejemplos de generación de texto con este modelo, aunque su actividad es limitada en este momento.

StableBeluga2 es uno de los modelos de lenguaje disponibles en Hugging Face, junto con otros modelos como StableBeluga1 - Delta, StableBeluga13B y StableBeluga7B. Cada uno de estos modelos tiene sus propias características y limitaciones, y los desarrolladores deben elegir el modelo más adecuado para sus necesidades específicas.