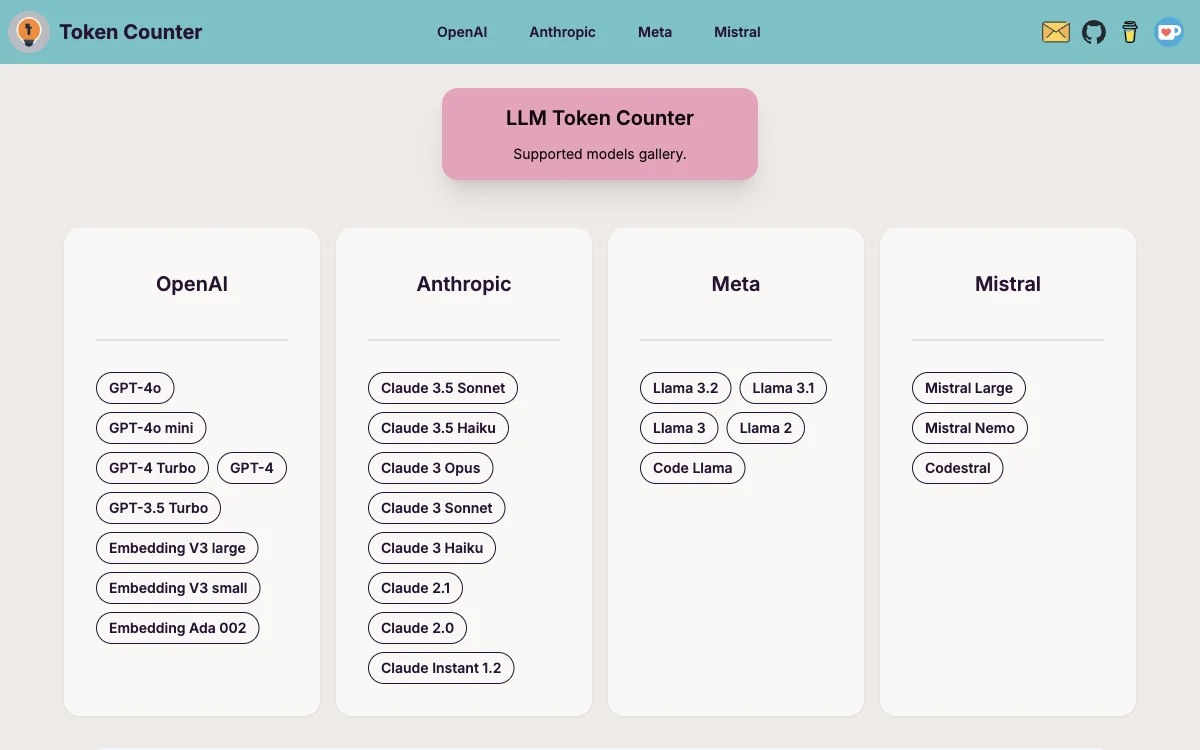

LLM Token Counter est un outil avancé spécialement conçu pour aider les utilisateurs à gérer les limites de tokens pour une variété de modèles de langage largement utilisés, y compris GPT-3.5, GPT-4, Claude-3, Llama-3, et bien d'autres. Cet outil est essentiel pour s'assurer que le nombre de tokens de votre prompt reste dans les limites spécifiées, évitant ainsi des sorties inattendues ou indésirables du modèle de langage.

Le fonctionnement de LLM Token Counter repose sur l'utilisation de Transformers.js, une implémentation JavaScript de la célèbre bibliothèque Hugging Face Transformers. Les tokenizers sont chargés directement dans votre navigateur, permettant le calcul du nombre de tokens côté client. Grâce à l'implémentation efficace en Rust de la bibliothèque Transformers, le calcul du nombre de tokens est remarquablement rapide.

Un aspect crucial de LLM Token Counter est qu'il garantit la confidentialité de vos prompts. Le calcul du nombre de tokens étant effectué côté client, vos données restent sécurisées et confidentielles. Votre vie privée est d'une importance primordiale, et cette approche assure que vos informations sensibles ne sont jamais transmises au serveur ou à une entité externe.

LLM Token Counter s'engage à élargir continuellement les modèles pris en charge et à améliorer les capacités de l'outil pour vous offrir une expérience optimale dans l'utilisation de la technologie d'IA générative. Si vous avez besoin d'assistance ou si vous avez des suggestions pour des fonctionnalités supplémentaires, n'hésitez pas à contacter via email.