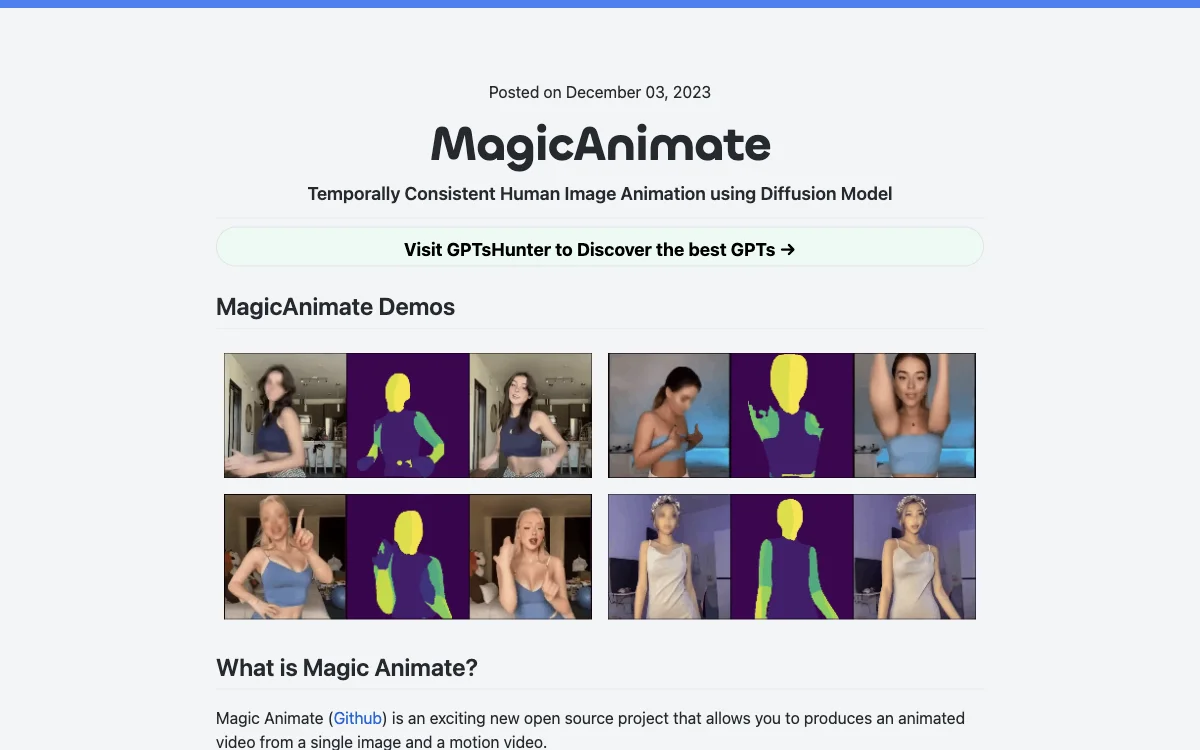

MagicAnimate est un projet open source innovant qui permet de créer des vidéos animées à partir d'une seule image et d'une vidéo de mouvement. Développé par Show Lab, l'Université Nationale de Singapour et Bytedance, cet outil utilise un cadre de diffusion de pointe pour l'animation d'images humaines. Il excelle dans le maintien de la cohérence temporelle, la préservation fidèle de l'image de référence et l'amélioration significative de la fidélité de l'animation.

MagicAnimate se distingue par sa capacité à animer des images de référence avec des séquences de mouvement provenant de diverses sources, y compris des animations cross-ID et des domaines inédits comme les peintures à l'huile et les personnages de films. Il s'intègre également de manière transparente avec les modèles de diffusion T2I comme DALLE3, donnant vie à des images suggérées par du texte avec des actions dynamiques.

Parmi les avantages de MagicAnimate, on note actuellement la plus grande cohérence parmi toutes les solutions de vidéos de danse. Cependant, il présente quelques inconvénients, comme une certaine distorsion au niveau du visage et des mains, et un changement de style de l'anime au réalisme dans sa configuration par défaut.

Pour commencer à utiliser MagicAnimate, il est nécessaire de télécharger les modèles de base pré-entraînés pour StableDiffusion V1.5 et MSE-finetuned VAE, ainsi que les checkpoints de MagicAnimate. L'installation nécessite python>=3.8, CUDA>=11.3, et ffmpeg. Des démonstrations en ligne sont disponibles sur Huggingface et Replicate, et il est possible de l'essayer sur Colab en suivant les instructions spécifiques.

MagicAnimate offre également une API via Replicate pour générer des vidéos animées, permettant une intégration facile dans des projets existants. Pour générer ou convertir des vidéos en vidéos de mouvement, OpenPose est recommandé comme bibliothèque de détection de points clés en temps réel pour l'estimation du corps, du visage, des mains et des pieds.