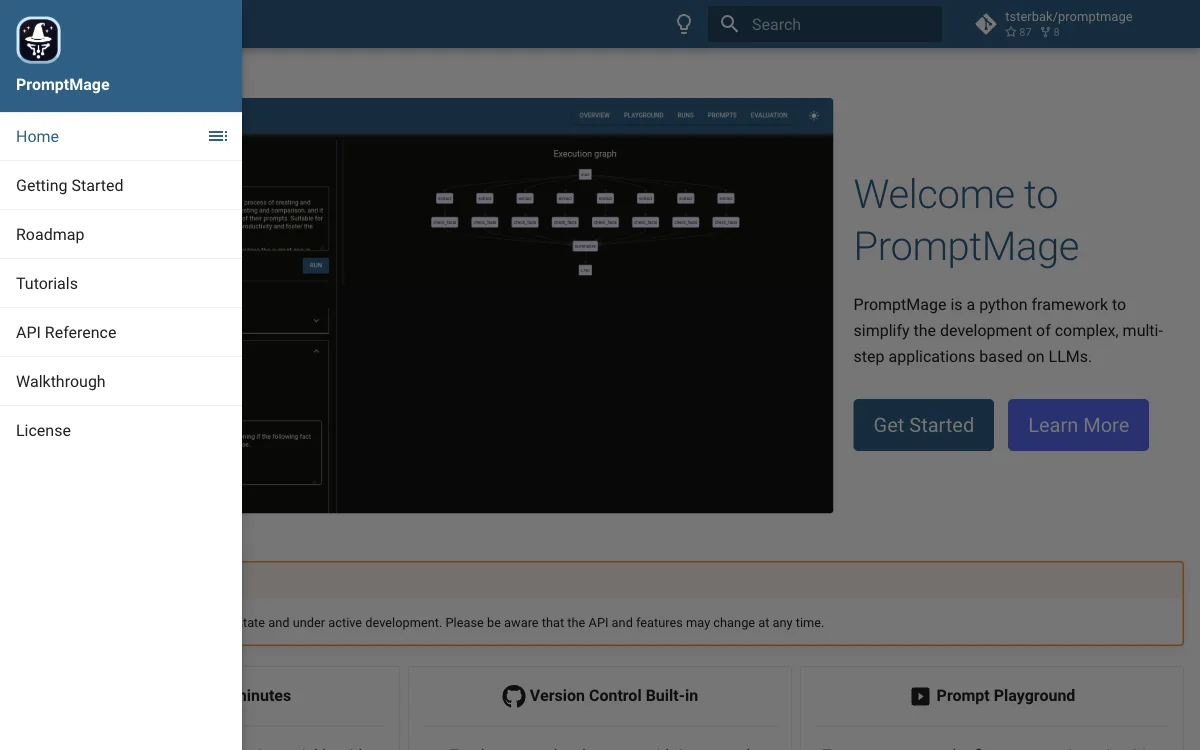

PromptMage se présente comme une solution innovante pour les développeurs et les chercheurs souhaitant exploiter la puissance des modèles de langage (LLM) dans des applications multi-étapes. Ce framework Python offre une interface intuitive qui facilite la création et la gestion des workflows LLM, en tant que solution auto-hébergée. Parmi ses fonctionnalités clés, on retrouve un terrain de jeu pour tester, comparer et affiner les prompts, ainsi qu'un système de contrôle de version intégré pour suivre l'évolution des prompts.

L'objectif de PromptMage est de combler le fossé actuel dans la gestion des workflows LLM, en offrant une solution pragmatique qui améliore la productivité et favorise l'utilisation pratique de la technologie LLM. Que ce soit pour de petites équipes ou de grandes entreprises, PromptMage vise à rendre la technologie LLM plus accessible et gérable, soutenant ainsi la prochaine vague d'innovations en IA.

Le framework inclut également une API générée automatiquement, propulsée par FastAPI, pour une intégration et un déploiement faciles. De plus, il propose un mode d'évaluation pour tester la performance des prompts, assurant leur fiabilité avant le déploiement. Avec son approche centrée sur les prompts comme citoyens de première classe, PromptMage intègre des fonctionnalités de collaboration et de validation manuelle et automatique des prompts, facilitant le partage des résultats avec les experts du domaine et les parties prenantes.

En résumé, PromptMage est un outil essentiel pour ceux qui cherchent à maximiser l'efficacité et l'impact de leurs applications basées sur LLM, en offrant une plateforme complète pour le développement, le test et le déploiement de workflows complexes.