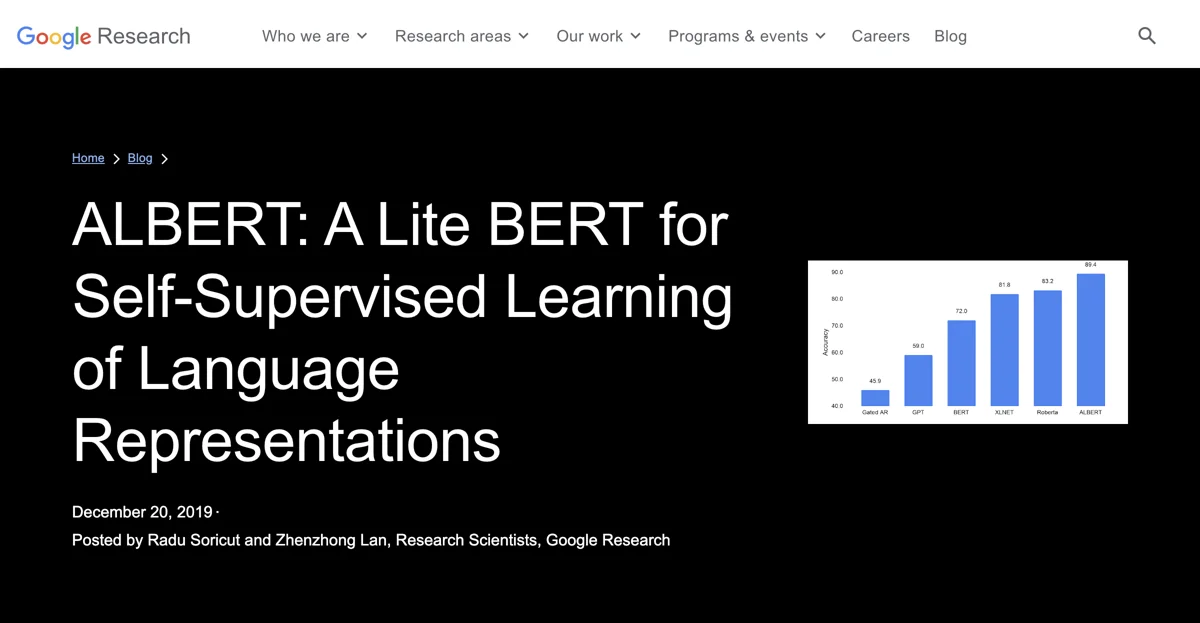

ALBERT, sviluppato da Google Research, è un modello innovativo per l'elaborazione del linguaggio naturale. Ha diverse caratteristiche chiave: condivisione efficiente dei parametri, che riduce la dimensione del modello senza compromettere le performance; sfrutta embedding contestuali per cogliere le sfumature del linguaggio. Ha stabilito nuovi standard in vari compiti di NLP come SQuAD v2.0 e RACE. È versatile e può essere usato in diverse applicazioni come risposta a domande, classificazione del testo e analisi del sentiment. È disponibile come open-source su TensorFlow. Rispetto ad altri modelli, si distingue per l'efficienza. Per massimizzarne i benefici, si suggerisce il fine-tuning e l'esperimento con diverse configurazioni. ALBERT è un passo importante nell'evoluzione dei modelli di linguaggio, promuovendo l'innovazione e la collaborazione.

ALBERT

Scopri come ALBERT, un modello Lite BERT, rivoluziona l'NLP con una gestione efficiente dei parametri e embedding contestuali.

Migliori alternative a ALBERT

Boba

Boba è un assistente AI che ti aiuta a esplorare tendenze e generare intuizioni strategiche.

Looppanel

Looppanel è uno strumento di ricerca UX potenziato dall'AI che centralizza le intuizioni degli utenti per un'analisi super veloce.

Convo

Convo è una piattaforma di ricerca qualitativa moderata e analizzata dall'AI che facilita le interviste su larga scala.

DiveDeck.AI

DiveDeck.AI è uno strumento di ricerca potenziato dall'AI che ti aiuta a raccogliere e esplorare informazioni in modo super efficiente.

OctopusAI

OctopusAI è una piattaforma AI che spacca con più modelli e zero limiti!

TopicMojo

TopicMojo è uno strumento potente di ricerca di argomenti e domande che semplifica la creazione di contenuti

Wordware

Wordware è un potente toolkit AI per costruire e gestire stack AI

Human or AI Game

Human or AI Game: sfida gli utenti a individuare contenuti umani o generati dall'IA

LowTech AI

LowTech AI è un potente strumento AI con tante funzionalità per aumentare la produttività

SEO Title Generator

Il SEO Title Generator crea titoli accattivanti con analisi dati

Locus

Locus è un motore di ricerca AI che migliora la produttività

Lobe

Lobe è un tool per l'apprendimento automatico che facilita l'allenamento di modelli

KitchenAI

KitchenAI è un tool LLMOps open source che aiuta nell'organizzazione e sviluppo dell'IA

UserCall

UserCall è un tool AI per interviste vocali 1:1 che offre approfondimenti utente

Breve AI

Breve AI è un potente strumento per creare e collaborare

The Full Stack

The Full Stack offre corsi di AI per costruire prodotti

Fydback

Fydback è un tool con AI che dà un boost alle performance del team

Frontier Model Forum

Il Frontier Model Forum spacca in fatto di promuovere la sicurezza dell'AI e la collaborazione

Graphite Note

Graphite Note è un tool AI che permette agli analisti di dati di creare modelli ML in un batter d'occhio, senza bisogno di codificare.

Grably

Grably è il top per i dati AI: offre set diversificati e subito disponibili

techtrust.ai

techtrust.ai è un servizio con potenziale Alpha in AI