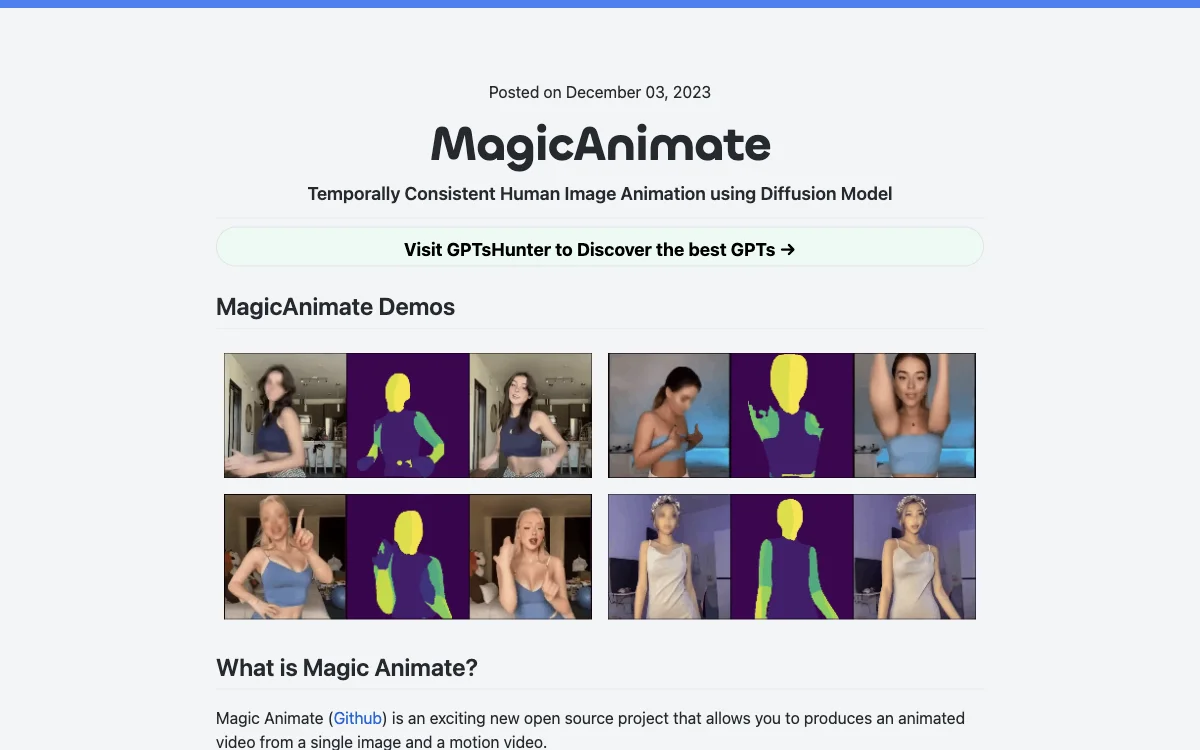

MagicAnimate è un progetto open source di Show Lab, National University of Singapore e Bytedance. Permette di creare un video animato partendo da una singola immagine e un video di movimento, basandosi sulla diffusione per l'animazione di immagini umane. Offre maggiore consistenza nelle soluzioni di video di danza, ma presenta alcune distorsioni nel viso e nelle mani e lo stile può variare. Per iniziare, bisogna scaricare i modelli base pre-allenati per StableDiffusion V1.5 e VAE ottimizzato con MSE e i checkpoint di MagicAnimate. I prerequisiti di installazione sono python >= 3.8, CUDA >= 11.3 e ffmpeg, e l'installazione può avvenire con conda. È possibile provare la demo online su Huggingface, Replicate o Colab e usare l'API di Replicate per generare video animati. Per generare o convertire un video di movimento, si può usare OpenPose. Altre informazioni sono disponibili nell'introduzione ufficiale, nel paper su arXiv, nel codice GitHub e nella demo.

MagicAnimate

MagicAnimate offre un modo innovativo per creare video animati, ma presenta alcune sfide. Scopri di più!

Migliori alternative a MagicAnimate

Skyglass

Skyglass è uno studio VFX potenziato dall'IA che aiuta i creatori di contenuti a dare vita alle loro storie visive.

Vid.AI

Vid.AI è un tool di video generation basato su IA che ti permette di creare shorts virali senza fatica.

Mochi 1 AI

Mochi 1 AI è un generatore video AI che trasforma testi in video di alta qualità.

AKOOL

AKOOL è una piattaforma AI super innovativa che rende il marketing e la creazione di contenuti un gioco da ragazzi.

PlayPlay

PlayPlay è una piattaforma di creazione video alimentata da AI che aiuta le aziende a realizzare video coinvolgenti in modo semplice.

Immersive Fox

Immersive Fox è un generatore di video AI che crea video personalizzati da testi in pochi minuti.

Luma Dream Machine AI

Luma Dream Machine AI è un potente generatore di video AI che spacca! Produce output di alta qualità in fretta

Focal

Focal è un software di creazione video con l'AI che ti permette di raccontare storie da urlo!

VideoToPage

VideoToPage è uno strumento alimentato dall'AI che trasforma i video in diverse forme di contenuto

Dream Machine AI

Dream Machine AI è un potente strumento per creare video realistici

DiverseShot AI

DiverseShot AI trasforma i video in esperienze 3D alla grande!

VeedoAI

VeedoAI è un tool AI per video super figo con tante funzionalità

aicut

aicut è un super tool di creazione video AI che spacca per far decollare il tuo canale

FancyTech

FancyTech è un potente strumento di creazione di contenuti AI che semplifica la produzione di video e immagini.

MemenomeLM

MemenomeLM è un tool che trasforma PDF in video coinvolgenti

Create Video

Create Video è un strumento per realizzare video virali

AutomateClips

AutomateClips è un fighissimo generatore di video AI per varie piattaforme

Renderfire

Renderfire è un super tool di video AI che crea e pubblica video in modo automatico come un fulmine!

Adori

Adori è un convertitore AI che trasforma blog in video

Cleaveer

Cleaveer è un strumento che trasforma video in vari contenuti

Overvoice

Overvoice è un'app che semplifica la creazione di voiceover e migliora il tasso di conversione