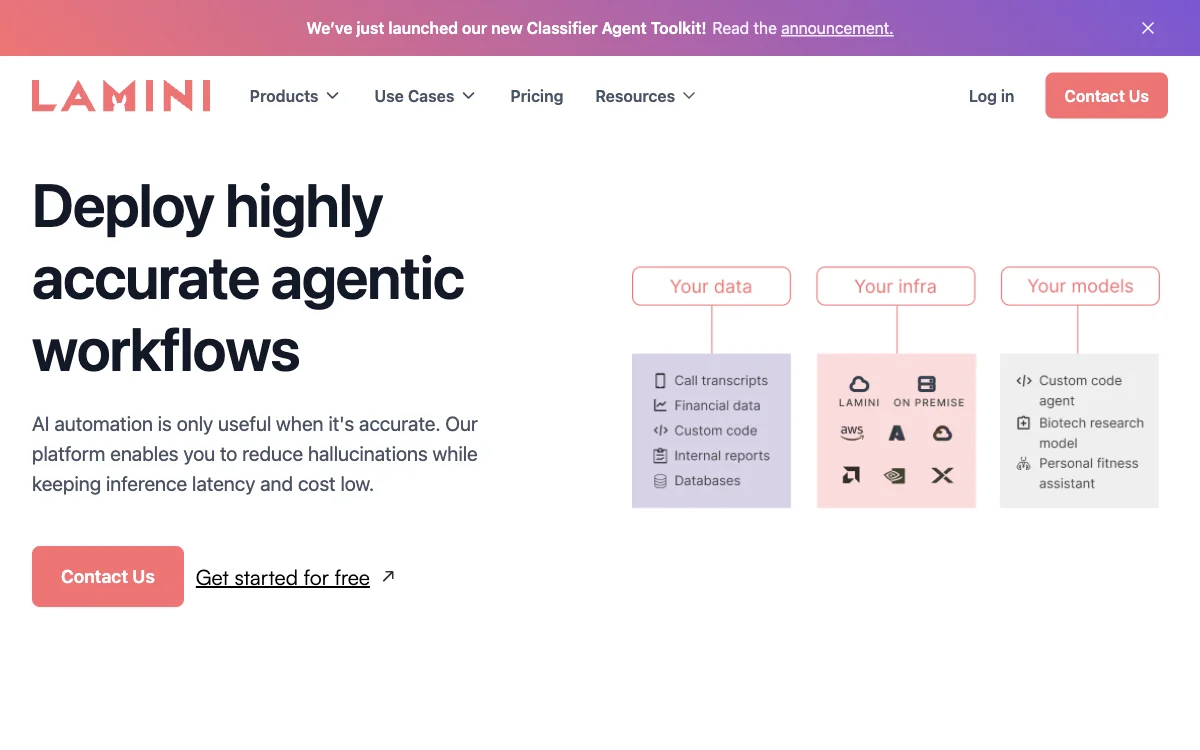

Laminiは、企業が高精度のLLM(大規模言語モデル)とエージェントを構築し、リスクを低減するためのプラットフォームです。このプラットフォームは、推論の遅延とコストを低く保ちながら、幻覚を減らすことを可能にします。Laminiを使用することで、企業はドメインやタスク固有のSLM(小規模言語モデル)を構築し、一般的な目的のLLMよりも精度とコストの面で優れたパフォーマンスを発揮することができます。

Laminiの主な機能には、メモリチューニング、メモリRAG、分類エージェントツールキットなどがあります。メモリチューニングは、推論の遅延とコストを低く保ちながら、最高レベルの精度を提供します。メモリRAGは、複雑なRAGシステムに悩まされることなく、精度を向上させ、プロセスを合理化します。分類エージェントツールキットは、手動のデータラベリングを置き換え、大規模な非構造化データを任意の数のカテゴリで分類することを可能にします。

Laminiは、クラウドやオンプレミス、さらにはエアギャップ環境でも安全に展開できるため、データのプライバシーが保たれます。このプラットフォームは、Fortune 500企業や主要なスタートアップに信頼されており、コンテンツ分類の100%の精度と年間1200時間以上の手作業の削減を実現しています。

Laminiを使用することで、企業は高精度のLLMアプリケーションを本番環境で実行するリスクを低減し、顧客サービスエージェントのスケーリングや、チームが迅速に必要な答えを見つけるための機能呼び出しの生産性向上を実現できます。