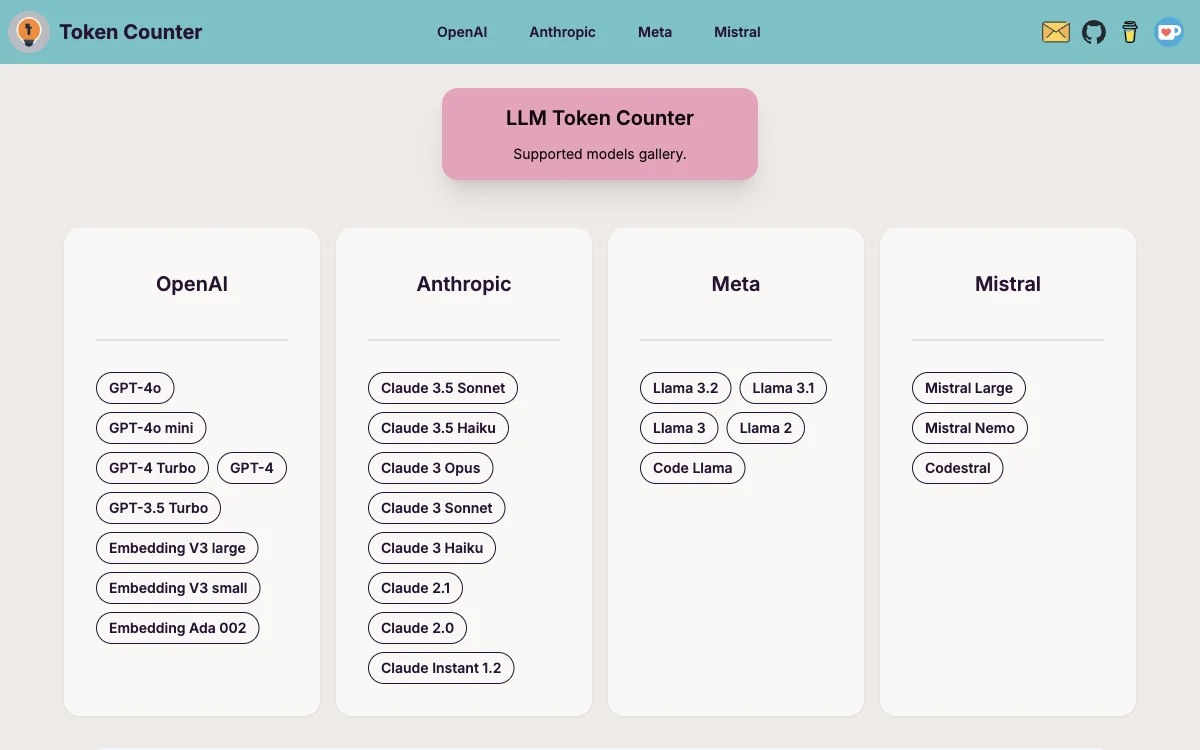

LLM Token Counterは、OpenAIのGPT-4o、GPT-4o mini、GPT-4 Turbo、GPT-4、GPT-3.5 Turbo、Embedding V3 large、Embedding V3 small、Embedding Ada 002、AnthropicのClaude 3.5 Sonnet、Claude 3.5 Haiku、Claude 3 Opus、Claude 3 Sonnet、Claude 3 Haiku、Claude 2.1、Claude 2.0、Claude Instant 1.2、MetaのLlama 3.2、Llama 3.1、Llama 3、Llama 2、Code Llama、MistralのMistral Large、Mistral Nemo、Codestralなど、多様な言語モデル(LLMs)のトークン制限を管理するために設計された洗練されたツールです。

LLM Token Counterは、ユーザーが生成AI技術を活用する際に最適な体験を提供するために、サポートされるモデルの拡張とツールの機能強化に努めています。このツールは、Transformers.jsを使用して動作します。これは、有名なHugging Face TransformersライブラリのJavaScript実装です。トークナイザーはブラウザ内で直接ロードされ、トークン数の計算がクライアント側で行われます。Transformersライブラリの効率的なRust実装のおかげで、トークン数の計算は非常に高速です。

LLM Token Counterを使用する理由は、LLMsの固有の制限により、プロンプトのトークン数が指定されたトークン制限内に収まることが重要だからです。この制限を超えると、LLMからの出力が予期せぬものや望ましくないものになる可能性があります。

また、LLM Token Counterを使用することで、プロンプトが漏洩することはありません。トークン数の計算はクライアント側で行われるため、プロンプトは安全かつ機密に保たれます。データのプライバシーは最も重要であり、このアプローチにより、機密情報がサーバーや外部のエンティティに送信されることはありません。