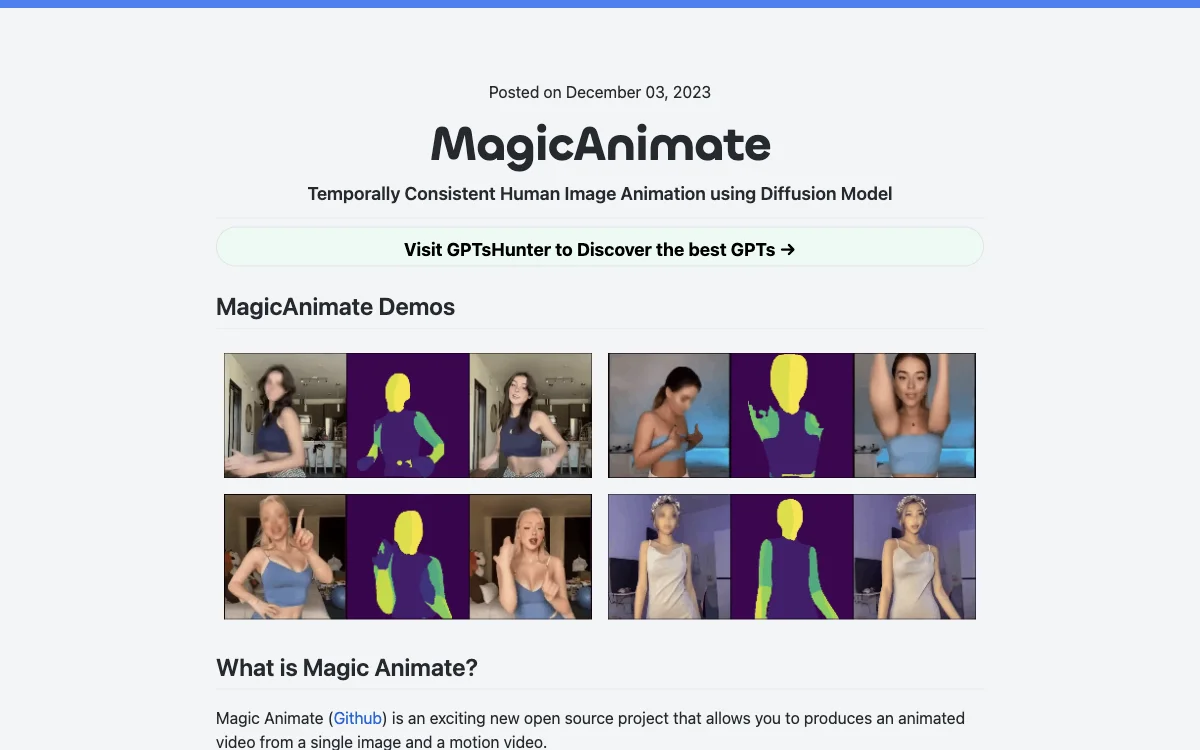

MagicAnimateは、拡散モデルを基にした人間の画像アニメーションのための最先端のフレームワークです。この革新的なツールは、時間的な一貫性を維持し、参照画像を忠実に保存し、アニメーションの忠実度を大幅に向上させることに優れています。MagicAnimateは、クロスIDアニメーションや油絵、映画のキャラクターなど、さまざまなソースからのモーションシーケンスで参照画像をアニメーション化する能力で際立っています。また、DALLE3のようなT2I拡散モデルとシームレスに統合し、テキストプロンプトによる画像をダイナミックなアクションで生き生きとさせます。

MagicAnimateは、シンガポール国立大学とBytedance(字节跳动)のShow Labによって開発されました。現在、すべてのダンスビデオソリューションの中で最高の一貫性を提供しています。しかし、顔や手にいくらかの歪みが生じることがあるという欠点もあります。デフォルトの設定では、アニメからリアリズムへのスタイルの変化が特にビデオの顔に顕著に見られ、これはチェックポイントの変更を必要とするかもしれません。

MagicAnimateの使用を開始するには、StableDiffusion V1.5とMSE-finetuned VAEの事前訓練済みベースモデルをダウンロードしてください。また、MagicAnimateのチェックポイントもダウンロードする必要があります。インストールの前提条件として、python>=3.8、CUDA>=11.3、およびffmpegが必要です。condaを使用してインストールすることができます。

MagicAnimateのオンラインデモは、Hugging FaceやReplicateで試すことができます。また、Colab上でMagicAnimateを実行する方法も提供されています。Replicate APIを使用してアニメーションビデオを生成することも可能です。

モーションビデオを生成するか、ビデオをモーションビデオに変換するには、OpenPoseを使用することができます。OpenPoseは、身体、顔、手、足の推定のためのリアルタイム多人数キーポイント検出ライブラリです。ビデオをOpenPoseに変換した後、magic-animate-openposeモデルを使用してMagicAnimateとOpenPoseを使用することができます。