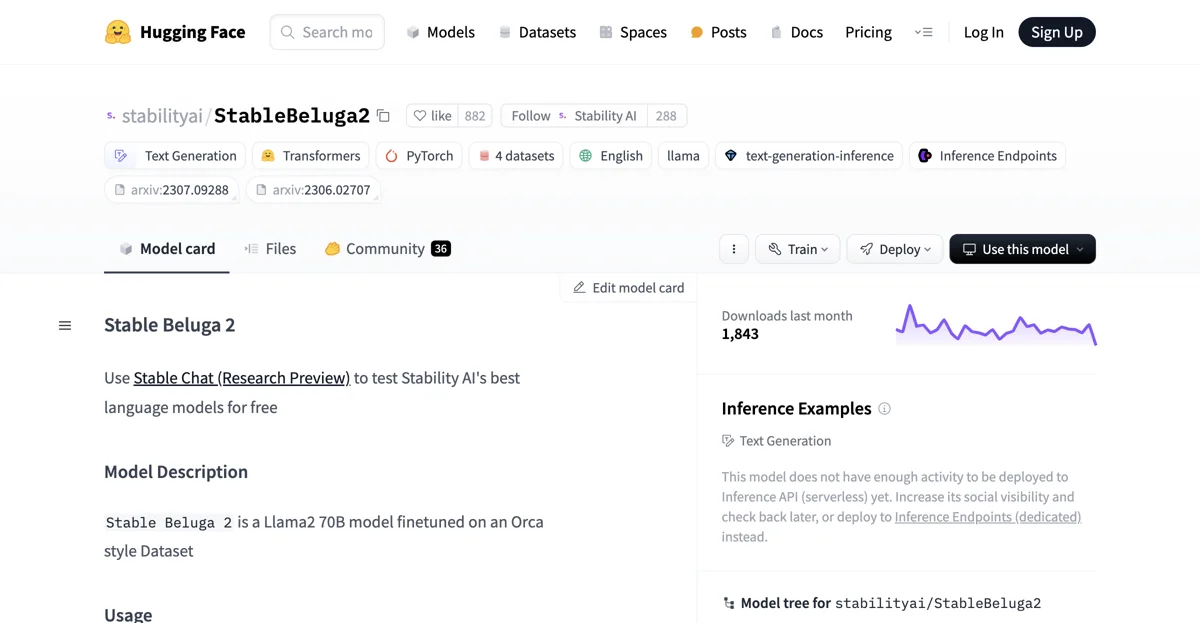

StableBeluga2は、Llama2 70Bをベースにした自動回帰型言語モデルです。このモデルは、Orcaスタイルのデータセットで微調整されており、主に英語でのテキスト生成に使用されます。

モデルの使用方法は比較的簡単です。まず、必要なライブラリをインポートします。例えば、以下のコードです。

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer, pipeline

# トークナイザーとモデルのロード

tokenizer = AutoTokenizer.from_pretrained("stabilityai/StableBeluga2", use_fast=False)

model = AutoModelForCausalLM.from_pretrained("stabilityai/StableBeluga2", torch_dtype=torch.float16, low_cpu_mem_usage=True, device_map="auto")

次に、システムプロンプトとユーザーのメッセージを設定し、それをモデルに入力して生成結果を得ます。例えば、詩を生成する場合のコードは以下のようになります。

# システムプロンプトとメッセージの設定

system_prompt = "### System:\nYou are Stable Beluga, an AI that follows instructions extremely well. Help as much as you can. Remember, be safe, and don't do anything illegal.\n\n"

message = "Write me a poem please"

prompt = f"{system_prompt}### User: {message}\n\n### Assistant:\n"

# 入力の処理とモデルの生成

inputs = tokenizer(prompt, return_tensors="pt").to("cuda")

output = model.generate(**inputs, do_sample=True, top_p=0.95, top_k=0, max_new_tokens=256)

print(tokenizer.decode(output[0], skip_special_tokens=True))

このモ�德は、特定のプロンプト形式で使用する必要があります。例えば、以下の形式です。

### System: This is a system prompt, please behave and help the user.

### User: Your prompt here

### Assistant: The output of Stable Beluga 2

StableBeluga2は、開発者にとっても注意点があります。これは新しい技術であり、使用に伴うリスクがあります。現時点でのテストは主に英語で行われており、全てのシナリオを網羅することはできません。そのため、他の大規模言語モデルと同様、ユーザーのプロンプトに対する応答が予測できない場合があり、時には不正確、バイアスがある、または他の不適切な応答を生成する可能性があります。そのため、このモデルをアプリケーションに展開する前に、開発者は自身の特定のアプリケーションに合わせて安全性のテストと調整を行う必要があります。

また、このモデルのライセンスは、STABLE BELUGA NON-COMMERCIAL COMMUNITY LICENSE AGREEMENTです。モデルに関する質問やコメントがある場合は、にメールで連絡することができます。

このモデルのダウンロード数は先月1,843回でした。また、現時点ではInference API(サーバーレス)に展開するには活動量が足りないため、その社会的な可視性を高めてから再度確認するか、Inference Endpoints(専用)に展開することをお勧めします。