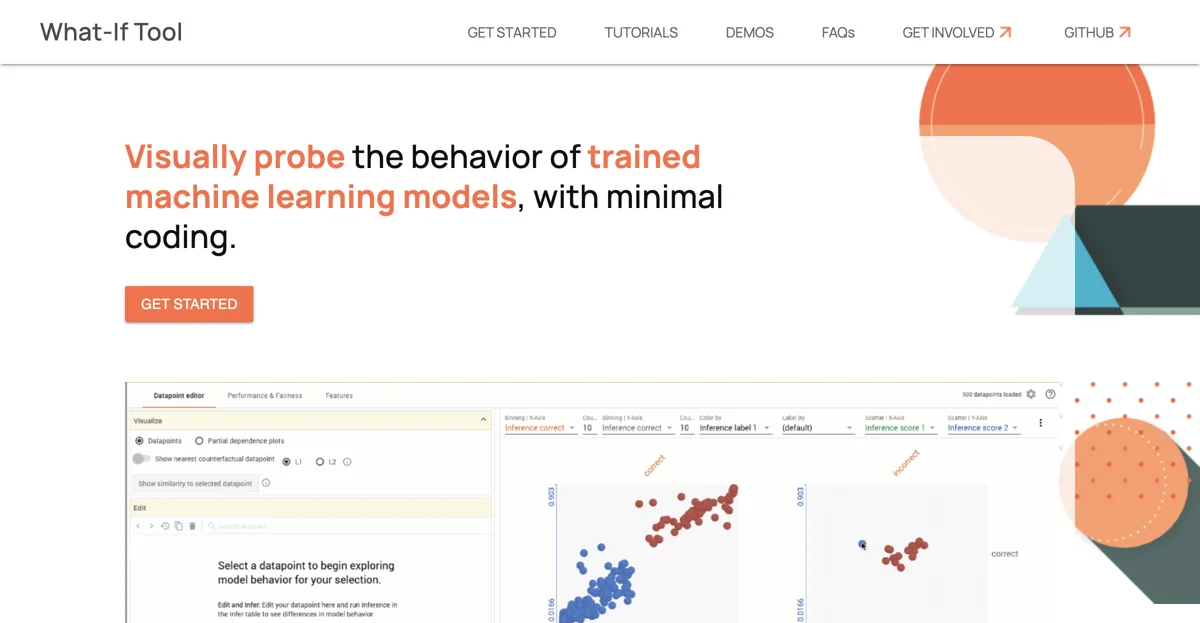

What-If Toolは、機械学習(ML)システムの開発と展開における重要な課題である、幅広い入力にわたるパフォーマンスの理解を支援します。このツールを使用することで、仮想状況でのパフォーマンスをテストし、異なるデータ特徴の重要性を分析し、複数のモデルと入力データのサブセットにわたるモデルの動作を視覚化し、異なるML公平性メトリクスを評価することができます。

What-If Toolは、Colaboratoryノートブック、Jupyterノートブック、Cloud AI Notebooks、TensorBoard、TFMA Fairness Indicatorsなど、さまざまなプラットフォームと統合されています。また、TF Estimatorsモデル、TF servingによって提供されるモデル、Cloud AI Platformモデル、Python関数でラップできるモデルなど、互換性のあるモデルとフレームワークをサポートしています。

このツールは、二値分類、多クラス分類、回帰、表形式データ、画像、テキストデータなど、さまざまなデータとタスクタイプに対応しています。モデル、特徴、データポイントに関する質問をし、答えを得ることができます。

What-If Toolは、その開発と改善に貢献したい人なら誰でも参加できるオープンなプロジェクトです。開発者ガイドを参照して、最新のコードに貢献してください。また、What-If Toolの最新のアップデート、新機能、改善点については、リリースノートをご覧ください。

IEEE VAST '19で発表されたシステムペーパーでは、What-If Toolの開発に何が込められたかを読むことができます。さらに、What-If Toolを使用して、5種類の公平性を試すことができる記事も提供されています。Google Researchの記事を読んで、それらが何を意味するのかを理解してください。