ALBERT: A Lite BERT for Self-Supervised Learning of Language Representations

소개

ALBERT는 자연어 처리(NLP) 분야에서의 성능을 향상시키기 위해 설계된 경량화된 BERT 모델입니다. 이 모델은 기존의 BERT 모델을 기반으로 하여, 더 적은 매개변수로도 뛰어난 성능을 발휘할 수 있도록 최적화되었습니다.

주요 특징

- 매개변수 공유: ALBERT는 네트워크의 여러 층에서 매개변수를 공유하여 모델의 크기를 줄이고, 학습 효율성을 높입니다.

- 임베딩 파라미터 분해: 입력 레벨 임베딩과 숨겨진 레이어 임베딩을 분리하여, 더 나은 문맥 의존적 표현을 학습합니다.

- 성능 향상: ALBERT는 SQuAD v2.0 및 RACE 벤치마크에서 기존 BERT 모델보다 더 높은 성능을 기록했습니다.

사용 사례

ALBERT는 다양한 자연어 처리 작업에 활용될 수 있습니다. 예를 들어, 질문 응답 시스템, 텍스트 요약, 감정 분석 등에서 효과적으로 사용될 수 있습니다.

가격

ALBERT는 오픈 소스로 제공되며, TensorFlow 위에서 구현되어 있습니다. 사용자는 무료로 ALBERT 모델을 다운로드하여 사용할 수 있습니다.

비교

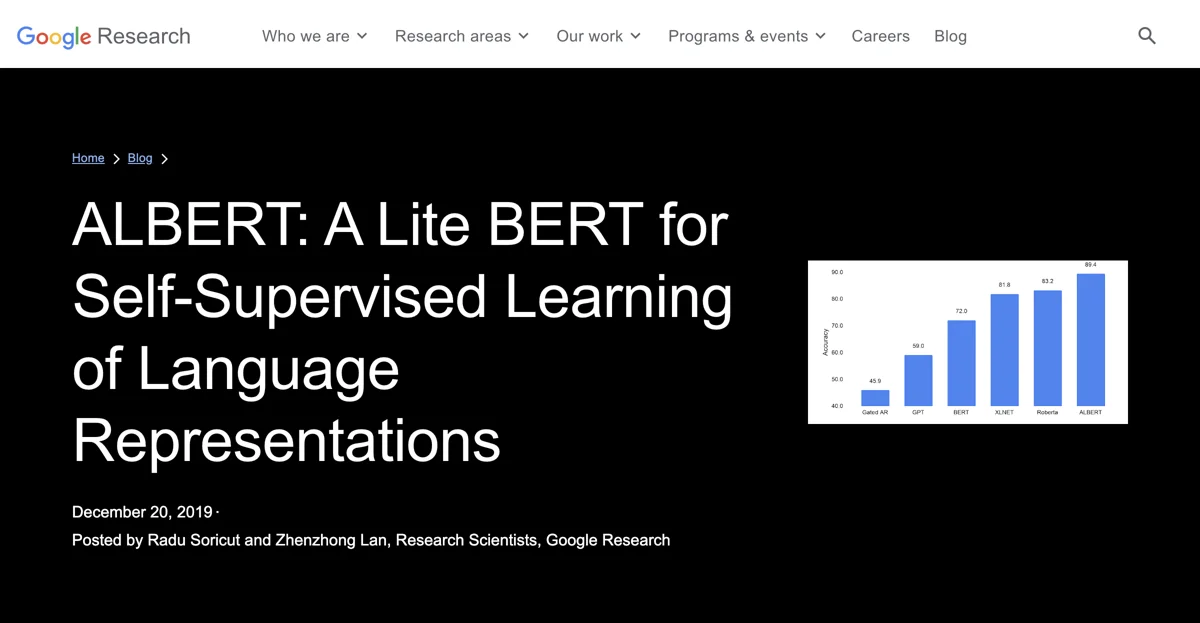

ALBERT는 BERT, XLNet, RoBERTa와 같은 다른 모델들과 비교할 때, 더 적은 매개변수로도 경쟁력 있는 성능을 보여줍니다. ALBERT-xxlarge 모델은 SQuAD2.0에서 88.1의 점수를 기록하며, RACE에서 82.3의 점수를 기록했습니다.

고급 팁

ALBERT를 사용할 때는 데이터 세트의 특성에 맞게 모델을 조정하는 것이 중요합니다. 또한, ALBERT의 매개변수 공유 기능을 활용하여 모델의 크기를 줄이는 것이 성능 향상에 기여할 수 있습니다.

결론

ALBERT는 자연어 처리 분야에서의 혁신을 이끌고 있으며, 연구 커뮤니티에 오픈 소스로 제공되어 더 많은 발전이 기대됩니다.