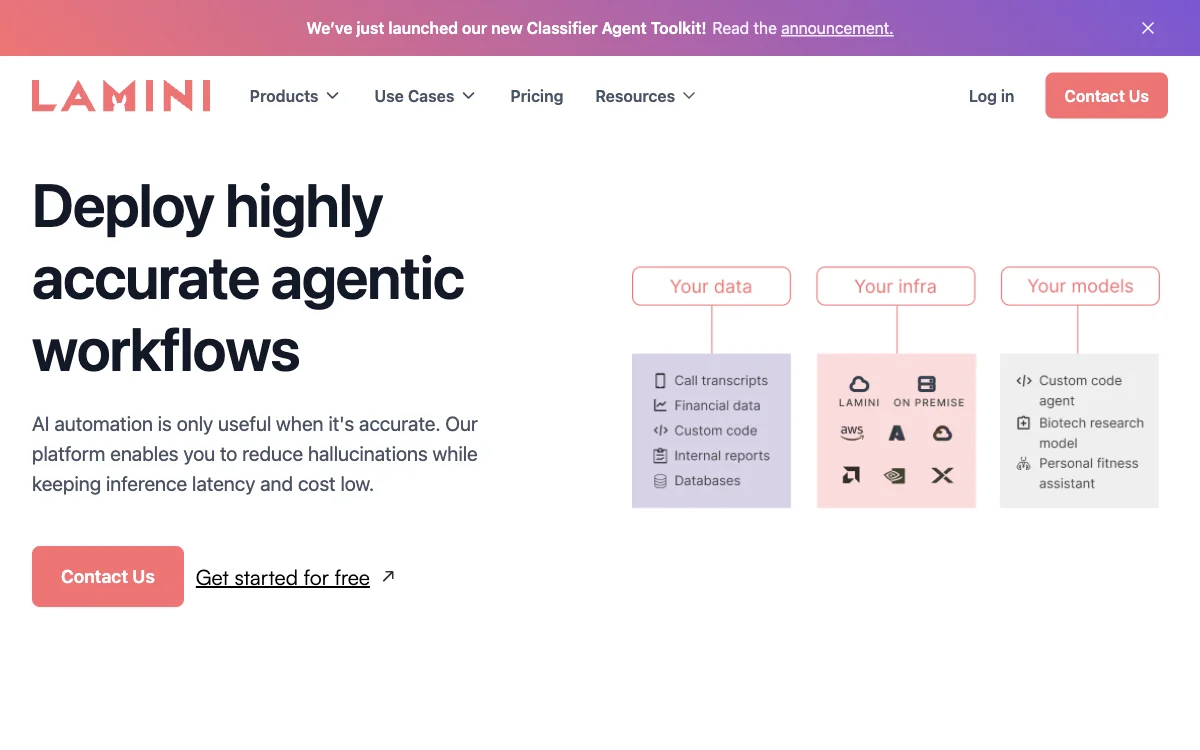

Lamini은 기업을 위한 차세대 AI 플랫폼으로, 고정확도 AI 에이전트 및 LLM(Large Language Models)을 구축할 수 있도록 지원합니다. 이 플랫폼은 환각 현상을 크게 줄이면서도 추론 지연 시간과 비용을 최소화하는 데 중점을 두고 있습니다. Lamini을 통해 기업은 도메인 및 작업 특화형 소형 언어 모델(SLM)을 구축하여 일반 목적의 LLM보다 더 높은 정확도와 비용 효율성을 달성할 수 있습니다.

Lamini 플랫폼의 주요 기능 중 하나는 Memory Tuning으로, 이는 추론 지연 시간과 비용을 낮추면서도 최고 수준의 정확도를 제공합니다. 또한, Memory RAG(Retrieval-Augmented Generation) 기능을 통해 복잡한 RAG 시스템의 문제를 해결하고, 정확도를 높이며 프로세스를 간소화합니다. 이는 구조화되지 않은 데이터에서 자동으로 구조화된 출력을 생성하고, 빠르고 효율적인 정보 검색을 가능하게 합니다.

Classifier Agent Toolkit은 Lamini의 또 다른 혁신적인 기능으로, 수동 데이터 라벨링을 대체할 수 있는 고확장성 및 고정확도의 LLM 기반 분류기를 제공합니다. 이를 통해 대량의 비정형 데이터를 어떤 수의 카테고리로도 분류할 수 있으며, 고객 서비스 요청을 의도에 따라 분류하고 적절한 부서로 라우팅하는 등의 작업을 자동화할 수 있습니다.

Lamini은 클라우드 또는 온프레미스, 심지어 에어갭(air-gapped) 환경에서도 안전하게 배포될 수 있어, 기업의 데이터 프라이버시를 보장합니다. 이 플랫폼은 Fortune 500 기업 및 선도적인 스타트업에 의해 신뢰받고 있으며, 콘텐츠 분류를 위한 100% 정확도와 연간 1200시간 이상의 수작업 절감 효과를 제공합니다.

Lamini은 기업이 생산 환경에서 LLM 애플리케이션을 실행함으로써 발생할 수 있는 위험을 줄이고, 고정확도 LLM 및 에이전트를 제공하여 비즈니스 가치를 극대화하는 데 기여합니다. 팩트 기반 추론, 분류, 텍스트-to-SQL, 코드 어시스턴트, 고객 서비스 에이전트, 기능 호출 등 다양한 사용 사례를 통해 기업의 생산성을 향상시키고 팀이 필요한 답변을 빠르게 찾을 수 있도록 지원합니다.