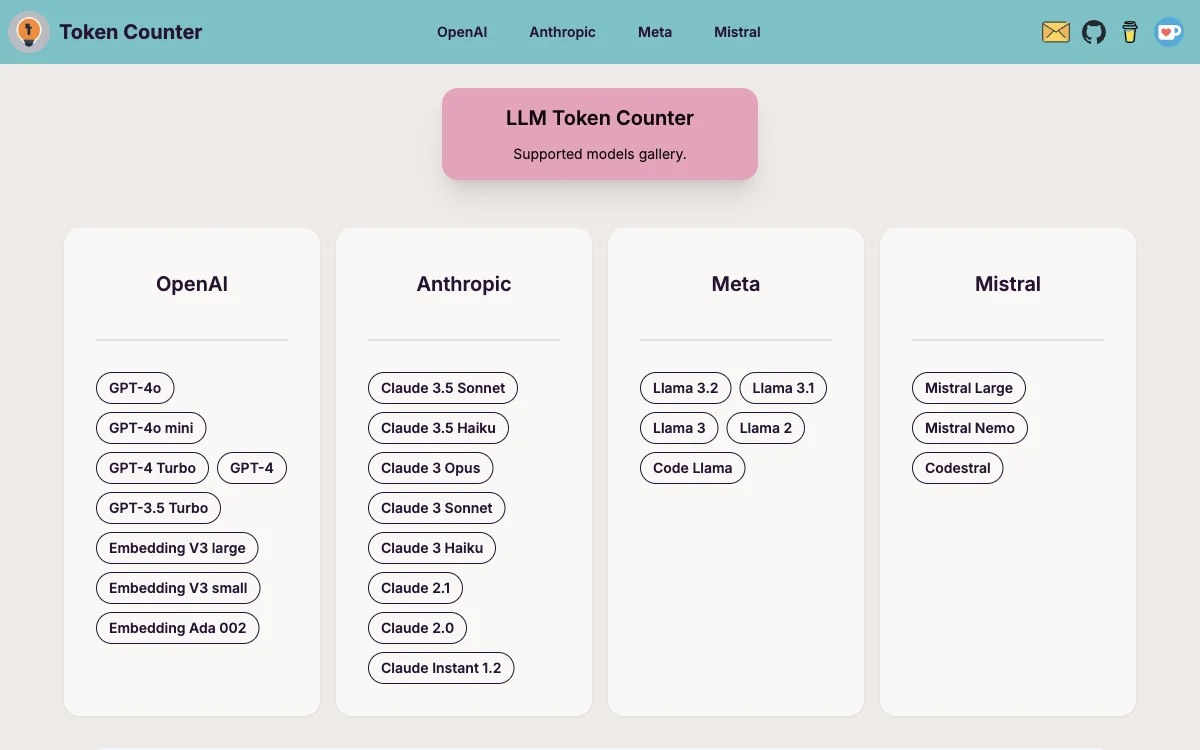

LLM Token Counter는 사용자가 널리 사용되는 다양한 언어 모델(Language Models, LLMs)의 토큰 제한을 효과적으로 관리할 수 있도록 설계된 정교한 도구입니다. 이 도구는 GPT-3.5, GPT-4, Claude-3, Llama-3 등을 포함한 다양한 모델을 지원하며, 지속적으로 지원 모델을 확장하고 도구의 기능을 강화하여 생성형 AI 기술을 최적으로 활용할 수 있도록 돕습니다.

LLM Token Counter를 사용하는 이유는 LLM의 고유한 제한으로 인해 프롬프트의 토큰 수가 지정된 토큰 제한 내에 있어야 하기 때문입니다. 이 제한을 초과하면 LLM에서 예상치 못한 또는 원하지 않는 출력이 발생할 수 있습니다.

LLM Token Counter는 Transformers.js를 사용하여 작동합니다. Transformers.js는 유명한 Hugging Face Transformers 라이브러리의 JavaScript 구현체로, 토크나이저가 브라우저에서 직접 로드되어 토큰 수 계산이 클라이언트 측에서 수행됩니다. Transformers 라이브러리의 효율적인 Rust 구현 덕분에 토큰 수 계산은 매우 빠릅니다.

프롬프트가 유출될 걱정은 없습니다. 토큰 수 계산은 클라이언트 측에서 수행되므로 프롬프트는 안전하고 기밀로 유지됩니다. 데이터 프라이버시는 최우선 사항이며, 이 접근 방식은 민감한 정보가 서버나 외부 기관으로 전송되지 않도록 보장합니다.