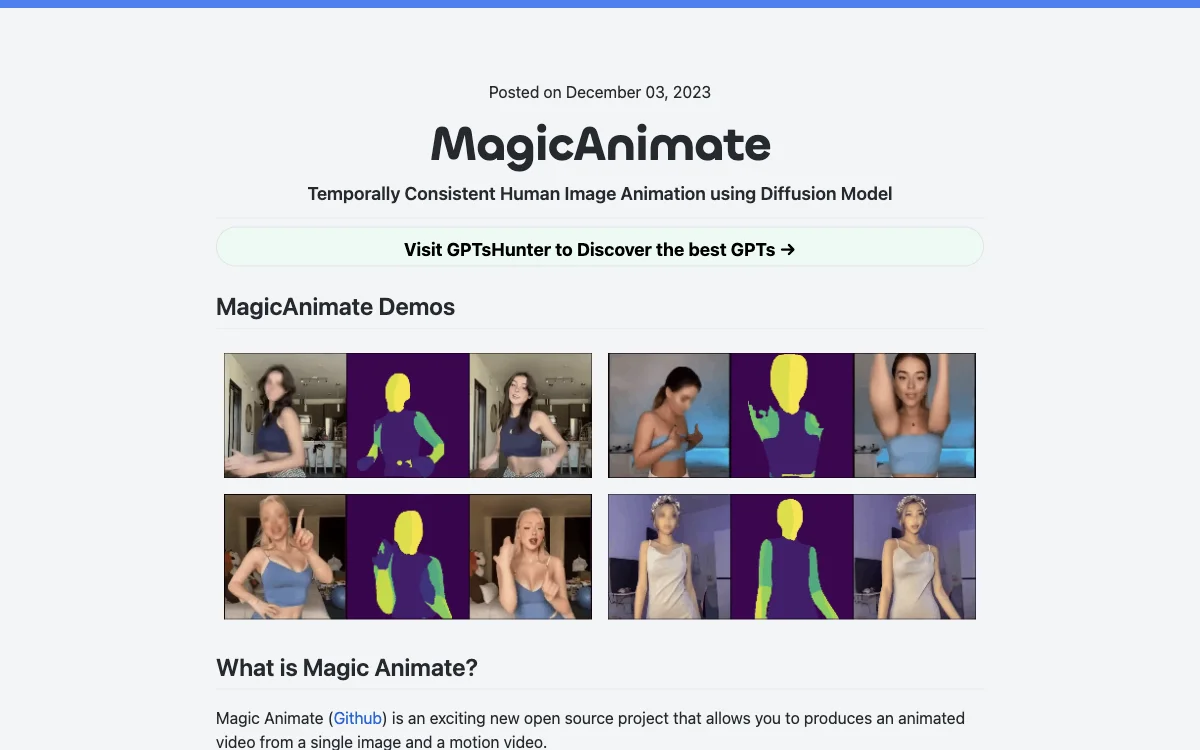

MagicAnimate는 최첨단 확산 모델을 기반으로 한 인간 이미지 애니메이션 프레임워크로, 시간적 일관성을 유지하며 참조 이미지를 충실히 보존하고 애니메이션의 충실도를 크게 향상시킵니다. 이 도구는 다양한 소스의 모션 시퀀스로 참조 이미지를 애니메이션화할 수 있으며, 크로스 ID 애니메이션 및 오일 페인팅, 영화 캐릭터와 같은 보이지 않는 도메인에서도 뛰어난 성능을 발휘합니다. 또한 DALLE3와 같은 T2I 확산 모델과 원활하게 통합되어 텍스트 프롬프트 이미지를 동적 액션으로 생동감 있게 만듭니다.

MagicAnimate는 싱가포르 국립대학교와 바이트댄스(字节跳动)의 Show Lab에 의해 개발되었습니다. 현재 이 도구는 모든 댄스 비디오 솔루션 중에서 가장 높은 일관성을 제공합니다. 그러나 얼굴과 손의 일부 왜곡 문제가 있으며, 기본 설정에서는 애니메이션 스타일에서 사실주의로의 스타일 변화가 특히 비디오의 얼굴에서 눈에 띄게 나타납니다. 이는 체크포인트 수정이 필요할 수 있습니다.

MagicAnimate를 시작하려면 StableDiffusion V1.5 및 MSE-finetuned VAE의 사전 훈련된 기본 모델을 다운로드해야 합니다. 또한 python>=3.8, CUDA>=11.3, ffmpeg가 설치되어 있어야 합니다. conda를 사용하여 설치할 수 있으며, Huggingface, Replicate, Colab에서 온라인 데모를 시도해 볼 수 있습니다. Replicate API를 사용하여 애니메이션 비디오를 생성할 수도 있습니다.

MagicAnimate는 OpenPose와 같은 실시간 다중 인물 키포인트 감지 라이브러리와 함께 사용할 수 있으며, 동영상을 OpenPose로 변환한 후 MagicAnimate와 함께 사용할 수 있습니다. MagicAnimate에 대한 더 많은 정보는 공식 GitHub 코드 및 arXiv 논문에서 확인할 수 있습니다.