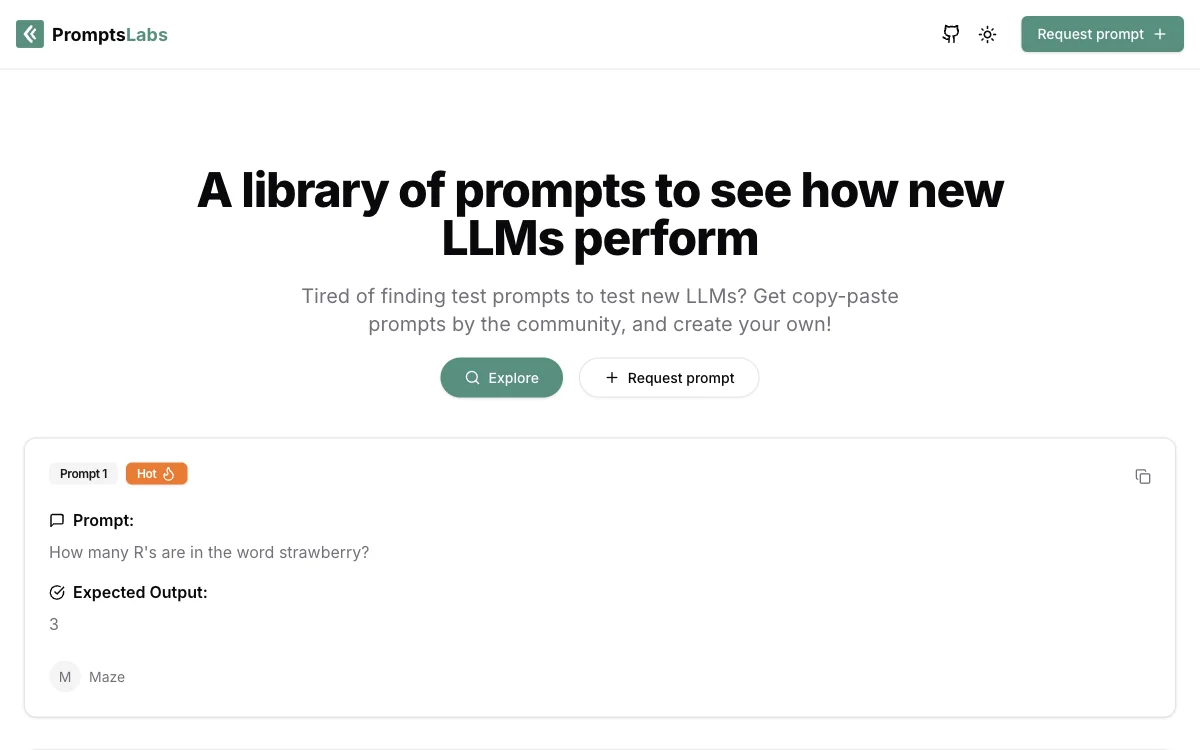

PromptsLabs는 개발자와 연구자들이 새로운 대형 언어 모델(LLM)의 성능을 테스트할 수 있도록 다양한 프롬프트를 제공하는 라이브러리입니다. 이 플랫폼은 커뮤니티로부터 수집된 프롬프트를 제공하며, 사용자들이 직접 프롬프트를 생성하고 공유할 수 있는 기능도 포함하고 있습니다. 이를 통해 사용자들은 복잡한 테스트 케이스를 준비할 필요 없이, 간단히 복사-붙여넣기 방식으로 다양한 LLM의 성능을 평가할 수 있습니다.

PromptsLabs는 다양한 주제와 난이도의 프롬프트를 제공하여, 사용자들이 LLM의 이해력, 추론 능력, 그리고 문제 해결 능력을 종합적으로 테스트할 수 있도록 돕습니다. 예를 들어, '딸기라는 단어에 몇 개의 R이 있나요?'와 같은 간단한 질문부터, '9.9와 9.11 중 어느 숫자가 더 큰가요?'와 같은 수학적 문제까지 다양한 프롬프트를 통해 LLM의 성능을 다각도로 평가할 수 있습니다.

이 플랫폼은 특히 새로운 LLM을 개발하거나 기존 모델의 성능을 개선하려는 연구자와 개발자들에게 유용한 도구입니다. PromptsLabs를 통해 사용자들은 LLM의 성능을 보다 쉽고 빠르게 평가할 수 있으며, 이를 통해 더 나은 언어 모델을 개발하는 데 기여할 수 있습니다.