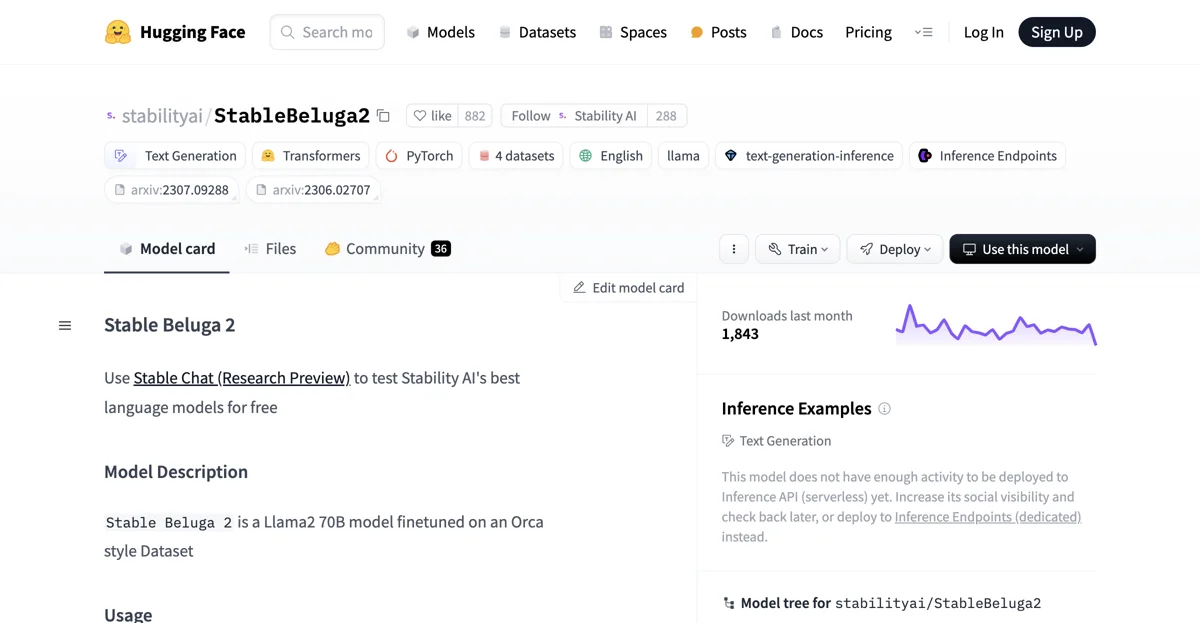

StableBeluga2는 Stability AI에서 개발한 자동 회귀 언어 모델로, Llama2 70B를 기반으로 만들어졌습니다. 이 모델은 Orca 스타일의 데이터셋을 사용하여 미세 조정되었으며, 주로 English 언어를 다룹니다. Hugging Face Transformers 라이브러리를 사용하여 구현되었으며, STABLE BELUGA NON-COMMERCIAL COMMUNITY LICENSE AGREEMENT에 따라 라이센스가 부여되어 있습니다.

사용 방법은 다음과 같습니다. 먼저必要한 라이브러리를 import 합니다. 예를 들어, import torch, from transformers import AutoModelForCausalLM, AutoTokenizer, pipeline와 같이입니다. 그리고 tokenizer와 model을 적절히 초기화합니다. tokenizer = AutoTokenizer.from_pretrained("stabilityai/StableBeluga2", use_fast=False)와 model = AutoModelForCausalLM.from_pretrained("stabilityai/StableBeluga2", torch_dtype=torch.float16, low_cpu_mem_usage=True, device_map="auto")와 같은 코드로요.

시스템 프롬프트를 설정하고, 사용자의 메시지를 받아 이를 토대로 StableBeluga2가 응답할 수 있도록 합니다. 예를 들어, system_prompt = "### System:\nYou are Stable Beluga, an AI that follows instructions extremely well. Help as much as you can. Remember, be safe, and don't do anything illegal.\n\n"와 같은 시스템 프롬프트를 설정할 수 있습니다. 그리고 사용자의 메시지가 message = "Write me a poem please"와 같다면, 이를 합쳐 prompt를 만들어 inputs로 변환한 후 model에 입력하여 출력을 받을 수 있습니다.

하지만 이 모델은 아직 Inference API에 배포하기에 충분한 활동량이 없으며, 이를 위해서는 사회적 가시성을 높이고 나중에 다시 확인하거나, Inference Endpoints에 배포하는 것이 좋습니다.

또한 StableBeluga2는 새로운 기술이므로 사용에 따른 위험도 가지고 있습니다. 현재까지의 테스트는 주로 English로 진행되었으며, 모든 시나리오를 커버할 수는 없습니다. 따라서 개발자는 이 모델을 배포하기 전에 안전 테스트와 튜닝을 수행해야 합니다.

다른 Beluga 모델들과 비교할 때도 StableBeluga2는 그 특별한 특징과 기능을 가지고 있습니다. 각 모델은 다른 용도와 조건에 맞게 개발되었으며, StableBeluga2는 그 중에서도 Llama2 70B를 기반으로 한 미세 조정된 모델이라는 점에서 차별화됩니다.