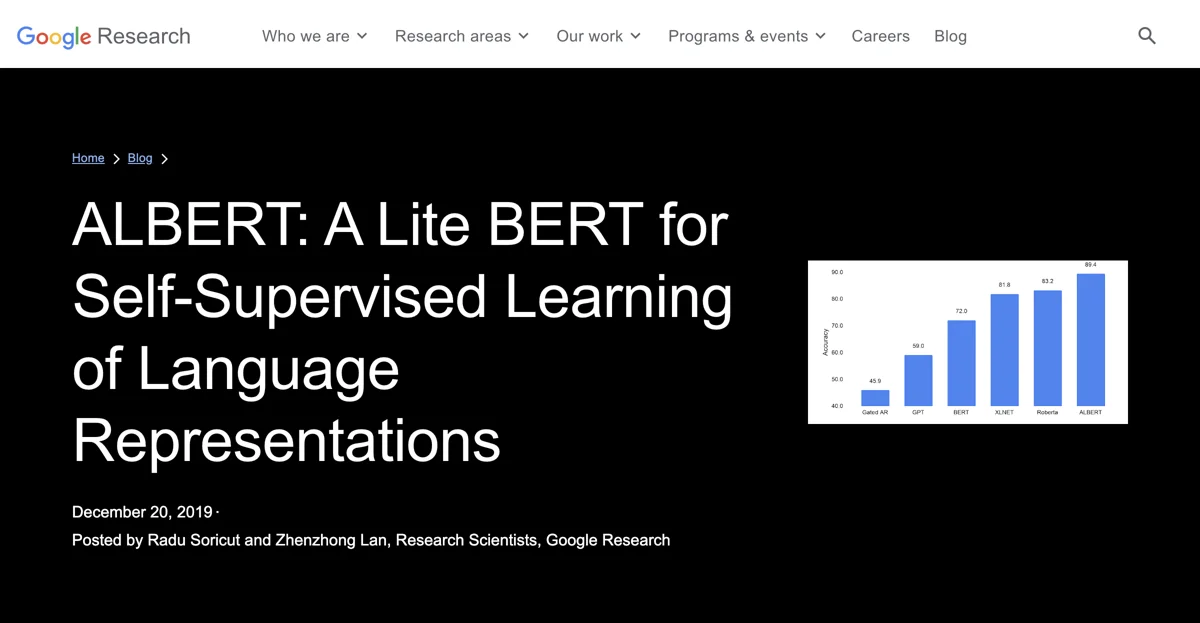

ALBERT is een toffe ontwikkeling in de wereld van zelfsupervisie voor taalrepresentaties. Sinds de komst van BERT heeft de natuurlijke taalonderzoek een nieuw paradigma omarmd, waarbij massa's bestaande tekst gebruikt wordt om de parameters van een model vooraf te trainen zonder dat dataannotatie nodig is. ALBERT is een upgrade op BERT en scoort state-of-the-art resultaten op 12 NLP-taken. Het model is ontworpen om de capaciteit efficiënter in te delen. Door de factorisatie van de embedding-parametrisering wordt een flinke reductie in de parameters van het projectieblok gerealiseerd, met slechts een klein dipje in de prestaties. Daarnaast wordt de mogelijke overbodigheid in de Transformer-gebaseerde neurale netwerkarchitecturen aangepakt door parametersdeling over de lagen. Deze twee ontwerpwijzigingen samen leiden tot een ALBERT-base-model met slechts 12M parameters, een enorme besparing ten opzichte van het BERT-base-model, terwijl toch prima prestaties worden behaald. Met een verbeterde context-afhankelijke taalrepresentatie kan het algemene taalbegrip worden opgekrikt, zoals blijkt uit de resultaten op verschillende benchmarks. ALBERT wordt als open-source-implementatie beschikbaar gesteld aan de onderzoeksgemeenschap om verder vooruitgang in het veld van NLP te stimuleren.

ALBERT

ALBERT is een innovatieve AI voor taalrepresentaties die NLP-prestaties naar een hoger niveau tilt met slimme ontwerpen.

Beste Alternatieven voor ALBERT

scrol.ai

scrol.ai is een AI-gedreven hulpmiddel dat taken vereenvoudigt

Genspark

Genspark is een geweldige AI-aangedreven zoekmachine die tijd bespaart en topresultaten oplevert.

Cranium | U.S. & Global AI Governance

Cranium biedt inzichten in AI-governance voor de toekomst

Ensis

Ensis is een AI-gedreven RFP-software die de efficiëntie opkrikt

Kraftful

Kraftful is een toffe AI-tool die gebruikersfeedback omzet in waardevolle inzichten

Sibyl AI

Sibyl AI is een krachtige AI-tool met diverse functies voor gebruikers

FeedbackbyAI

FeedbackbyAI is een AI-gedreven validatieplatform voor bedrijfsideeën

Allcancode

Allcancode is een AI-gedreven tijd- en kostenschatter voor producten

BeeBee AI

BeeBee AI is een AI-gedreven tool voor het analyseren van earnings calls voor bedrijven

ESAI

ESAI is een geweldige AI-gedreven platform dat helpt bij college toelatingen en meer

ViableView

ViableView is een AI-gedreven hulpmiddel dat ondernemers markt- en productgegevens biedt

OpenDoc AI

OpenDoc AI is een toffe AI-tool die je productiviteit een boost geeft!

Tensorleap

Tensorleap is een geweldige AI-gedreven debugplatform dat de betrouwbaarheid van modellen vergroot

Coglayer

Coglayer is een AI-gedreven leertool voor diverse onderwerpen

AskCSV

AskCSV is een AI-gedreven hulpmiddel waarmee je vragen over CSV-bestanden kunt stellen

Twinword Ideas

Twinword Ideas is een toffe AI-gedreven zoekwoordtool die tijd bespaart

Notably

Notably is een tof AI-onderzoekplatform dat je efficiëntie verhoogt

Daloopa

Daloopa is een AI-gedreven hulpmiddel dat financiële modelupdates automatiseert

PyTorch

PyTorch is een AI-gedreven onderzoekstool met veel mogelijkheden

DatologyAI

DatologyAI is een toffe AI-gepowerde data curatietool die de efficiëntie naar een hoger niveau tilt!

PaperBrain

PaperBrain is een toffe AI-gedreven onderzoekshulpmiddel dat toegang tot wetenschappelijke literatuur makkelijker maakt