MagicAnimate: Een revolutie in menselijke beeldanimatie

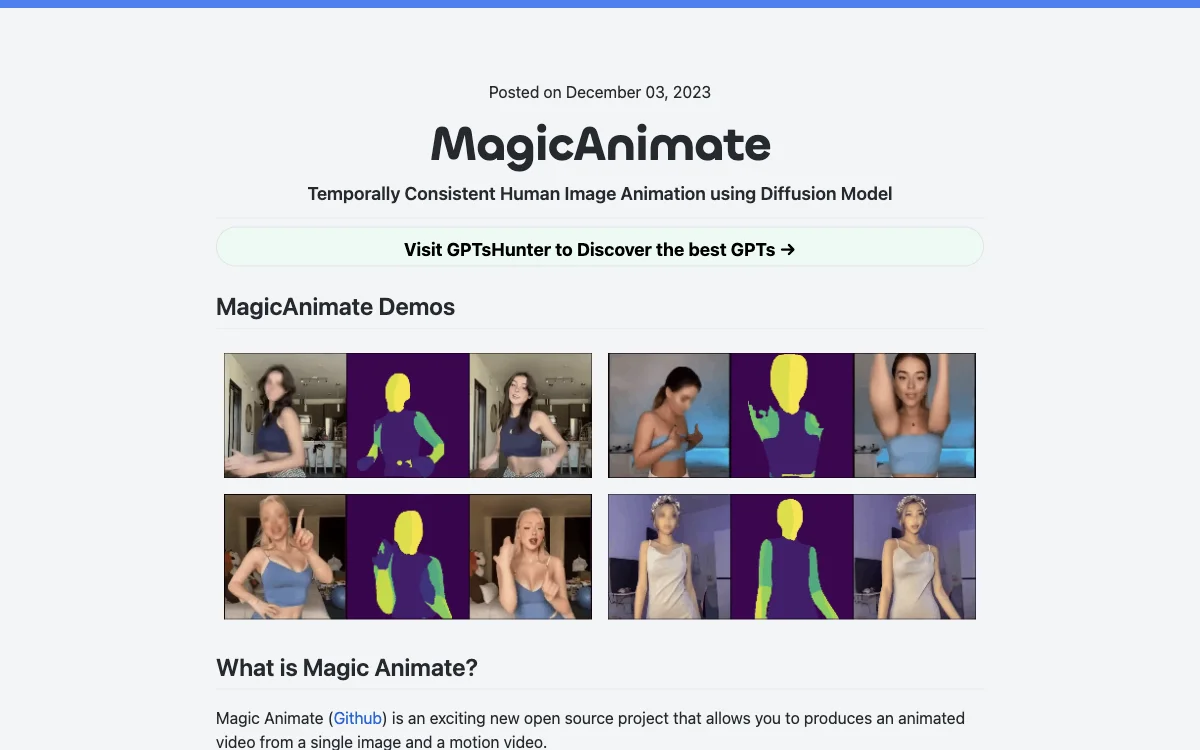

MagicAnimate is een geweldig open source-project dat gebruik maakt van een diffusiemodel om tijdelijk consistente menselijke beeldanimaties te maken. Het stelt gebruikers in staat om een geanimeerde video te maken van een enkele afbeelding en een bewegingsvideo.

Deze innovatieve tool, ontwikkeld door Show Lab, de National University of Singapore & Bytedance, onderscheidt zich door zijn vermogen om de tijdelijke consistentie te behouden, het referentiebeeld te bewaren en de animatiefidelity te verbeteren. Het kan referentiebeelden animeren met bewegingssequenties uit verschillende bronnen, waaronder cross-ID-animaties en onzichtbare domeinen.

MagicAnimate integreert ook met T2I-diffusiemodellen zoals DALLE3, waardoor tekst-gepromptte beelden tot leven komen met dynamische acties. Momenteel biedt het de hoogste consistentie onder dansvide oplossingen, hoewel het enkele nadelen heeft, zoals vervorming in het gezicht en de handen en een stijlverschuiving in de standaardconfiguratie.

Om te beginnen met MagicAnimate moeten gebruikers de voorgetrainde basismodellen voor StableDiffusion V1.5 en MSE-finetuned VAE downloaden, evenals de MagicAnimate-checkpoints. De installatievereisten zijn onder andere python>=3.8, CUDA>=11.3 en ffmpeg. Gebruikers kunnen met conda installeren door de opgegeven opdrachten te volgen.

Er zijn verschillende manieren om MagicAnimate uit te proberen, waaronder online demos op huggingface, Replicate en Colab. Gebruikers kunnen ook de Replicate API gebruiken om geanimeerde video's te genereren door het opgegeven codevoorbeeld te volgen.

Voor het genereren van bewegingsvideo's of het converteren van video's naar bewegingsvideo's kan OpenPose worden gebruikt. Meer informatie over MagicAnimate is beschikbaar via de officiële introductie, het paper, arXiv, de GitHub-code en de demo.