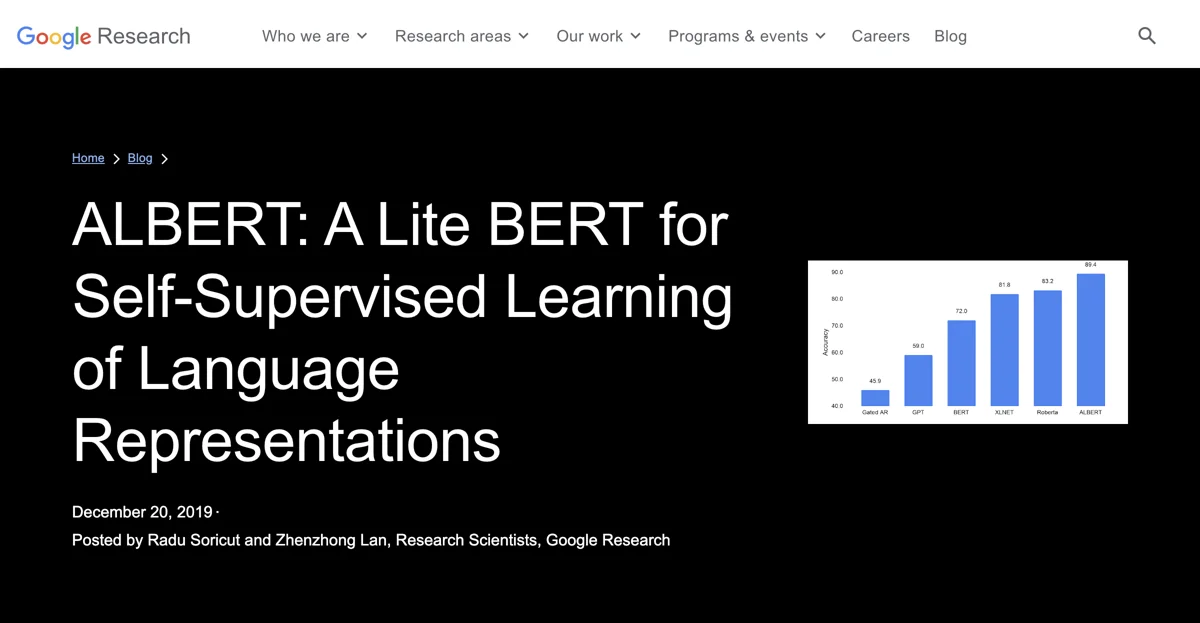

ALBERT to taka zajebista wersja BERT, która robi niezłe wyniki w 12 zadaniach z obszaru przetwarzania języka naturalnego (NLP). Od kiedy pojawił się BERT rok temu, badania w dziedzinie NLP weszły w nowy tryb, korzystając z kupy istniejącego tekstu do wstępnego trenowania parametrów modelu przy użyciu samo-nadzorowania, bez potrzeby pierdolenia się z anotacjami danych. Ale żeby poprawić ten nowy sposób działania w NLP, trzeba zrozumieć, co konkretnie wpływa na wydajność rozumienia języka - wysokość sieci (czyli liczba warstw), jej szerokość (rozmiar reprezentacji warstwy ukrytej), kryteria uczenia dla samo-nadzorowania czy coś kompletnie innego. W ALBERT zastosowano dwa konkretne rozwiązania. Pierwsze to faktoryzacja parametryzacji osadzeń - macierz osadzeń jest rozbita między osadzenia na poziomie wejściowym o niezłej niskiej wymiarowości, a osadzenia warstwy ukrytej korzystają z wyższych wymiarów. Dzięki temu ALBERT osiąga 80% zredukowanie parametrów bloku projekcyjnego przy małym spadku wydajności. Drugie ważne rozwiązanie to współdzielenie parametrów między warstwami, co wywala możliwą redundancję. Ta metoda powoduje lekki spadek dokładności, ale kompaktowość modelu jest tego warta. Wdrożenie tych dwóch zmian razem prowadzi do modelu ALBERT-base z tylko 12 milionami parametrów, co stanowi 89% redukcję w porównaniu z modelem BERT-base, przy jednoczesnym osiągnięciu niezłej wydajności. Co więcej, zmniejszenie liczby parametrów daje możliwość zwiększenia rozmiaru osadzeń warstwy ukrytej. Przy rozmiarze 4096, konfiguracja ALBERT-xxlarge osiąga zarówno 30% redukcję parametrów w porównaniu z modelem BERT-large, jak i konkretne wzrosty wydajności. Wyniki te pokazują, że dokładne rozumienie języka zależy od zrobienia solidnych, wysokiej pojemności reprezentacji kontekstowych. Sukces ALBERT pokazuje, jak ważne jest wykrycie aspektów modelu, które prowadzą do mocnych reprezentacji kontekstowych. Żeby ułatwić dalsze postępy w dziedzinie NLP, ALBERT jest udostępniany społeczności badawczej jako projekt open source.

ALBERT

ALBERT to innowacyjne narzędzie dla NLP, zapewniające świetną wydajność i mniejszą liczbę parametrów.

Najlepsze Alternatywy dla ALBERT

Genspark

Genspark to silnik AI, oszczędzający czas i dający lepsze wyniki

Kraftful

Kraftful to zajebiste AI, które przerabia opinie użytkowników na konkretne wnioski

Sibyl AI

Sibyl AI to potężne narzędzie AI z wieloma funkcjami i korzyściami

Ensis

Ensis to oprogramowanie AI wspomagające tworzenie wniosków RFP

Cranium

Cranium to platforma oferująca wgląd w trendy AI Governance

FeedbackbyAI

FeedbackbyAI to zajebiste narzędzie zasilane AI dla biznesu, które oszczędza czas i zwiększa dochody

ESAI

ESAI to zajebiste narzędzie z AI dla aplikacji studenckich

Allcancode

Allcancode to zajebista AI do szybkiego oszacowania czasu i kosztów dla Twojego pomysłu na produkt

BeeBee.AI

BeeBee.AI to narzędzie AI ułatwiające analizę wyników finansowych

ViableView

ViableView to jest AI wspomagane narzędzie analizujące dane rynkowe i produktowe dla przedsiębiorców

OpenDoc AI

OpenDoc AI to narzędzie AI zwiększające produktywność 10-krotnie

Tensorleap

Tensorleap to platforma do debugowania i wyjaśniania głębokiego uczenia, która zwiększa niezawodność modeli

Coglayer

Coglayer to aplikacja, która pozwala nauczyć się wszystkiego. Oferuje treści dla rozwoju mózgu.

AskCSV

AskCSV to pytaj wszystko o plikach CSV, zapewnia bezpieczeństwo danych

Twinword Ideas

Twinword Ideas - odkryj najlepsze słowa kluczowe i więcej!

Notably

Notably to zajebista platforma badawcza z AI, która zwiększa wydajność

Daloopa

Daloopa to zajebiste AI, które ułatwia aktualizację modeli finansowych

DatologyAI

DatologyAI to zajebiste narzędzie do automatycznej kuracji danych dla GenAI, które daje kopa biznesowi!

Pienso

Pienso to potężne narzędzie AI do analizy danych, zapewniające dogłębne wglądy

PaperBrain

PaperBrain to narzędzie ułatwiające dostęp do literatury naukowej

PyTorch

PyTorch 是一个强大的 AI 框架,助力多种应用开发