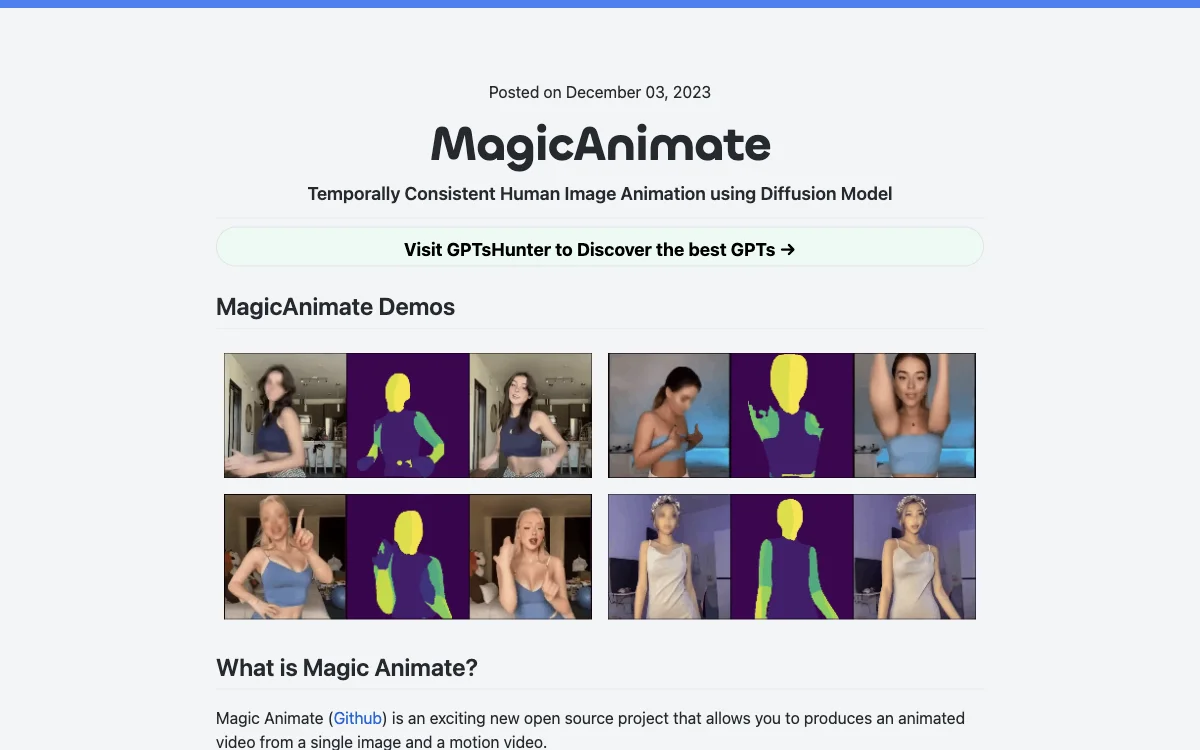

MagicAnimate é um projeto inovador de código aberto que permite criar vídeos animados a partir de uma única imagem e um vídeo de movimento. Desenvolvido pelo Show Lab, Universidade Nacional de Singapura e Bytedance, esta ferramenta utiliza um modelo de difusão para animar imagens de referência com sequências de movimento de várias fontes, incluindo animações cross-ID e domínios não vistos, como pinturas a óleo e personagens de filmes. Uma das principais vantagens do MagicAnimate é a sua capacidade de manter a consistência temporal e preservar fielmente a imagem de referência, melhorando significativamente a fidelidade da animação. Além disso, integra-se perfeitamente com modelos de difusão T2I, como DALLE3, trazendo imagens sugeridas por texto à vida com ações dinâmicas. No entanto, alguns desafios incluem distorções no rosto e nas mãos, e uma mudança de estilo de anime para realismo nas configurações padrão, o que pode exigir ajustes no checkpoint. Para começar a usar o MagicAnimate, é necessário baixar os modelos pré-treinados para StableDiffusion V1.5 e MSE-finetuned VAE, além de atender aos pré-requisitos de instalação, como Python>=3.8, CUDA>=11.3 e ffmpeg. O MagicAnimate também oferece uma demonstração online no Huggingface e Replicate, e pode ser executado no Colab. Para gerar vídeos de movimento ou converter vídeos em movimento, pode-se utilizar o OpenPose, uma biblioteca de detecção de pontos-chave em tempo real para estimativa de corpo, rosto, mãos e pés. O MagicAnimate representa um avanço significativo na animação de imagens humanas, oferecendo uma solução de alta consistência para vídeos de dança e além.

MagicAnimate

Descubra o MagicAnimate, uma ferramenta de animação de imagens humanas baseada em difusão, destacando-se pela consistência temporal e fidelidade.

Melhores alternativas ao MagicAnimate

Mochi 1 AI

Mochi 1 AI é um gerador de vídeo que transforma textos em vídeos incríveis sem complicação.

Tavus

Tavus oferece APIs para criar vídeos com gêmeos digitais realistas.

DiverseShot AI

DiverseShot AI é uma ferramenta que transforma vídeos em 3D

Adori

Adori é uma ferramenta AI que converte blogs em vídeos

Amplifiles

Amplifiles é uma plataforma de vídeo curto com IA que transforma conteúdo

Short Videos App

Crie vídeos curtos com IA para mídias sociais e marketing. Engaje seu público com conteúdo de alta qualidade, produzido de forma rápida e eficiente.

ShortsFaceless

Crie vídeos curtos e sem rosto com IA. Automatize roteiros, imagens, vozes e legendas em minutos. Escalável e personalizável.

Pipio

Pipio: Crie vídeos profissionais com IA, rapidamente e facilmente. Ideal para marketing, educação e entretenimento.

VidAI

VidAI é uma ferramenta de geração de vídeos com IA que ajuda a criar conteúdo viral

GliaStudio

GliaStudio é uma plataforma de vídeo automatizada que ajuda a criar conteúdo envolvente

Powtoon

Powtoon é uma plataforma dinâmica para criar vídeos e apresentações incríveis.

Sendspark

Sendspark é um gerador de roteiros de vídeo com IA que ajuda nas vendas

Visla

O Visla é uma ferramenta de criação e edição de vídeos com IA pra negócios bombando!

BHuman

BHuman é um AI que cria clones digitais para facilitar a vida dos usuários

Immersive Fox

Immersive Fox é uma ferramenta de criação de vídeos AI que ajuda a gerar conteúdo rapidamente.

PlayPlay

PlayPlay é uma plataforma de criação de vídeos para empresas

GoEnhance AI

GoEnhance AI é uma plataforma de produção de vídeo com diversas ferramentas

HeyGen

HeyGen é um gerador de vídeos AI que facilita a criação e tradução

JoggAI

JoggAI é um gerador de anúncios de vídeo que ajuda a criar conteúdo cativante

Bytecap

Bytecap é uma ferramenta de criação de vídeos com recursos de IA

guidde

guidde é uma plataforma de IA que cria documentação de vídeo 11x mais rápido