Run:ai se destaca como uma solução inovadora no campo da inteligência artificial, oferecendo uma plataforma especializada para otimizar e orquestrar infraestruturas de IA. Com foco em GPUs, a Run:ai foi projetada para garantir que suas iniciativas de IA possam sempre aproveitar os avanços mais recentes. A plataforma oferece uma variedade de ferramentas, incluindo CLI & GUI, Workspaces, e suporte para frameworks de código aberto, como Llama-2-7b-chat-hf, Falcon-40b-instruct, e Mixtral-8x7B-Instruct-v0.1, entre outros.

O ecossistema de desenvolvimento da Run:ai é robusto, suportando uma ampla gama de cargas de trabalho, ativos, métricas, e administração, incluindo autenticação e autorização, gerenciamento de multi-clusters, e painéis de relatórios. A plataforma também oferece um plano de controle avançado, com agendamento de cargas de trabalho de IA, pooling de nós, orquestração de contêineres, e fracionamento de GPUs, tudo projetado para aumentar a eficiência e reduzir custos.

Com o Run:ai Cluster Engine, as organizações podem acelerar suas iniciativas de IA e liderar a corrida pela inovação. O agendador de cargas de trabalho de IA otimiza o gerenciamento de recursos, enquanto o fracionamento de GPUs aumenta a eficiência de custos em ambientes de inferência e fazendas de notebooks. O pooling de nós permite o controle de clusters de IA heterogêneos com cotas, prioridades e políticas ao nível do pool de nós, e a orquestração de contêineres facilita a execução de cargas de trabalho distribuídas em clusters de IA nativos da nuvem.

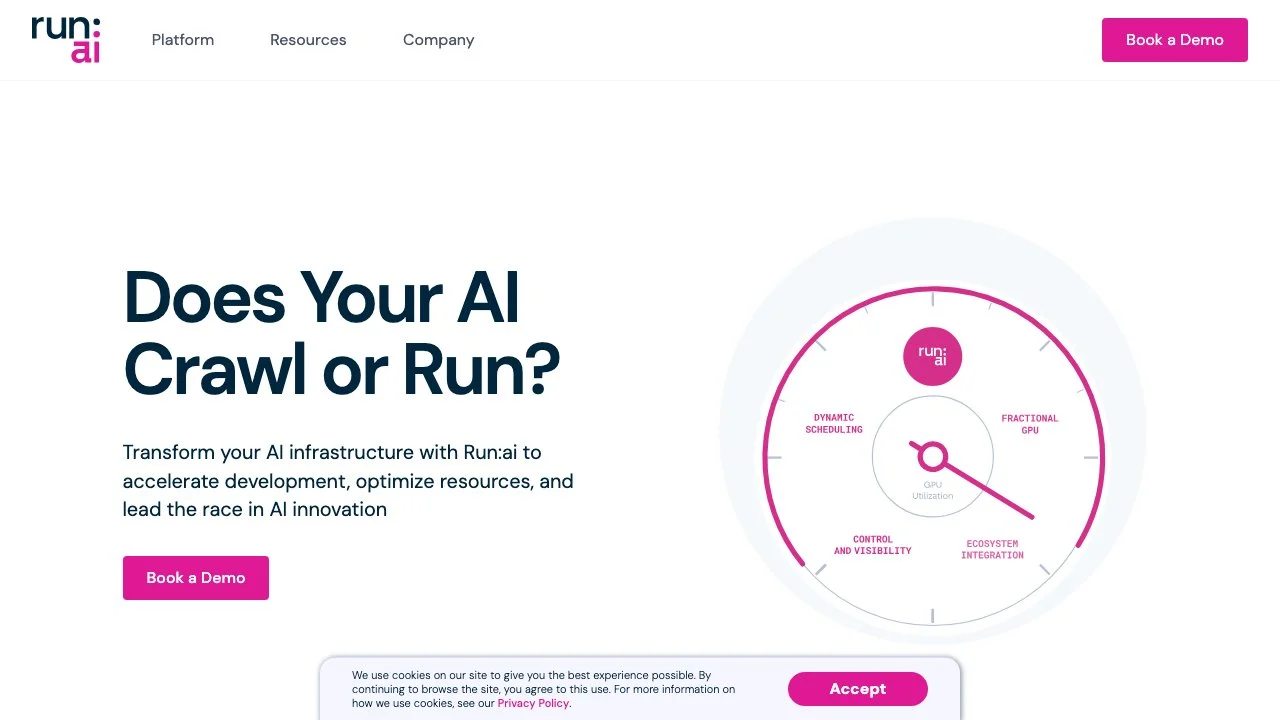

Run:ai promete máxima eficiência, segurança e controle, com agendamento dinâmico, pooling de GPUs, e fracionamento de GPUs, permitindo até 10 vezes mais cargas de trabalho na mesma infraestrutura. A plataforma também oferece visibilidade completa sobre a utilização da infraestrutura e das cargas de trabalho, com painéis de visão geral, análises históricas e relatórios de consumo.

A Run:ai pode ser implantada em qualquer infraestrutura, seja na nuvem, on-premise ou em ambientes air-gapped, suportando qualquer ferramenta e framework de ML, Kubernetes, e infraestrutura de GPU, CPU, ASIC, armazenamento e rede. A plataforma também oferece um ambiente de desenvolvimento de IA simples, escalável e aberto, com notebooks sob demanda, treinamento e ajuste fino, e gerenciamento de LLMs privados.

Com a Run:ai, as organizações podem inovar mais rapidamente, treinar e implantar mais modelos de forma eficiente, e maximizar o retorno sobre o investimento em IA. A parceria com a NVIDIA oferece a solução mais performática para sistemas DGX, reforçando o compromisso da Run:ai com a excelência e inovação em IA.