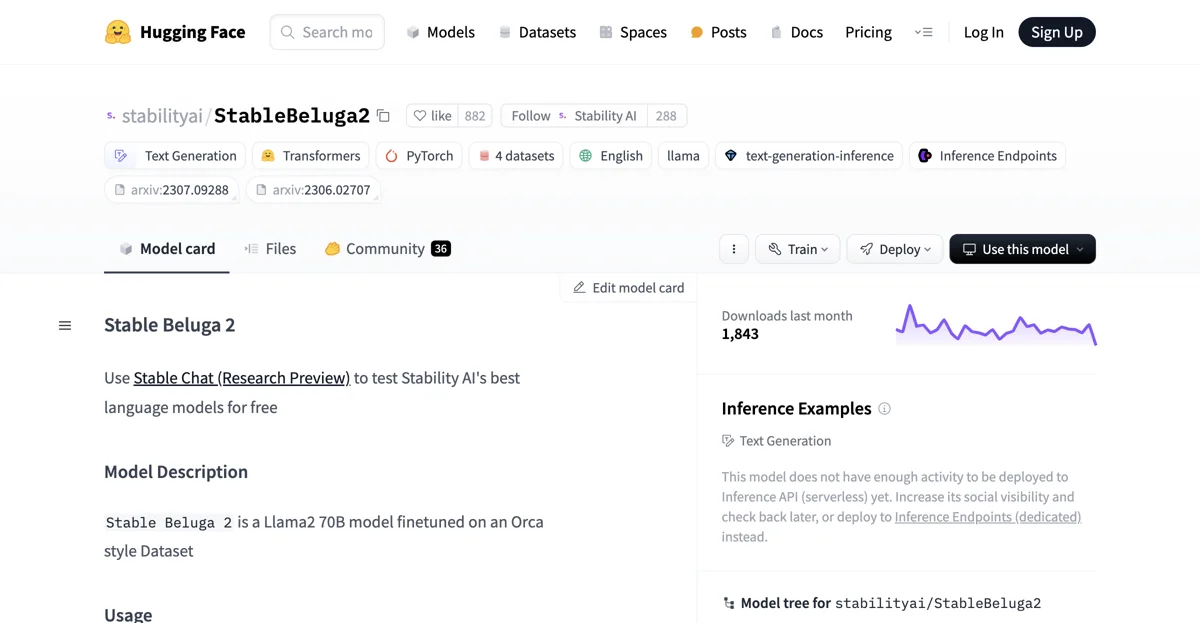

StableBeluga2 é um modelo de linguagem que vem ganhando destaque no campo da inteligência artificial. Ele é baseado no Llama2 70B e foi fine-tuned em um dataset no estilo Orca.

Para começar a usar o StableBeluga2, é possível fazer isso através de um código snippet. Primeiro, importamos as bibliotecas necessárias, como torch e as classes AutoModelForCausalLM e AutoTokenizer da biblioteca transformers. Em seguida, carregamos o tokenizer e o modelo propriamente ditos, configurando-os adequadamente com parâmetros como torch_dtype, low_cpu_mem_usage e device_map.

Uma vez que tudo está configurado, podemos enviar prompts ao modelo. Por exemplo, se quisermos que ele escreva um poema, definimos um system_prompt que orienta o comportamento do modelo e um message com a solicitação específica. Combinando esses elementos, formamos o prompt completo que é passado para o tokenizer e, em seguida, para o modelo para gerar a saída desejada.

O StableBeluga2 possui um formato de prompt recomendado, que inclui a definição do system_prompt seguido do user prompt e a expectativa de uma resposta no formato de assistant prompt.

Além do StableBeluga2, existem outros modelos da família Beluga, como o StableBeluga1 - Delta, StableBeluga13B e StableBeluga7B, cada um com suas características próprias.

O modelo foi desenvolvido pela Stability AI e é licenciado sob a STABLE BELUGA NON-COMMERCIAL COMMUNITY LICENSE AGREEMENT. Ele é treinado em um dataset interno no estilo Orca, seguindo um procedimento de treinamento que envolve fine-tuning supervisionado, treinamento em precisão mista (BF16) e otimização com AdamW.

No entanto, é importante lembrar que, como qualquer modelo de linguagem, o StableBeluga2 tem suas limitações. As saídas potenciais não podem ser previsíveis com certeza, e ele pode produzir respostas imprecisas, tendenciosas ou outras que sejam consideradas objetáveis em alguns casos. Portanto, os desenvolvedores devem realizar testes de segurança e ajustes antes de implantar qualquer aplicação que utilize esse modelo.

Embora ainda não tenha atividade suficiente para ser implantado na Inference API (serverless), é possível aumentar sua visibilidade social e voltar a conferir mais tarde, ou implantá-lo em Inference Endpoints (dedicated) em vez disso.