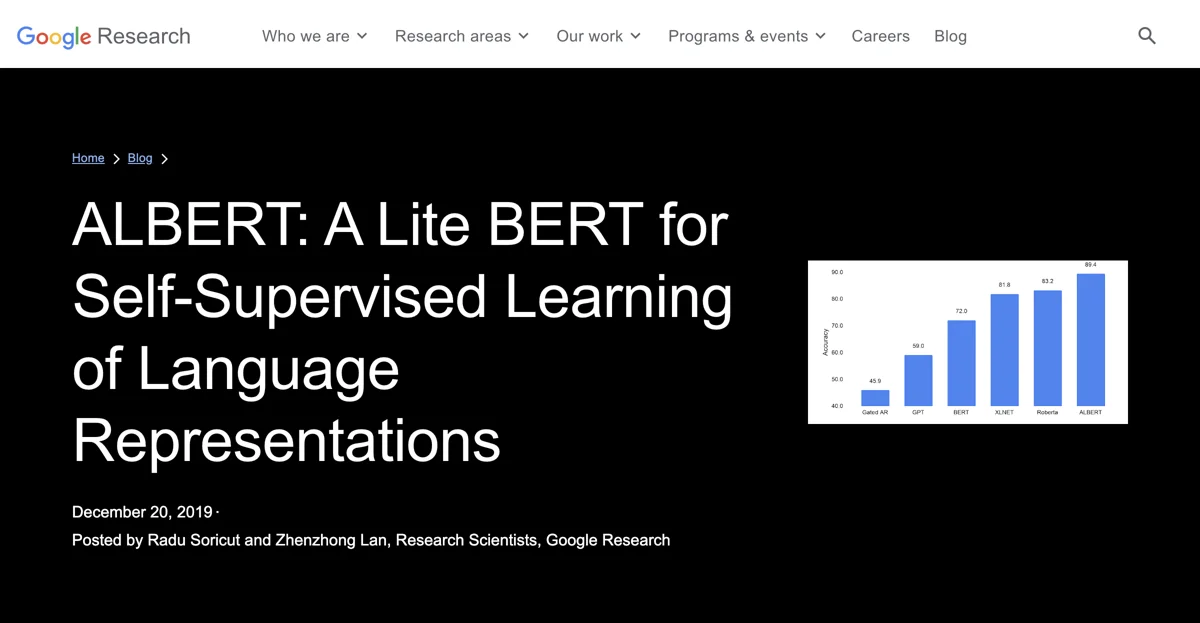

С момента появления BERT в исследовании естественного языка используется самообучение на больших объемах текста. ALBERT - улучшенная версия BERT, представленная на ICLR 2020. Она демонстрирует хорошие результаты на 12 задачах NLP. ALBERT обладает ключевыми особенностями: эффективное распределение параметров и обмен параметрами между слоями, что позволяет сократить количество параметров. Она достигает 80% сокращения параметров в блоке проекции с минимальным снижением производительности. Например, ALBERT-base имеет меньше параметров, чем BERT-base, но показывает хорошие результаты. ALBERT-xxlarge с размером скрытого слоя 4096 показала улучшение производительности. Успех ALBERT подчеркивает важность создания мощных контекстуальных представлений. Авторы призывают попробовать ALBERT для улучшения проектов в области обработки естественного языка.

ALBERT

Узнайте о ALBERT, легкой версии BERT, которая улучшает производительность в задачах NLP с помощью самообучения.

Лучшие альтернативы ALBERT

AskMore

AskMore — это AI - инструмент для опросов пользователей, который помогает получить быстрый фидбек.

AutoArena

AutoArena - автоматизированная оценка Gen AI, обеспечивающая быстрые и точные результаты.

Product Lab AI

Product Lab AI — это AI - платформа, которая ускоряет поиск продуктовых идей до нескольких минут.

MARK•R

MARK•R — это AI - плагин для браузера, который дает возможность активно взаимодействовать с веб - контентом.

Socially Sourced Startup Ideas

Socially Sourced Startup Ideas помогает находить идеи для стартапов из социальных медиа.

Looppanel

Looppanel — это инструмент для UX-исследований, который ускоряет анализ данных и обеспечивает безопасность.

ТопикМоджо

ТопикМоджо - крутой инструмент для исследования тем с кучей фишек

Вордваре

Вордваре - это крутая AI-тулбокс для создания и управления AI-стеком

Human or AI Game

В Human or AI Game ты решаешь, человек или ИИ создал изображение

The Full Stack

The Full Stack - крутые курсы по созданию AI-продуктов

techtrust.ai

techtrust.ai - Идентифицирует ранние этапы AI-технологий с потенциалом

Regex.ai

Regex.ai - ИИ-мощный инструмент для крутых регулярных выражений

Creators' AI

Creators' AI предоставляет AI-инсайты и инструменты для создателей и предпринимателей

GOODY

GOODY-2 - это безопасная AI-модель с этическими принципами

screenpipe

screenpipe - Captures desktop activities for various uses

Melon

Melon - AI для улучшения мышления и обучения

ApX Machine Learning

ApX Machine Learning - крутые бесплатные курсы и мощная платформа для ML

Intuition Machines

Intuition Machines - ведущий в области защищенных личных данных AI/ML

Calypso

Calypso - AI-помощник для анализа публичных акций

GPTs Finder

GPTs Finder - обновляет каталог GPT каждые час, обеспечивая доступ к новинкам

BeanBook

BeanBook - крутой сервис для отслеживания и исследования кофейных зёрен с помощью ИИ