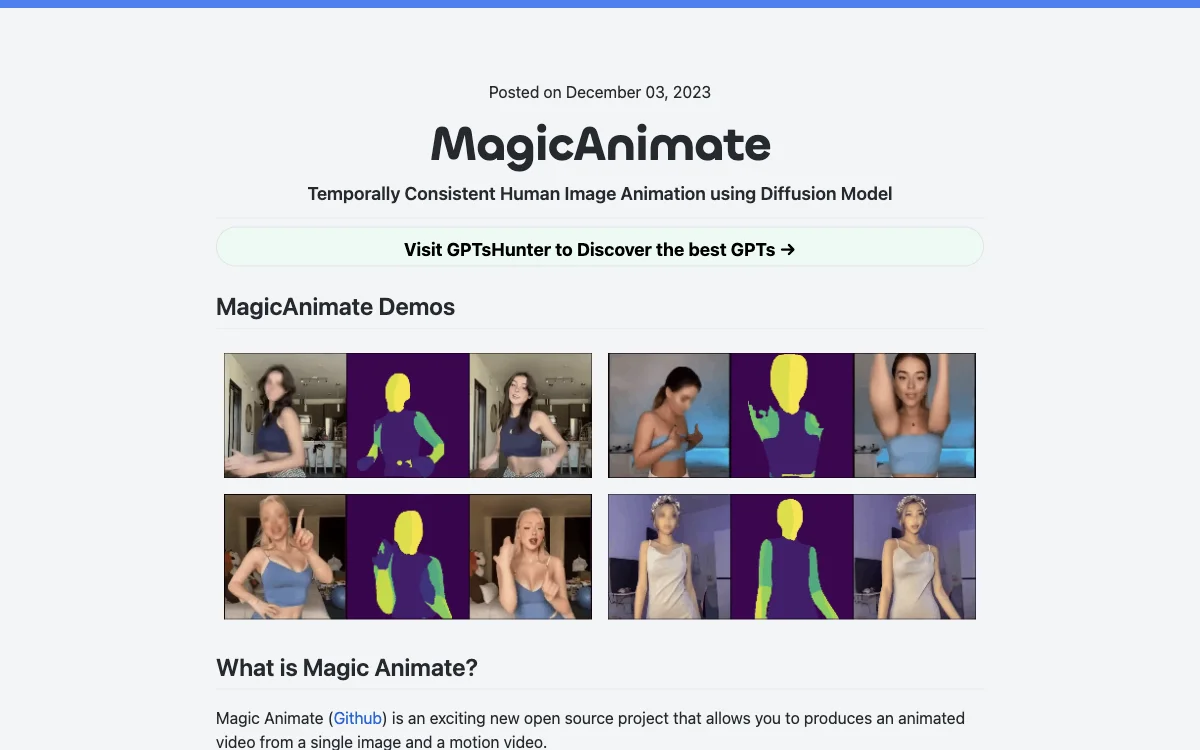

MagicAnimate представляет собой передовой проект с открытым исходным кодом, разработанный Show Lab, Национальным университетом Сингапура и Bytedance. Этот инструмент позволяет создавать анимированные видео из одного изображения и видео с движением, сохраняя при этом временную согласованность и точно воспроизводя исходное изображение. MagicAnimate выделяется своей способностью анимировать изображения с использованием последовательностей движений из различных источников, включая анимацию между разными идентификаторами и неизвестные домены, такие как масляные картины и персонажи фильмов. Он также интегрируется с моделями диффузии T2I, такими как DALLE3, оживляя изображения, созданные по текстовым запросам, с помощью динамических действий.

Среди преимуществ MagicAnimate — высочайшая согласованность среди всех решений для создания танцевальных видео. Однако, существуют и недостатки, такие как искажение лица и рук, а также изменение стиля с аниме на реализм в стандартной конфигурации, что может потребовать модификации контрольной точки.

Для начала работы с MagicAnimate необходимо загрузить предварительно обученные базовые модели для StableDiffusion V1.5 и MSE-доработанный VAE, а также установить необходимые зависимости, включая Python>=3.8, CUDA>=11.3 и ffmpeg. MagicAnimate доступен для тестирования через онлайн-демо на Hugging Face и Replicate, а также через Colab. Для генерации анимированных видео можно использовать API Replicate.

MagicAnimate поддерживает создание видео с движением или преобразование видео в видео с движением с использованием библиотеки OpenPose для обнаружения ключевых точек тела, лица, рук и ног в реальном времени. Дополнительная информация о MagicAnimate доступна на официальном сайте, в научной статье и на GitHub.