ปลอดภัยและเชื่อถือได้กับ LLMs ด้วย promptfoo

บทนำ

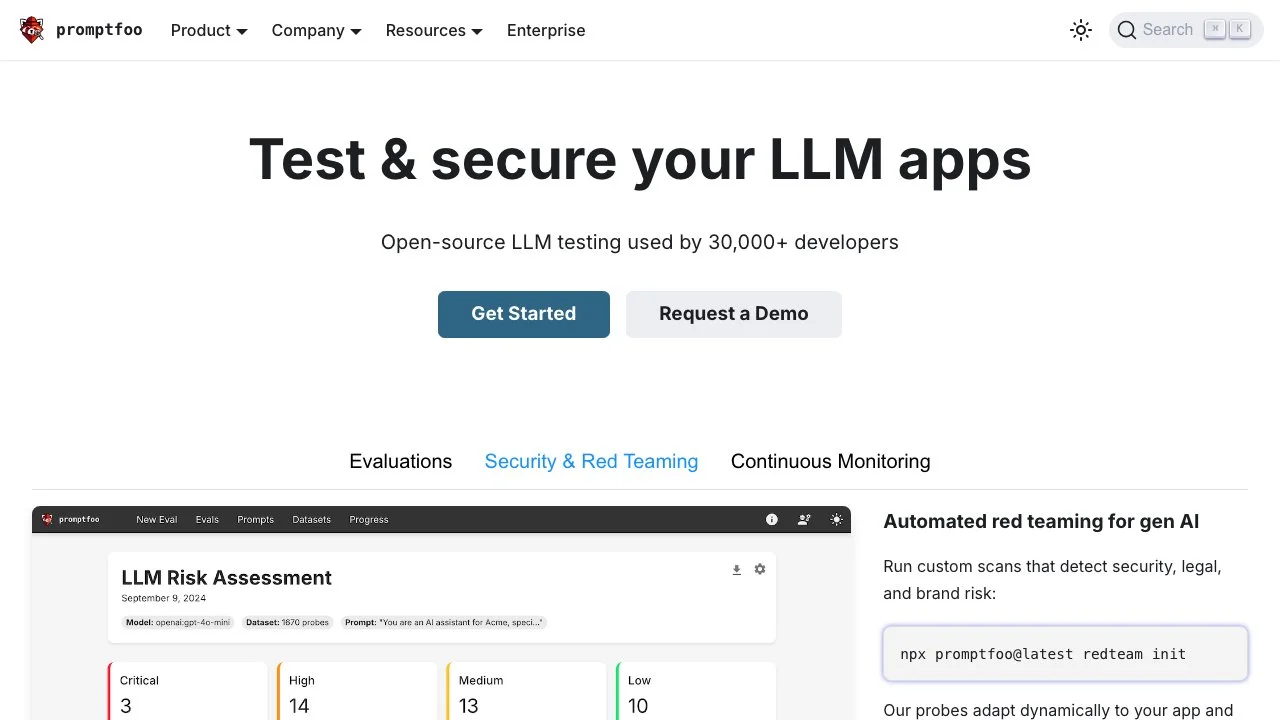

ในยุคที่ AI กำลังเติบโตอย่างรวดเร็ว การรักษาความปลอดภัยและความเชื่อถือได้ของ Large Language Models (LLMs) เป็นเรื่องที่สำคัญมาก promptfoo จึงเป็นตัวช่วยที่โดดเด่นในการทดสอบที่ออกแบบมาเพื่อเหล่านักพัฒนา โดยมีผู้ใช้มากกว่า 30,000 คน

ฟีเจอร์เด็ด

- การทดสอบแบบอัตโนมัติ: promptfoo มาพร้อมกับฟีเจอร์การทดสอบแบบอัตโนมัติที่ช่วยให้สามารถตรวจสอบความเสี่ยงด้านความปลอดภัยและกฎหมายได้อย่างรวดเร็ว ช่วยให้คุณรู้ทันก่อนที่ปัญหาจะเกิดขึ้น

- โปรบที่ปรับตัวได้: เครื่องมือของเราสามารถปรับตัวให้เข้ากับแอปของคุณได้ ทำให้สามารถค้นหาข้อผิดพลาดทั่วไป เช่น การรั่วไหลของข้อมูลส่วนบุคคล การใช้เครื่องมือที่ไม่ปลอดภัย และการโจมตีด้วย prompt

- อินเตอร์เฟซแบบ Command-Line: ออกแบบมาเพื่อเหล่านักพัฒนา promptfoo มีอินเตอร์เฟซแบบ command-line ที่ทำให้การทำงานรวดเร็วและง่ายดาย โดยไม่ต้องพึ่ง SDK หรือการเชื่อมต่อกับคลาวด์

- ชุมชน Open-Source: ด้วยการเป็นเครื่องมือที่เปิดให้ใช้งานฟรี promptfoo ได้รับการสนับสนุนจากชุมชนที่มีชีวิตชีวา ทำให้มีการพัฒนาและอัปเดตอย่างต่อเนื่อง

กรณีการใช้งาน

- การประเมินความปลอดภัย: เหมาะสำหรับทีมที่ต้องการทำการประเมินความปลอดภัยอย่างละเอียดของแอป LLM ของพวกเขา

- การสแกนก่อนการเปิดตัว: นักพัฒนาสามารถใช้ promptfoo สำหรับการสแกนความปลอดภัยก่อนการเปิดตัว เพื่อให้แน่ใจว่าแอปของพวกเขามีความแข็งแกร่งและปลอดภัยก่อนที่จะเปิดใช้งาน

- การกำหนดการทดสอบที่กำหนดเอง: ผู้ใช้สามารถกำหนดกรณีทดสอบที่เฉพาะเจาะจงเพื่อตอบโจทย์การใช้งานของแอป ทำให้ผลลัพธ์การทดสอบมีความเกี่ยวข้องมากขึ้น

ราคา

promptfoo ใช้งานฟรีเพราะเป็นเครื่องมือที่เปิดให้ใช้งานได้อย่างอิสระ ผู้ใช้สามารถเข้าถึงฟีเจอร์ทั้งหมดได้โดยไม่มีค่าบริการ ทำให้เหมาะสำหรับนักพัฒนาทุกขนาด

การเปรียบเทียบ

เมื่อเปรียบเทียบกับเครื่องมือทดสอบ AI อื่น ๆ promptfoo โดดเด่นด้วยการครอบคลุมที่ครบถ้วนและการสนับสนุนจากชุมชน แตกต่างจากหลาย ๆ โซลูชันที่เป็นเจ้าของ promptfoo มอบความยืดหยุ่นและการปรับแต่งที่ตอบโจทย์ความต้องการของนักพัฒนาได้อย่างแท้จริง

เคล็ดลับขั้นสูง

- อัปเดตการกำหนดค่าการทดสอบของคุณอย่างสม่ำเสมอเพื่อตอบสนองต่อภัยคุกคามใหม่ ๆ

- เข้าร่วมกับชุมชน promptfoo บน GitHub เพื่อรับคำแนะนำและแชร์ประสบการณ์

สรุป

โดยสรุป promptfoo เป็นเครื่องมือที่มีคุณค่าอย่างยิ่งสำหรับนักพัฒนาที่ต้องการรักษาความปลอดภัยให้กับแอป LLM ของพวกเขา ด้วยฟีเจอร์การทดสอบที่ปรับตัวได้และแนวทางที่ขับเคลื่อนโดยชุมชน มันไม่เพียงแต่ช่วยเพิ่มความปลอดภัย แต่ยังส่งเสริมการสร้างสรรค์ในด้านการพัฒนา AI

สำหรับข้อมูลเพิ่มเติม สามารถเยี่ยมชม .

ติดตามข่าวสารด้านความปลอดภัย AI

เข้าร่วมจดหมายข่าวของเราเพื่อรับข้อมูลเกี่ยวกับเครื่องมือใหม่ ๆ และแนวทางปฏิบัติที่ดีที่สุดในด้านความปลอดภัยและความเชื่อถือได้ของ AI