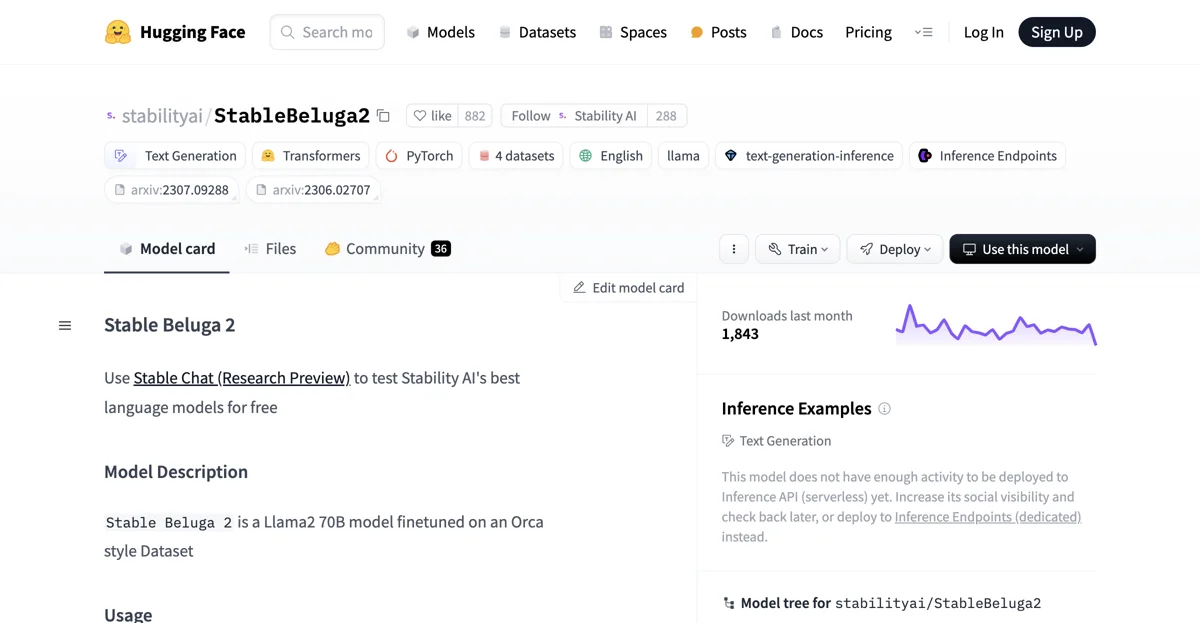

StableBeluga2, Stability AI tarafından geliştirilmiş otoregresif bir dil modeli olan kanka. Bu şey Llama2 70B üzerine finetune edilmiş, İngilizce dilinde çalışıyor ve HuggingFace Transformers kütüphanesini kullanıyor.

Kullanımı için şu adımları takip etmeni tavsiye ederim abi. Öncelikle gerekli kütüphaneleri import et:

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer, pipeline

Sonra tokenizer ve modeli yükle:

tokenizer = AutoTokenizer.from_pretrained("stabilityai/StableBeluga2", use_fast=False)

model = AutoModelForCausalLM.from_pretrained("stabilityai/StableBeluga2", torch_dtype=torch.float16, low_cpu_mem_usage=True, device_map="auto")

Sistem promptunu ve kullanıcı mesajını oluştur. Örneğin:

system_prompt = "### System:\nYou are Stable Beluga, an AI that follows instructions extremely well. Help as much as you can. Remember, be safe, and don't do anything illegal.\n\n"

message = "Write me a poem please"

prompt = f"{system_prompt}### User: {message}\n\n### Assistant:\n"

Girdi olarak tokenizer'ı kullanarak promptu hazırla ve modelin çıktısını almak için generate fonksiyonunu kullan:

inputs = tokenizer(prompt, return_tensors="pt").to("cuda")

output = model.generate(**inputs, do_sample=True, top_p=0.95, top_k=0, max_new_tokens=256)

print(tokenizer.decode(output[0], skip_special_tokens=True))

StableBeluga2'nin eğitimleri, içsel Orca-stili veri setleri üzerinde yapılıyor. Eğitimler, izlenen finetune yöntemiyle ve mixed-precision (BF16) ile yapılıyor, ayrıca AdamW ile optimize ediliyor.

Modelin etik ve sınırlı yönleri de var kanka. Beluga, kullanımda riskler taşıyan yeni bir teknolojidir. Şu ana kadar yapılan testler İngilizce dilinde, tüm senaryoları kapsamadığı için, diğer tüm LLM'ler gibi, Beluga'nın potansiyel çıktılarını önceden tahmin etmek mümkün değil. Geliştiriciler, modelin uygulamalarını dağıtmadan önce, güvenlik testleri yapmalı ve uygulamalarına özel olarak ayarlamalılar.

Modelin son bir ay içinde 1.843 indirme sayısına sahip. Ancak henüz Inference API (serverless) için yeterli aktiviteye sahip değil. Sosyal görünürlüğünü artırarak daha sonra tekrar kontrol etmeni tavsiye ederim veya Inference Endpoints (dedicated) üzerine dağıtabilirsin.