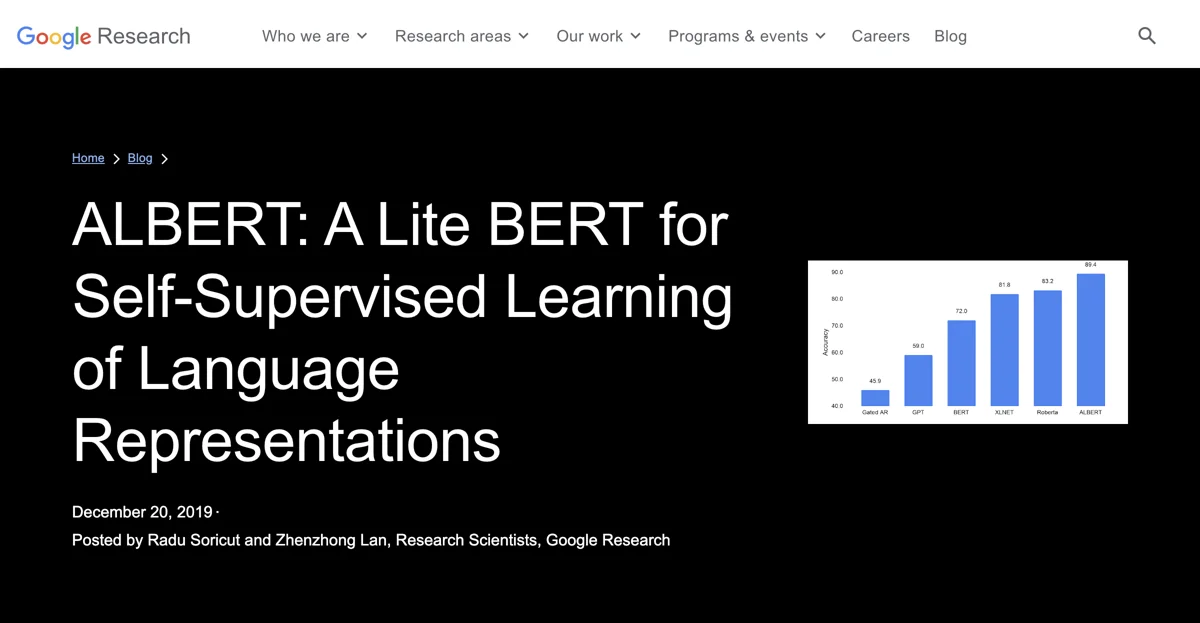

ALBERT là một bước tiến trong lĩnh vực xử lý ngôn ngữ tự nhiên (NLP) được phát triển bởi Google Research. Nó xây dựng trên nguyên tắc của BERT và có các cải tiến sáng tạo. ALBERT có kiến trúc độc đáo giúp tối ưu hóa công suất, tập trung phát triển đại diện ngữ cảnh mạnh mẽ và được phát hành dưới dạng mã nguồn mở trên TensorFlow. Ứng dụng của ALBERT gồm hiểu ngôn ngữ tự nhiên, phân loại văn bản, chatbot và trợ lý ảo. Nó có sẵn miễn phí nhưng triển khai ở quy mô lớn có thể cần chi phí cho tài nguyên tính toán. So với BERT, ALBERT có cải tiến đáng kể. Để tối đa hóa lợi ích, người dùng nên tinh chỉnh mô hình trên tập dữ liệu cụ thể. ALBERT minh chứng cho bước tiến trong NLP và khuyến khích sự khám phá và phát triển trong cộng đồng AI. Từ khóa liên quan: ALBERT, đại diện ngôn ngữ, NLP, nghiên cứu AI, mã nguồn mở, hiểu ngữ cảnh, chia sẻ tham số, phân loại văn bản, học máy, Google Research.

ALBERT

Khám phá ALBERT, một công cụ AI cách mạng tối ưu hóa đại diện ngôn ngữ cho hiệu suất NLP vượt trội.

Các lựa chọn thay thế cho ALBERT

Topic Mojo

Topic Mojo là công cụ nghiên cứu chủ đề và câu hỏi giúp người dùng

Wordware

Wordware là bộ công cụ AI siêu xịn giúp bạn xây dựng và quản lý các stack AI một cách dễ dàng.

Human or AI Game

Human or AI Game giúp người dùng xác định ảnh là của người hay do AI tạo

SEO Title Generator

SEO Title Generator tạo ra các tiêu đề hấp dẫn dựa trên phân tích dữ liệu

LowTech AI

LowTech AI là công cụ kết hợp AI mạnh mẽ, cung cấp nhiều chức năng hữu ích

Locus

Locus là công cụ tìm kiếm thông minh được hỗ trợ bởi AI giúp tăng năng suất

Lobe

Lobe là công cụ học máy dễ sử dụng giúp đào tạo và triển khai mô hình

KitchenAI

KitchenAI là công cụ LLMOps nguồn mở giúp quản lý và phát triển AI dễ dàng

UserCall

UserCall là công cụ AI cung cấp hiểu biết sâu hơn cho người dùng

Breve AI

Breve AI là nền tảng AI đầy sức mạnh, giúp bạn tối ưu hóa công việc

The Full Stack

The Full Stack cung cấp các khóa học về sản phẩm AI

Fydback

Fydback là công cụ AI tạo phản hồi hiệu suất chính xác

Frontier Model Forum

Frontier Model Forum thúc đẩy an toàn AI, mang lại lợi ích cho hệ sinh thái AI

Graphite Note

Graphite Note là công cụ AI giúp nhà phân tích dữ liệu tạo mô hình học máy nhanh chóng, không cần viết code.

Grably

Grably cung cấp truy cập tức thời đến các tập dữ liệu đa dạng và cụ thể cho AI

techtrust.ai

techtrust.ai là nền tảng cung cấp nhiều dịch vụ cho doanh nghiệp

Qquest

Qquest là trợ lý AI cho truy vấn thông tin, giúp người dùng có được hiểu biết tức thời

Regex.ai

Regex.ai là công cụ AI giải quyết biểu thức chính quy, giúp người dùng tìm kiếm và quản lý biểu thức chính quy một cách dễ dàng.

Thesify

Thesify là công cụ AI siêu xịn giúp nâng cao viết học thuật

Research Topics Generator

Research Topics Generator giúp tạo chủ đề nghiên cứu có ý nghĩa

PaperPilot

PaperPilot là nền tảng cho phép tải lên và phân tích bài báo nghiên cứu với sự trợ giúp của AI