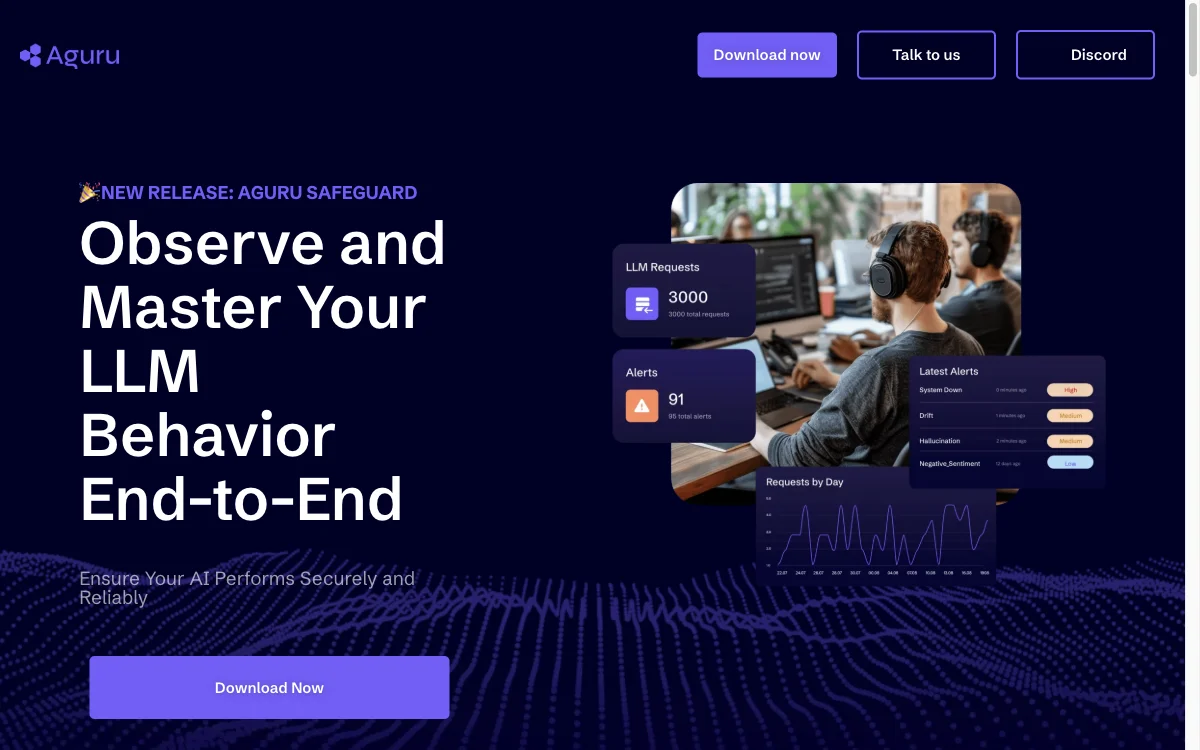

Aguru Safeguard ist eine On-Prem-Software. Sie bietet detaillierte Einblicke in das Verhalten und die Leistung von Language Learning Models (LLMs). Man kann damit frühzeitig Maßnahmen gegen unzuverlässiges Verhalten und Sicherheitsbedrohungen ergreifen. Die Software ermöglicht die genaue Beobachtung der LLMs, liefert sofortige Warnungen bei potenziellen Anomalien, die ins Syslog protokolliert und an bevorzugte Warnsysteme weitergeleitet werden können. Zudem gibt es einen Playground, um mit spezifischen Prompts zu experimentieren und die Funktionalität der KI-Anwendungen zu verbessern. Die Software wird lokal installiert, sodass die Daten privat und sicher bleiben. Nach der Installation kann man über auf die Schnittstelle zugreifen und den LLM-Verkehr überwachen. Neben Aguru Safeguard bietet das Unternehmen auch den LLM Router an. Das Unternehmen strebt die Entwicklung von Lösungen an, die die Herausforderungen in Bezug auf Genauigkeit, Zuverlässigkeit, Sicherheit und Integrität von LLMs lösen.

Aguru Safeguard

Aguru Safeguard bietet detaillierte Einblicke in LLM-Verhalten. Erhalten Sie sofortige Warnungen und nutzen Sie den Playground. Einfache Installation und Integration.

Top-Alternativen zu Aguru Safeguard

Bricklayer AI

Bricklayer AI kombiniert autonome KI-Spezialisten mit menschlichen Experten für effektive Sicherheitsoperationen.

Kakugo

Kakugo ist eine Plattform zur Automatisierung von Sicherheitsanforderungen in DevOps-Umgebungen.

Cortex XDR

Cortex XDR bietet umfassenden Schutz und Erkennung für Unternehmen.

Qwiet AI

Qwiet AI – die KI-Power für deine Code-Sicherheit!

furl

Furl ist eine KI-Lösung zur Automatisierung von IT-Operationen und zur Verbesserung der Cybersicherheit.

Abstract Security

Abstract Security ist eine coole AI-gestützte Sicherheitsplattform, die deine Online-Erfahrung aufpeppt

InsightIDR

InsightIDR ist die coole Cloud-basierte SIEM mit top Features für Bedrohungserkennung

LoginLlama

LoginLlama ist ein krasses AI-gestütztes Login-Sicherheitstool für Devs

RapidSOS

RapidSOS ist eine intelligente Sicherheitsplattform, die Risiken minimiert.

Trellix SIEM

Trellix SIEM – die coole SIEM-Lösung für mehr Sicherheit!

Vicarius vRx

Vicarius vRx ist ein krasses AI-gestütztes Tool zur Schwachstellenbeseitigung und spart richtig viel Zeit und Ressourcen.

BlackBerry Cybersecurity

BlackBerry Cybersecurity mit Cylance AI schützt Unternehmen

Vectra AI

Vectra AI - die KI-Power für deine Cyber-Sicherheit! Stoppt Cyberangriffe im Keim.

Perception Point

Perception Point ist die KI-getriebene Cybersicherheitslösung für den modernen Arbeitsplatz

Loti

Loti ist ein Online-Schutz für Prominente, der Inhalte überwacht und schützt.

Redcoat AI

Redcoat AI ist ein KI-basiertes Cybersicherheitstool, das Teams schützt.

Seal Security

Seal Security ist ein krasses AI-gestütztes Tool für Vulnerability-Remediation und hebt die Sicherheit an

MLCode

MLCode ist ein AI-basiertes Datensicherheits-Tool, das Ihre Daten schützt.

Radiant Security

Radiant Security ist ein AI-betriebenes SOC-Analysten-Tool, das Sicherheitsprobleme löst.

Token

Token ist ein AI-gestütztes Tool, das Identitätskrisen löst und Risiken minimiert.

RiskLens

RiskLens ist ein hammermäßiges KI-basiertes Cyber-Risikomanagement-Tool für bessere Entscheidungen