In der Welt der künstlichen Intelligenz und des maschinellen Lernens ist das Verständnis und die Verwaltung von Token entscheidend für die effektive Nutzung von Sprachmodellen wie denen von OpenAI. Ein Token kann als die kleinste Einheit in einer Textsequenz betrachtet werden, die je nach Tokenisierungsmethode ein Wort, ein Zeichen oder sogar ein Teilwort darstellen kann. Die Tokenisierung, der Prozess der Zerlegung eines Textes in einzelne Token, ist ein grundlegender Schritt, um Textdaten in einer Form darzustellen, die Maschinen verstehen und verarbeiten können.

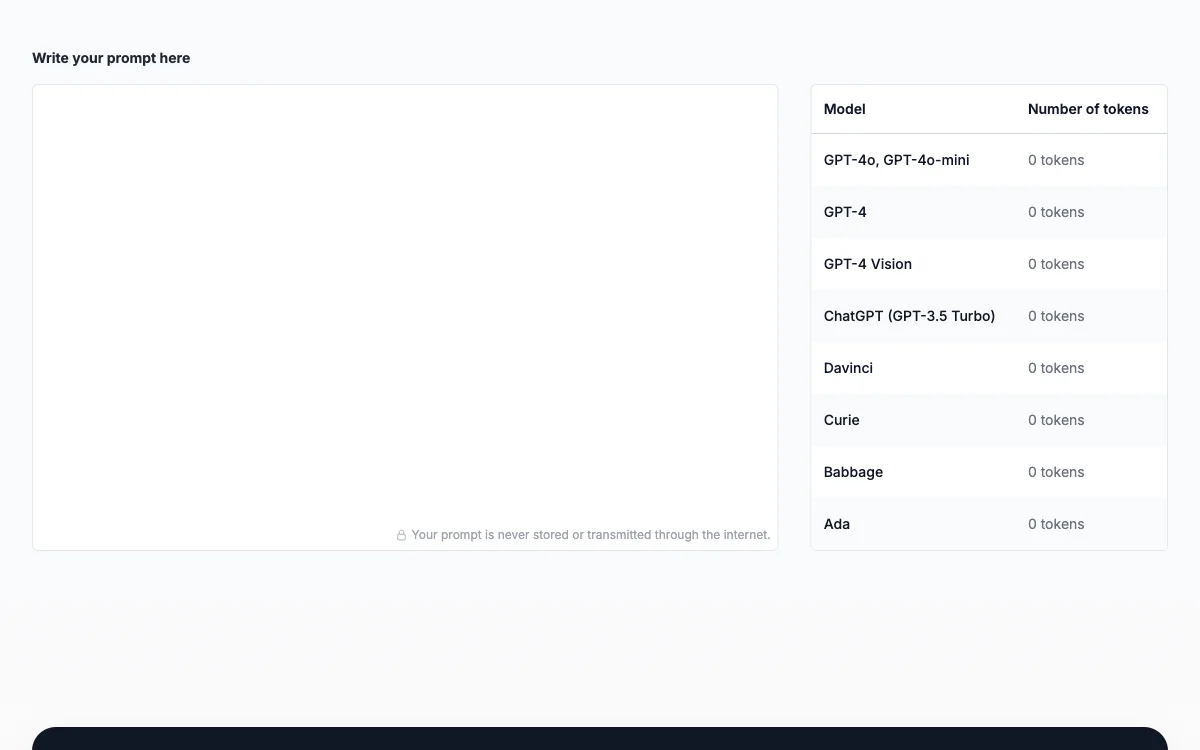

OpenAI-Modelle, einschließlich GPT-3.5, haben spezifische Grenzen für die maximale Anzahl von Token, die in einer einzelnen Interaktion verwendet werden können. Diese Grenzen sind nicht nur für die technische Machbarkeit von Bedeutung, sondern auch für die Kostenkontrolle, da die Nutzung dieser Modelle auf der Anzahl der verarbeiteten Token basiert. Hier kommt der Prompt Token Counter ins Spiel – ein Werkzeug, das entwickelt wurde, um die Anzahl der Token in Ihren Prompts und Antworten zu zählen und sicherzustellen, dass sie innerhalb der zulässigen Grenzen bleiben.

Die Bedeutung eines Token Counters kann nicht genug betont werden. Er hilft nicht nur dabei, die Modellgrenzen einzuhalten und somit eine Ablehnung der Anfrage aufgrund übermäßiger Token-Nutzung zu vermeiden, sondern ermöglicht auch eine effektive Kostenkontrolle. Indem Sie die Tokenanzahl im Auge behalten, können Sie unnötige Ausgaben vermeiden und Ihre Interaktionen mit den Modellen optimieren.

Darüber hinaus ist das Management der Tokenanzahl entscheidend für die effiziente Kommunikation mit dem Modell. Ein gut strukturierter und präziser Prompt, der die Token-Grenzen berücksichtigt, kann die Qualität und Relevanz der generierten Antworten erheblich verbessern. Der Prompt Token Counter unterstützt Sie dabei, Ihre Prompts so zu gestalten, dass sie klar und effektiv sind, ohne die zulässige Tokenanzahl zu überschreiten.

Zusammenfassend ist der Prompt Token Counter ein unverzichtbares Werkzeug für jeden, der mit OpenAI-Modellen arbeitet. Er gewährleistet nicht nur die Einhaltung der technischen Grenzen und eine effektive Kostenkontrolle, sondern verbessert auch die Qualität und Effizienz Ihrer Interaktionen mit den Modellen. Durch die sorgfältige Verwaltung der Tokenanzahl können Sie das Beste aus den Fähigkeiten dieser fortschrittlichen Sprachmodelle herausholen.