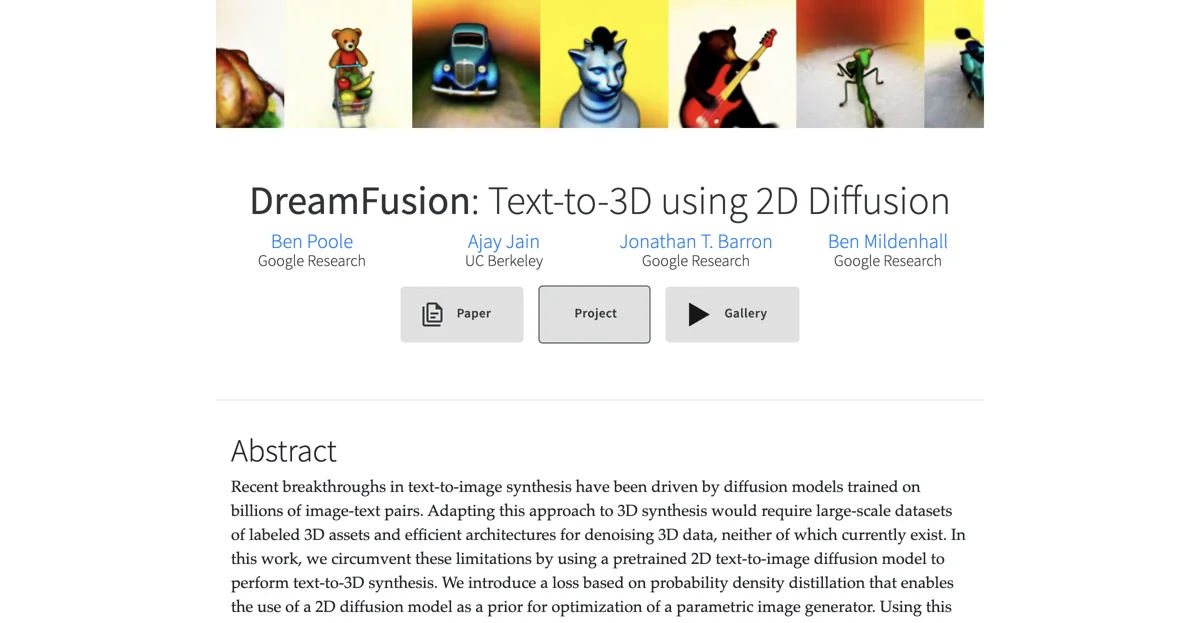

DreamFusion representa un avance significativo en la síntesis de modelos 3D a partir de texto, aprovechando los últimos desarrollos en modelos de difusión 2D. Este enfoque innovador permite la creación de objetos 3D detallados y relucientes sin la necesidad de datos de entrenamiento 3D específicos. Utilizando un modelo de difusión de texto a imagen preentrenado, como Imagen, DreamFusion optimiza un modelo 3D inicializado aleatoriamente (un Campo de Radiación Neural, o NeRF) para que sus representaciones 2D desde ángulos aleatorios logren una baja pérdida. Esto resulta en un modelo 3D que puede ser visualizado desde cualquier ángulo, iluminado de manera arbitraria o integrado en cualquier entorno 3D.

El proceso de DreamFusion se basa en la Muestreo de Destilación de Puntuación (SDS), una técnica que permite generar muestras a partir de un modelo de difusión optimizando una función de pérdida. SDS facilita la optimización de muestras en un espacio de parámetros arbitrario, como el espacio 3D, siempre que se pueda mapear de manera diferenciable a imágenes. DreamFusion añade regularizadores adicionales y estrategias de optimización para mejorar la geometría de los modelos 3D resultantes, asegurando una alta calidad en las normales, la geometría de la superficie y la profundidad.

Además, los modelos NeRF generados por DreamFusion pueden ser exportados a mallas utilizando el algoritmo de cubos marchantes, lo que facilita su integración en software de renderizado 3D o modelado. Esta herramienta abre nuevas posibilidades para la creación de contenido 3D, permitiendo a los usuarios generar objetos y escenas a partir de descripciones textuales con una fidelidad y detalle sin precedentes.