En el ámbito del procesamiento del lenguaje natural y el aprendizaje automático, el manejo eficiente de los tokens es crucial para interactuar con modelos avanzados como los de OpenAI. Un token, en este contexto, representa la unidad más pequeña de una secuencia de texto, que puede ser una palabra, un carácter o incluso una subpalabra, dependiendo de cómo se segmenta el texto. La tokenización es el proceso de descomponer un texto en estos tokens individuales, permitiendo a los modelos de lenguaje procesar y entender la información de manera efectiva.

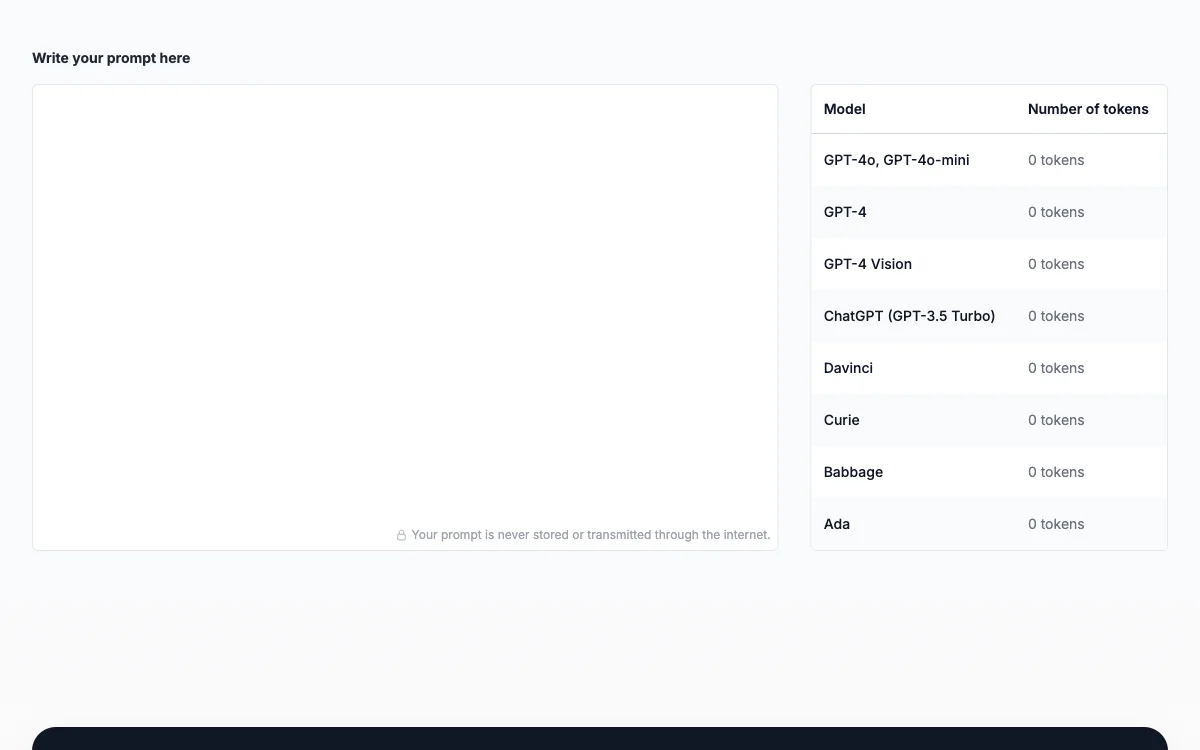

El contador de tokens de Prompt emerge como una herramienta indispensable para los desarrolladores y usuarios de modelos de lenguaje como GPT-3.5 de OpenAI. Esta herramienta permite monitorear el número de tokens en un prompt, asegurando que las interacciones con el modelo se mantengan dentro de los límites de tokens permitidos. Esto es esencial por varias razones:

-

Respetar los límites del modelo: Cada modelo de lenguaje tiene un límite máximo de tokens que puede procesar en una sola interacción. Exceder este límite puede resultar en el rechazo de la solicitud o en la truncación del texto.

-

Control de costos: Los modelos de lenguaje como GPT-3.5 cobran en función del número de tokens utilizados. Mantener un control sobre el conteo de tokens permite gestionar los costos de manera eficiente, evitando gastos innecesarios.

-

Gestión de respuestas: Al elaborar un prompt, es crucial considerar el número de tokens que se espera en la respuesta. Si se anticipa una respuesta extensa, puede ser necesario ajustar el prompt para asegurar que la interacción completa se mantenga dentro de los límites permitidos.

-

Comunicación eficiente: El conteo de tokens fomenta la creación de prompts concisos y efectivos, facilitando una comunicación clara y directa con el modelo.

Para contar los tokens de un prompt, se recomienda seguir estos pasos:

- Comprender los límites de tokens: Familiarizarse con los límites de tokens del modelo específico que se está utilizando.

- Preprocesar el prompt: Utilizar técnicas de tokenización para preparar el prompt antes de enviarlo al modelo.

- Contar los tokens: Determinar el número de tokens en el prompt, incluyendo palabras, puntuación, espacios y caracteres especiales.

- Ajustar para la respuesta: Considerar el número de tokens que se espera en la respuesta y ajustar el prompt si es necesario.

- Iterar y refinar: Si el prompt excede el límite de tokens, refinarlo y acortarlo hasta que se ajuste a los límites permitidos.

El contador de tokens de Prompt no solo es una herramienta práctica para optimizar las interacciones con los modelos de lenguaje, sino también un aliado en la gestión de costos y en la maximización de la eficiencia de las comunicaciones con estas avanzadas tecnologías de IA.