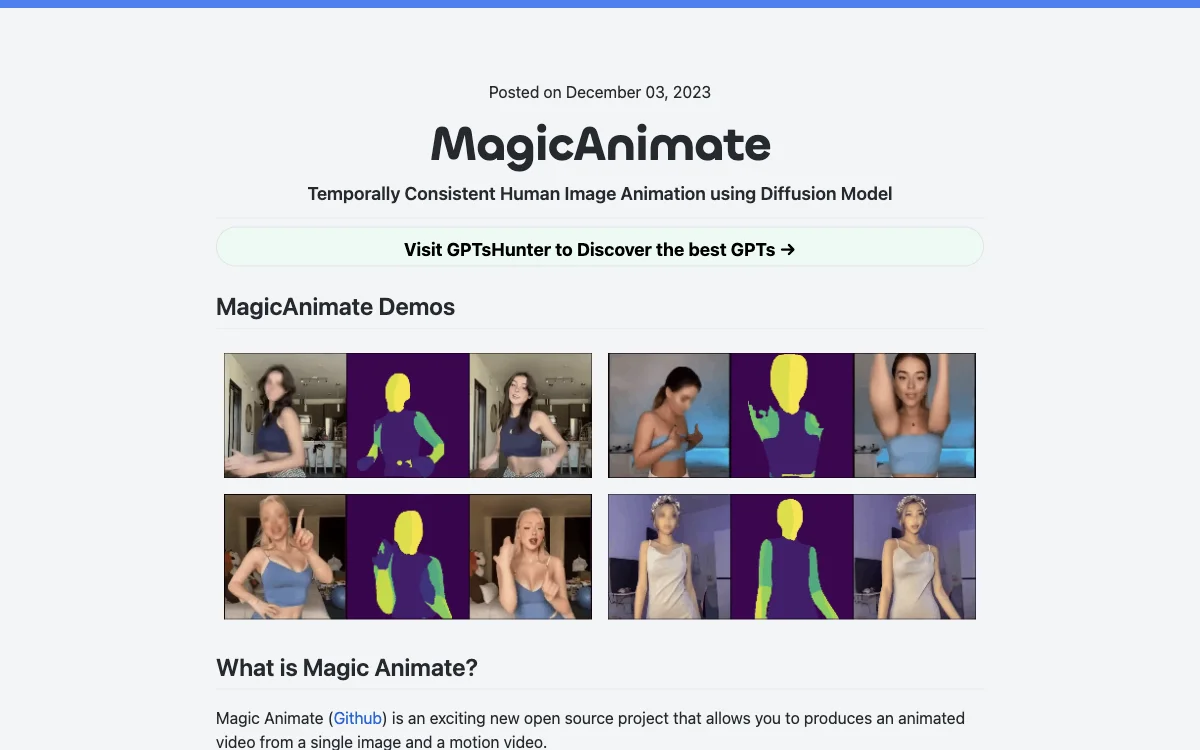

MagicAnimate: Temporally Consistent Human Image Animation using Diffusion Model

MagicAnimate 是一个令人兴奋的新开源项目,它允许您从单个图像和运动视频制作动画视频。这个创新的工具基于扩散模型,在保持时间一致性、忠实保留参考图像以及显著提高动画保真度方面表现出色。

由谁构建: Magic Animate 由 Show Lab、新加坡国立大学和字节跳动共同构建。

优势: 目前,它在所有舞蹈视频解决方案中提供了最高的一致性。

劣势: 存在一些面部和手部的失真问题(一个反复出现的问题)。在其默认配置中,风格会从动漫转变为现实主义,在视频中的面部尤其明显。这可能需要修改检查点。默认的基于 DensePose 驱动的视频是基于真实人类的,因此应用动漫风格可能会导致身体比例的变化。

与 AnimateAnyone 的比较: 由于 AnimateAnyone 尚未发布,目前无法尝试其演示。

如何开始: 请下载 StableDiffusion V1.5 和 MSE 微调 VAE 的预训练基础模型。下载我们的 MagicAnimate 检查点。安装要求:python>=3.8,CUDA>=11.3 和 ffmpeg。使用 conda 进行安装:

conda env create -f environment.yml

conda activate manimate

您可以在以下平台尝试 MagicAnimate 在线演示:

- Huggingface

- Replicate

- Colab

如何生成运动视频或将视频转换为运动视频:

OpenPose 是一个用于身体、面部、手部和脚部估计的实时多人关键点检测库。您可以使用以下模型将运动视频转换为 OpenPose:video to openpose,然后可以使用magic-animate-openpose将 OpenPose 与 MagicAnimate 一起使用。

更多关于 Magic Animate 的信息:

- 官方介绍

- [MagicAnimate Paper.pdf](MagicAnimate Paper.pdf)

- [MagicAnimate arXiv](MagicAnimate arXiv)

- [MagicAnimate GitHub 代码](MagicAnimate GitHub Code)

- [MagicAnimate 演示](MagicAnimate Demo)

© 2023 MagicAnimate