Prompt Token Counterは、OpenAIのGPT-3.5などの言語モデルを使用する際に、トークン使用量を追跡するための重要なツールです。トークンカウントは、モデルの最大トークン制限を超えないようにするために不可欠です。これにより、過剰なトークン使用によるリクエストの拒否を防ぐことができます。

トークンカウントは、コスト管理にも役立ちます。GPT-3.5のような言語モデルは、使用されたトークン数に基づいて課金されます。トークン数を意識することで、コストを効果的に管理し、不必要な支出を避けることができます。

また、プロンプトを作成する際には、レスポンスのトークン使用量を考慮することが重要です。レスポンスが長くなると予想される場合、プロンプトのトークン数を調整する必要があります。

トークンカウントは、言語モデルとのやり取りを最適化するための実用的なツールです。これにより、トークン制限とコストの制約内で、モデルの能力を最大限に活用することができます。

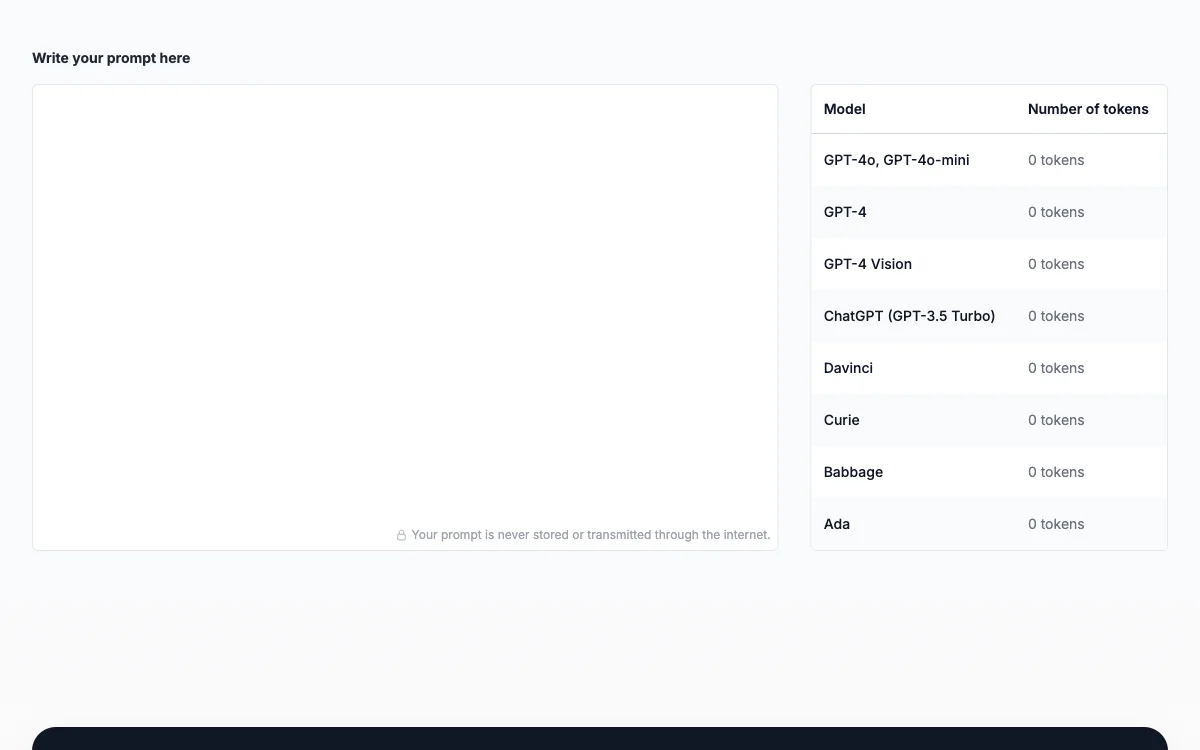

OpenAIモデルを使用する際に、プロンプトトークンを追跡することは、モデルのトークン制限内に収めるために不可欠です。トークンカウントは、特にプロンプトのトークン数がクエリのコストと実現可能性に直接影響を与えるため、重要です。

プロンプトトークンをカウントするには、以下の手順を実行します。

- トークン制限を理解する:使用するOpenAIモデルのトークン制限を把握します。例えば、GPT-3.5-turboの最大制限は4096トークンです。

- プロンプトを前処理する:モデルにプロンプトを送信する前に、実際のやり取りで使用するのと同じ技術を使用して前処理します。OpenAI GPT-3トークナイザーなどのトークン化ライブラリが役立ちます。

- トークンをカウントする:プロンプトが前処理されたら、含まれるトークンの数をカウントします。トークンには、単語だけでなく、句読点、スペース、特殊文字も含まれることに注意してください。

- レスポンスを調整する:モデルのレスポンストークンも考慮することを忘れないでください。長いレスポンスが予想される場合、プロンプトを切り詰めたり短くしたりする必要があります。

- 反復して洗練する:プロンプトがモデルのトークン制限を超えている場合、反復的に洗練して短くし、許可されたトークン数内に収まるようにします。

これらの手順に従うことで、プロンプトトークンを効率的に管理し、OpenAIモデルとのやり取りを最大限に活用することができます。これにより、スムーズでコスト効果の高い体験を確保できます。