Prompt Token Counter voor OpenAI-modellen

In de wereld van natuurlijke taalverwerking en het werken met taalmodellen zoals OpenAI's GPT-3.5 is het beheer van tokengebruik van groot belang. Een token, de kleinste eenheid in tekstverwerking, kan een woord, een karakter of een subwoord zijn. Tokenisatie is het proces waarbij tekst wordt opgedeeld in deze individuele tokens.

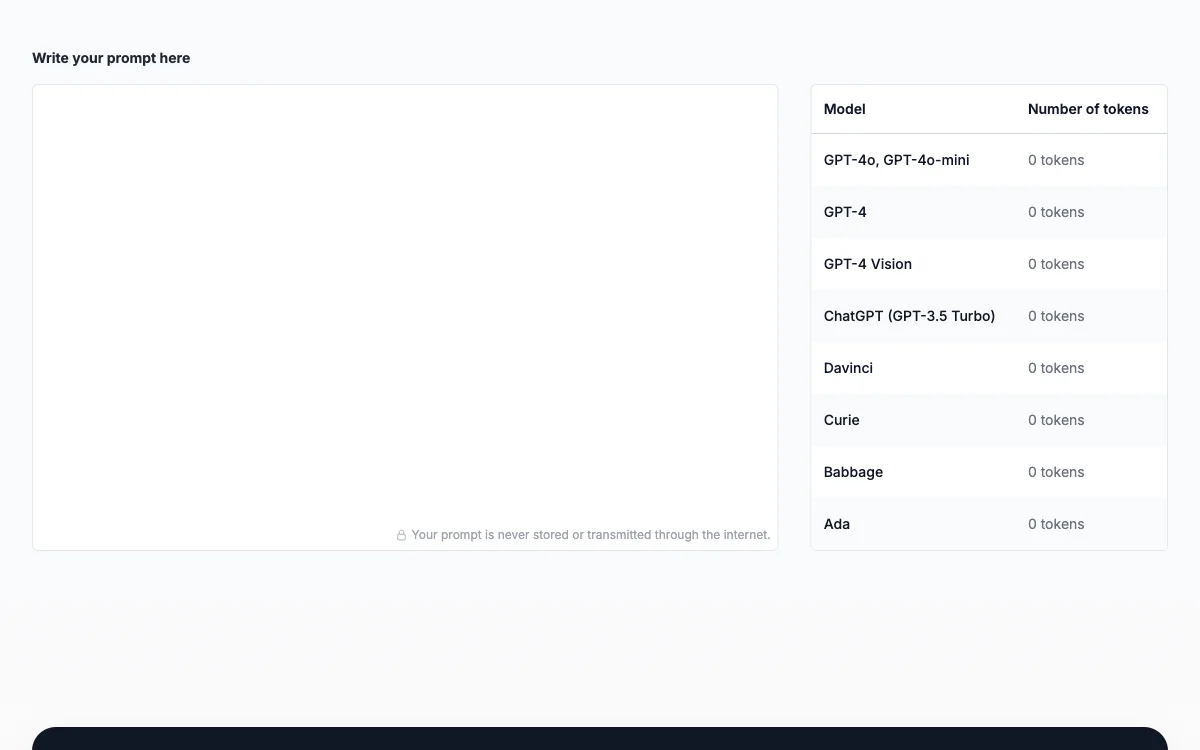

De Prompt Token Counter is een waardevol hulpmiddel. Het stelt gebruikers in staat om het tokenaantal in hun invoerprompts en uitvoerresponsen bij te houden. Dit is cruciaal omdat taalmodellen beperkingen hebben aan het aantal tokens dat ze in één interactie kunnen verwerken. Door binnen deze tokenlimieten te blijven, kunnen gebruikers voorkomen dat hun verzoeken worden afgewezen vanwege overmatig tokengebruik.

Bovendien helpt het bewust zijn van het tokenaantal bij kostenbeheersing. Taalmodellen zoals GPT-3.5 rekenen kosten aan op basis van het aantal gebruikte tokens. Daarom maakt efficiënt tokenbeheer het mogelijk voor gebruikers om kosten effectief te beheren en onnodige uitgaven te voorkomen.

Om prompttokens te tellen, moeten gebruikers zich vertrouwd maken met de tokenlimieten van het specifieke OpenAI-model dat ze gebruiken. Daarna kunnen ze hun prompt voorverwerken en het aantal tokens tellen dat het bevat. Het is ook belangrijk om rekening te houden met de responsetokens van het model en de prompt dienovereenkomstig aan te passen als een lange respons wordt verwacht.

Kortom, de Prompt Token Counter is een essentieel hulpmiddel voor het optimaliseren van interacties met taalmodellen, waardoor een soepele en kostenefficiënte ervaring wordt gegarandeerd.