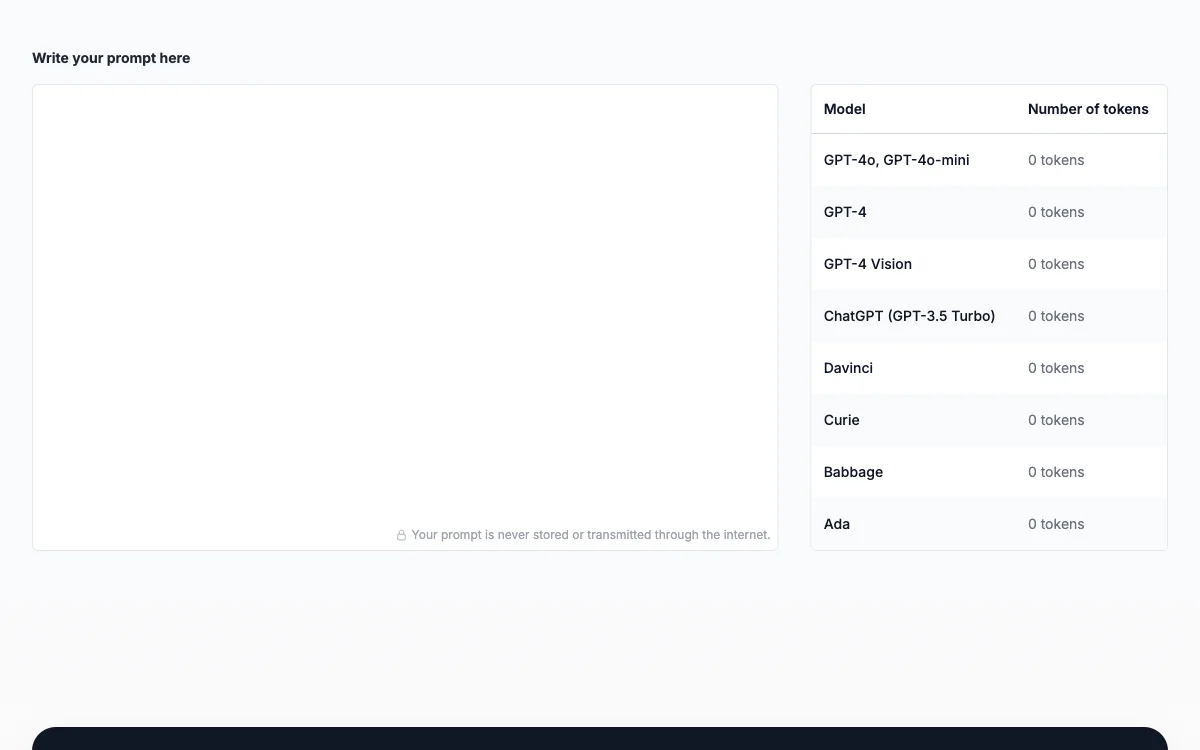

O Prompt Token Counter para modelos da OpenAI é uma solução inovadora projetada para ajudar desenvolvedores e entusiastas de IA a gerenciar eficientemente o uso de tokens ao interagir com modelos de linguagem avançados, como o GPT-3.5. Esta ferramenta é crucial para garantir que as interações com esses modelos permaneçam dentro dos limites de tokens permitidos, evitando a rejeição de solicitações devido ao uso excessivo de tokens e ajudando no controle de custos.

Os modelos de linguagem processam a entrada de texto na forma de tokens, que podem ser palavras, caracteres ou subpalavras, dependendo do tokenizador utilizado. Cada token consome uma certa quantidade dos recursos computacionais do modelo e contribui para a contagem total de tokens de uma interação. Quando o total de tokens excede o limite do modelo, a entrada ou saída precisa ser truncada ou reduzida para se ajustar.

Aqui estão algumas razões pelas quais o Prompt Token Counter é essencial:

- Permanecer dentro dos limites do modelo: Ao acompanhar a contagem de tokens, você pode evitar exceder o limite máximo de tokens do modelo. Isso impede que a solicitação seja rejeitada devido ao uso excessivo de tokens.

- Controle de custos: Modelos de linguagem como o GPT-3.5 cobram com base no número de tokens usados. Ser consciente da contagem de tokens permite que você gerencie os custos de forma eficaz e evite despesas desnecessárias.

- Gerenciamento de respostas: Ao elaborar o prompt, é crucial considerar o uso de tokens da resposta. Se a resposta for esperada como longa, você pode precisar ajustar a contagem de tokens do prompt de acordo.

- Comunicação eficiente: A contagem de tokens ajuda a garantir que você forneça prompts concisos e eficazes, transmitindo sua intenção ao modelo sem verbosidade desnecessária.

Em resumo, o Prompt Token Counter é uma ferramenta prática que auxilia na otimização das interações com modelos de linguagem, permitindo que você aproveite ao máximo suas capacidades enquanto permanece dentro das restrições de limites de tokens e considerações de custo.