В мире обработки естественного языка и машинного обучения, токены играют ключевую роль. Они представляют собой наименьшие единицы текста, которые модели, такие как GPT-3.5 от OpenAI, используют для обработки и генерации ответов. Токенизация — это процесс разбиения текста на отдельные токены, которые могут быть словами, символами или даже частями слов, в зависимости от используемого токенизатора.

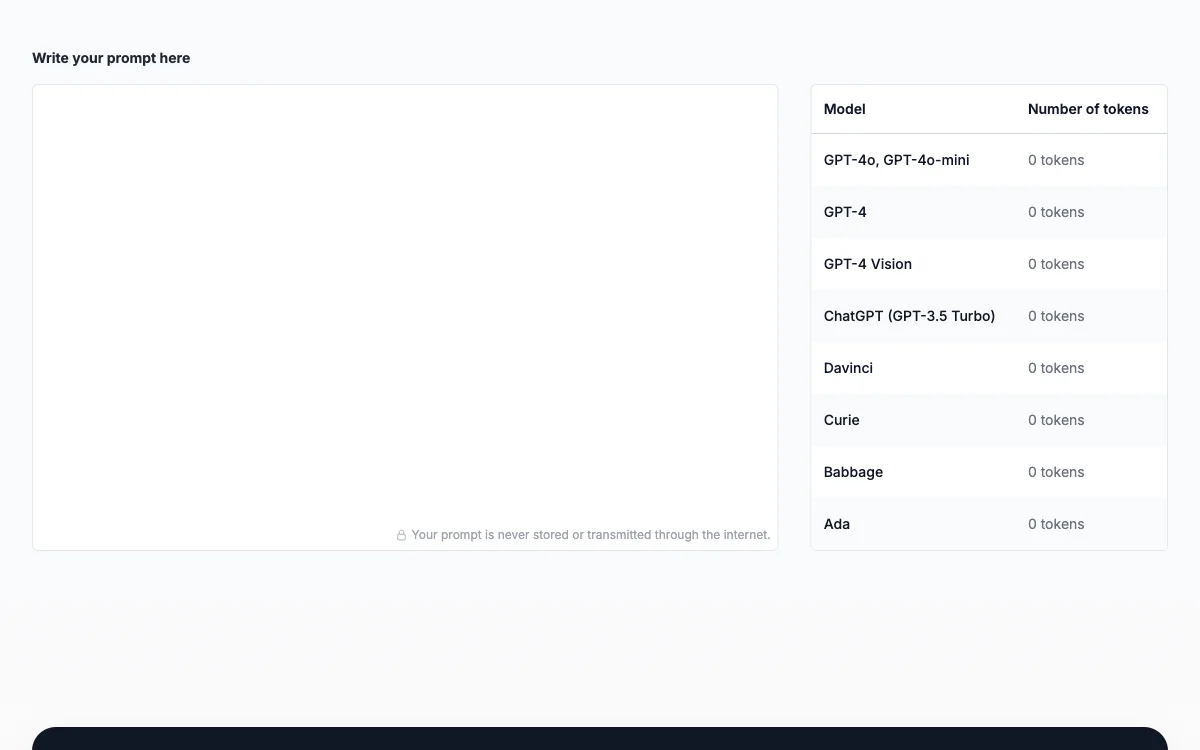

Счетчик токенов для подсказок (Prompt Token Counter) — это инструмент, который помогает пользователям отслеживать количество токенов в их запросах к моделям OpenAI. Это особенно важно, поскольку каждая модель имеет свои ограничения на максимальное количество токенов, которые могут быть обработаны в одном запросе. Например, GPT-3.5-turbo имеет лимит в 4096 токенов.

Использование счетчика токенов позволяет:

- Соблюдать лимиты модели: избегать превышения максимального количества токенов, что может привести к отклонению запроса.

- Контролировать затраты: поскольку использование моделей OpenAI тарифицируется на основе количества токенов, учет токенов помогает управлять расходами.

- Управлять ответами: учитывая ожидаемую длину ответа, можно корректировать количество токенов в запросе, чтобы он соответствовал лимитам модели.

- Оптимизировать коммуникацию: счетчик токенов способствует созданию лаконичных и эффективных запросов, что улучшает взаимодействие с моделью.

Для подсчета токенов в запросе можно использовать токенизаторы, такие как OpenAI GPT-3 tokenizer, которые помогают предварительно обработать текст и подсчитать количество токенов. Это включает не только слова, но и знаки препинания, пробелы и специальные символы.

Управление количеством токенов — это важный аспект работы с языковыми моделями, который позволяет максимально эффективно использовать их возможности, соблюдая ограничения по токенам и контролируя затраты.