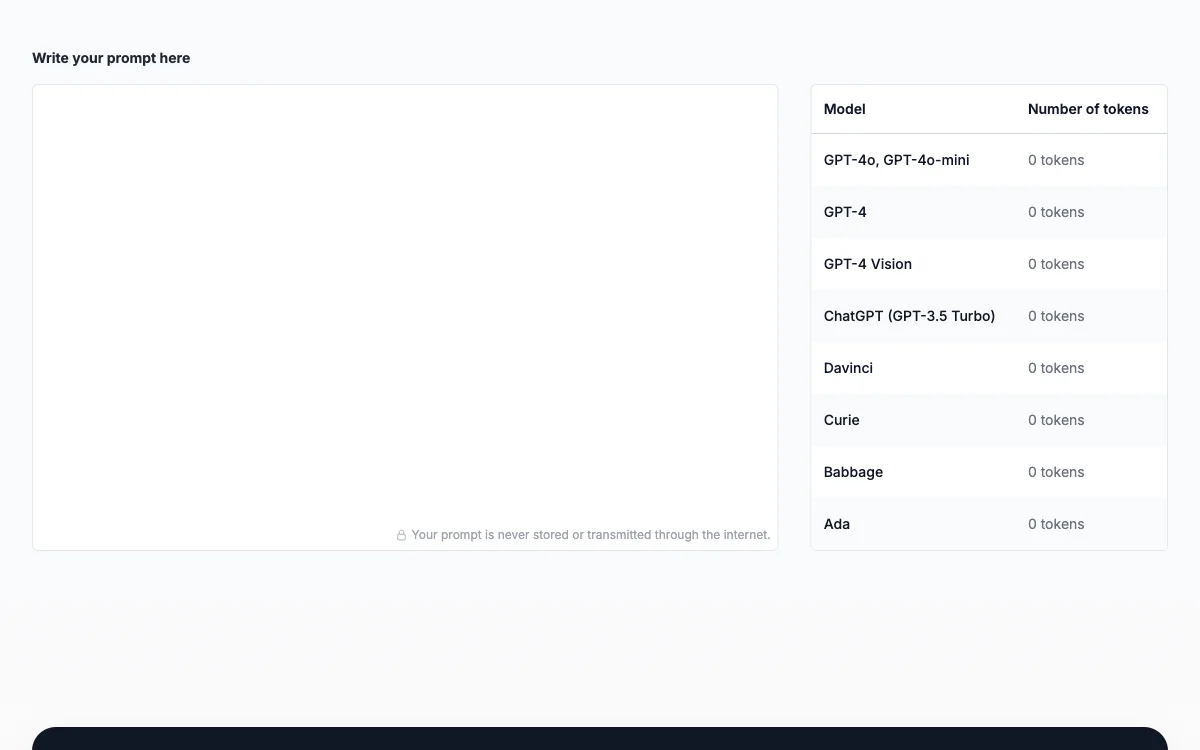

Trong lĩnh vực xử lý ngôn ngữ tự nhiên và học máy, quản lý số lượng token là quan trọng. Các mô hình ngôn ngữ như GPT - 3.5 của OpenAI có giới hạn số lượng token xử lý trong một lần tương tác. Token Counter là công cụ theo dõi việc sử dụng token trong prompt đầu vào và phản ứng đầu ra, nhằm đảm bảo phù hợp với giới hạn token của mô hình. Trong quá trình xử lý văn bản, token có thể là từ, ký tự hoặc phụ từ. Khi sử dụng mô hình như GPT - 3.5, mỗi token tương ứng với một phần cụ thể của văn bản và mô hình xử lý các token này để tạo phản ứng. Vì có giới hạn số lượng token tối đa trong một lần tương tác nên quản lý số lượng token rất quan trọng để đảm bảo sự tương tác thành công và hiệu quả.

Prompt Token Counter for OpenAI Models

Token Counter cho OpenAI giúp quản lý token, đảm bảo tương tác hiệu quả và tiết kiệm chi phí.

Các lựa chọn thay thế cho Prompt Token Counter for OpenAI Models

Vidura

Vidura là quản lý prompt AI siêu lợi hại, tăng năng suất

OctiAI

OctiAI là công cụ tạo prompt AI mạnh mẽ, giúp nâng cao hiệu quả

Redmo

Redmo là một dịch vụ hỗ trợ tạo mẫu prompt với biến và API

NeoPrompts

NeoPrompts là công cụ AI giúp tối ưu câu hỏi cho ChatGPT và đạt kết quả chính xác.

Promptrr.io

Promptrr.io là thị trường AI prompt giúp người dùng tối ưu hóa mô hình AI

PromptPort

PromptPort là công cụ hỗ trợ tạo các gợi ý tốt nhất cho nhiều lĩnh vực.

BasicPrompt

BasicPrompt là công cụ được hỗ trợ bởi AI giúp bạn tạo và quản lý các gợi ý một cách dễ dàng.

Viện Kỹ thuật Gợi ý

Viện Kỹ thuật Gợi ý cung cấp nhiều tài nguyên và hướng dẫn về AI

Promptologer

Promptologer giúp kỹ sư prompt kiếm tiền từ prompt mà không cần mã code

Prompt Genie

Prompt Genie biến các gợi ý đơn giản thành siêu gợi ý cho kết quả ChatGPT tuyệt vời

Learn Prompting Pro

Learn Prompting Pro là khóa học AI giúp người dùng học Prompt Engineering dễ dàng và khai thác sức mạnh của GPT-4.

endoftext

endoftext là công cụ tối ưu hóa prompt AI giúp người dùng nhanh chóng cải thiện.

Latitude

Latitude là nền tảng mã nguồn mở giúp bạn xây dựng và tối ưu hóa các prompt AI một cách hiệu quả.

Promptmetheus

Promptmetheus là một công cụ IDE AI giúp tối ưu hóa và thử nghiệm các lời nhắc cho ứng dụng AI.

GPT Prompt Tuner

GPT Prompt Tuner là công cụ AI giúp bạn tối ưu hóa prompt ChatGPT, tạo ra nhiều biến thể và chat cùng lúc.

BetterPrompt

BetterPrompt là công cụ AI giúp bạn nâng cấp prompt Midjourney, dễ dàng tạo ra những hình ảnh đẹp mắt.

PromptDen

PromptDen là nền tảng cộng đồng để chia sẻ và khám phá các prompt AI.

Learn Prompting

Learn Prompting là khóa học AI giúp bạn giao tiếp với AI một cách hiệu quả và thông minh.

Hướng Dẫn Kỹ Thuật Prompt

Hướng Dẫn Kỹ Thuật Prompt là nguồn tài nguyên toàn diện giúp bạn làm chủ các kỹ thuật prompt cho mô hình ngôn ngữ.

Weavel

Weavel là công cụ AI giúp tự động hóa việc tối ưu prompt, nhanh gấp 50 lần so với cách làm thủ công.

PromptLeo

PromptLeo là nền tảng kỹ thuật prompt AI giúp đội ngũ tạo, thử nghiệm và thay đổi prompt dễ dàng.