ALBERT:语言表示自监督学习的创新模型

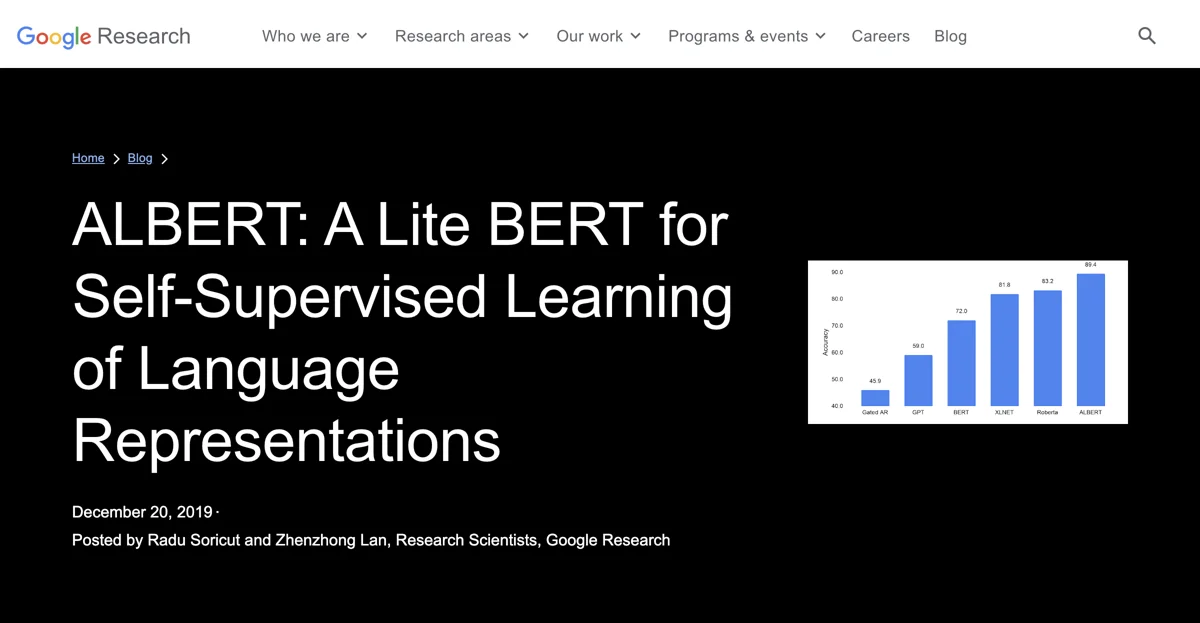

自 BERT 出现以来,自然语言研究迎来了新范式,利用大量现有文本通过自监督预训练模型参数,无需数据标注。而 ALBERT 作为 BERT 的升级版本,在 12 个自然语言处理(NLP)任务中取得了先进的性能表现,包括具有竞争力的斯坦福问答数据集(SQuAD v2.0)和 SAT 风格的阅读理解 RACE 基准。

ALBERT 的设计关键在于更有效地分配模型容量。通过对嵌入参数化的因子分解,将嵌入矩阵在输入级嵌入(如单词、子标记等)和隐藏层嵌入之间进行分割。输入级嵌入需要学习与上下文无关的表示,而隐藏层嵌入则将其细化为上下文相关的表示。仅这一步,ALBERT 就实现了投影块参数的 80%减少,且性能仅有轻微下降。

另一个关键设计决策是基于对冗余的观察。Transformer 架构的神经网络(如 BERT、XLNet 和 RoBERTa)依赖于相互堆叠的独立层,但网络在各层常常学习执行相似操作。ALBERT 通过在各层之间共享参数来消除这种可能的冗余,虽然会略微降低准确性,但模型更加紧凑。

将这两种设计变化结合起来,产生的 ALBERT-base 模型仅有 1200 万参数,与 BERT-base 模型相比参数减少了 89%,但在各项基准测试中仍取得了可观的性能。并且,在内存大小允许的情况下,可以将隐藏层嵌入的大小扩大 10 - 20 倍,如 ALBERT-xxlarge 配置在参数减少 30%的同时,在 SQuAD2.0 和 RACE 上取得了显著的性能提升。

通过 RACE 数据集评估模型的语言理解能力,ALBERT 在某些情况下表现出色,甚至超越了其他先进模型,建立了新的最先进分数。ALBERT 的成功表明了识别模型中产生强大上下文表示的方面的重要性,为 NLP 领域的进一步发展做出了贡献。