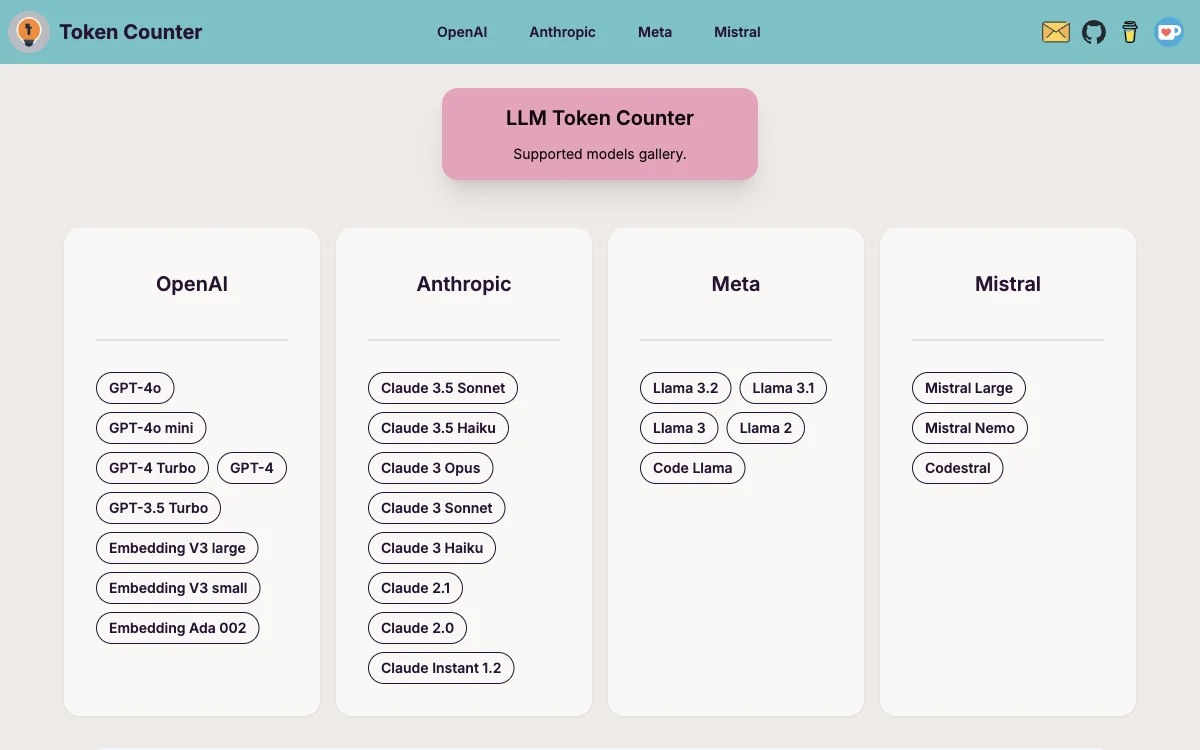

LLM Token Counter 是一款专为帮助用户有效管理多种流行语言模型(LLMs)令牌限制而精心设计的工具。它支持包括 GPT-3.5、GPT-4、Claude-3、Llama-3 在内的多种模型,致力于不断扩展支持的模型范围并增强工具功能,以提供利用生成式 AI 技术的最佳体验。

使用 LLM Token Counter 的原因在于,由于 LLMs 固有的限制,确保您的提示令牌数在指定的令牌限制内至关重要。超出此限制可能会导致 LLM 产生意外或不理想的输出。

LLM Token Counter 的工作原理是利用 Transformers.js,这是著名的 Hugging Face Transformers 库的 JavaScript 实现。令牌器直接在您的浏览器中加载,使得令牌计数计算可以在客户端执行。得益于 Transformers 库的高效 Rust 实现,令牌计数计算速度非常快。

关于数据隐私,您不会泄露您的提示。令牌计数计算在客户端执行,确保您的提示保持安全和机密。您的数据隐私至关重要,这种方法保证了您的敏感信息永远不会传输到服务器或任何外部实体。