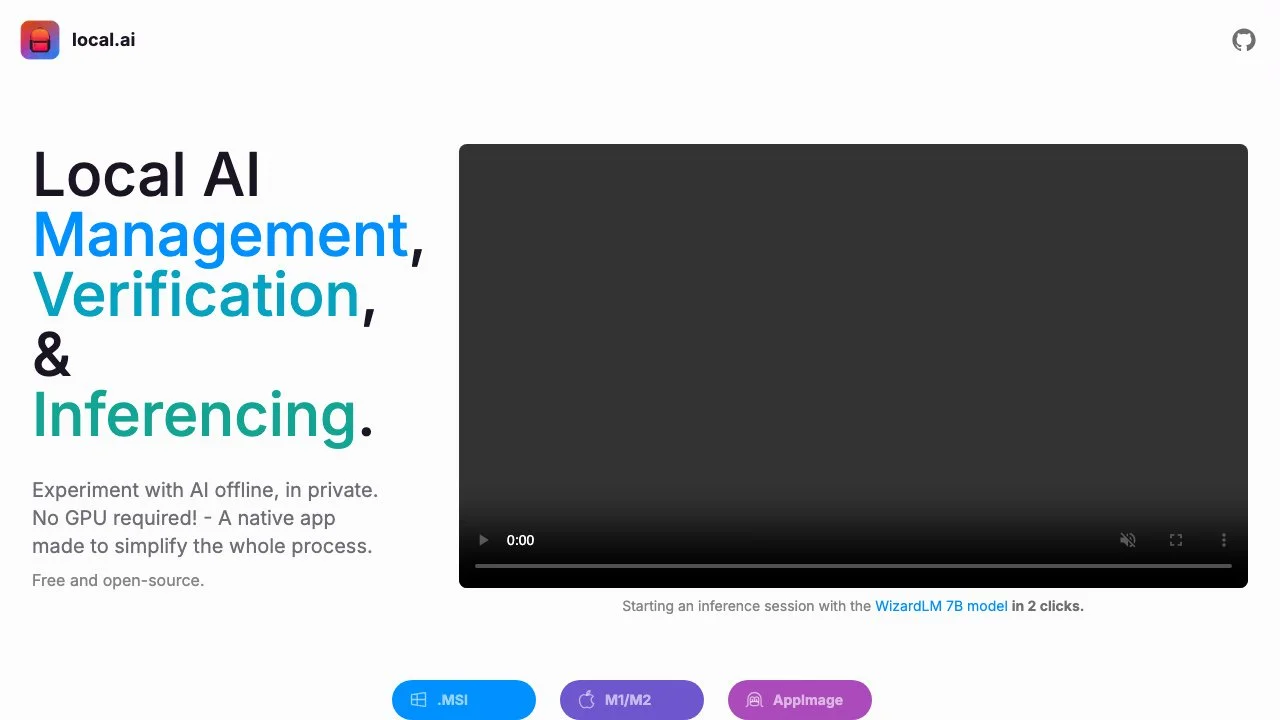

local.ai 是一款功能强大的本地应用程序,旨在简化整个 AI 管理、验证和推理的过程。它具有许多显著的特点和功能。

这款应用支持离线实验 AI,保护用户隐私,无需 GPU 即可运行。它是一个免费且开源的工具,具有很高的实用性。local.ai 拥有一个 Rust 后端,使其在内存使用方面非常高效且紧凑,在 Mac M2、Windows 和 Linux.deb 系统上占用空间小于 10MB。

其现有的功能包括 CPU 推理,能够适应可用线程;GGML 量化,如 q4、5.1、8、f16 等。即将推出的功能有 GPU 推理和并行会话。

在模型管理方面,用户可以在一个集中的位置跟踪自己的 AI 模型。它具有可恢复的并发下载器,支持基于使用情况的排序,并且不受目录限制。未来还将支持嵌套目录以及自定义排序和搜索功能。

此外,local.ai 还具备强大的消化验证功能,通过 BLAKE3 和 SHA256 摘要计算来确保下载模型的完整性。现有的功能包括摘要计算、已知良好模型 API 以及许可证和使用芯片的 BLAKE3 快速检查,未来还将推出模型浏览器、模型搜索和模型推荐功能。

最后,local.ai 可以通过点击两下启动一个本地流媒体服务器进行 AI 推理,具有流媒体服务器、快速推理 UI、写入.mdx、推理参数和远程词汇等功能,未来还将支持服务器管理、音频、图像等功能。