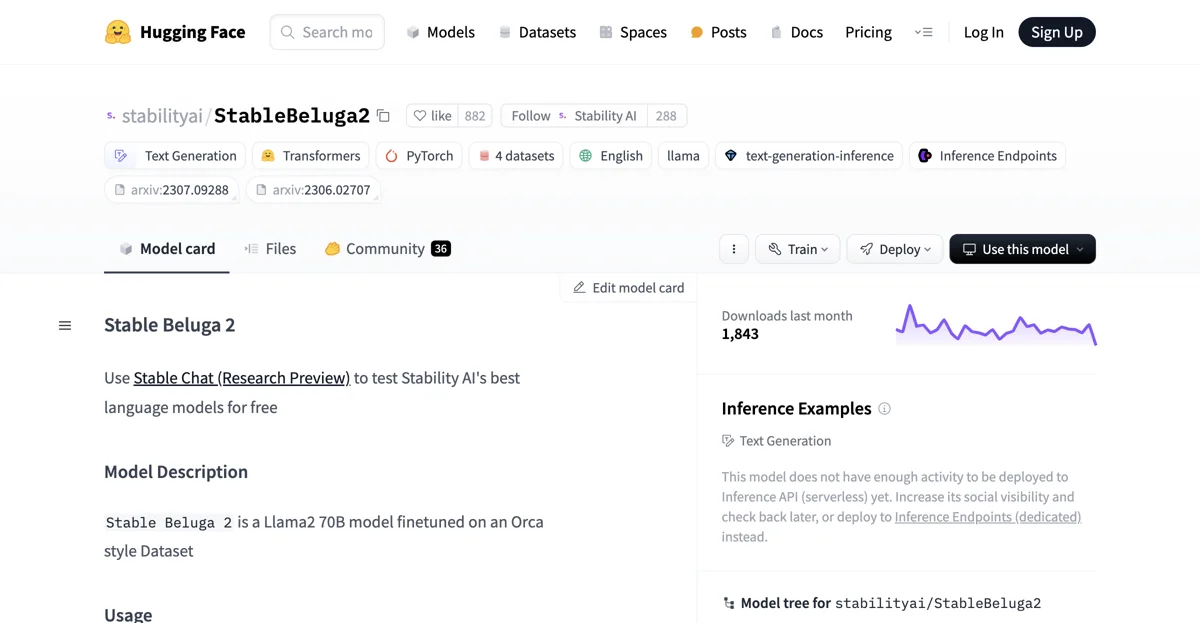

StableBeluga2是由Stability AI开发的一款自动回归语言模型,它基于Llama2 70B进行了微调。其主要应用于英语环境,依托HuggingFace Transformers库运行。

在使用方面,通过以下代码片段即可开始与StableBeluga2进行聊天互动:首先导入相关库,如import torch以及从transformers中导入AutoModelForCausalLM、AutoTokenizer和pipeline。然后分别对tokenizer和model进行初始化设置,其中tokenizer通过AutoTokenizer.from_pretrained("stabilityai/StableBeluga2", use_fast=False)获取,model则通过AutoModelForCausalLM.from_pretrained("stabilityai/StableBeluga2", torch_dtype=torch.float16, low_cpu_mem_usage=True, device_map="auto")来初始化。接着设置系统提示和用户消息内容,将其组合成prompt后,利用tokenizer进行处理并传入model.generate方法中,即可得到输出结果并进行解码展示。

该模型有着特定的提示格式要求,需按照### System: This is a system prompt, please behave and help the user. ### User: Your prompt here ### Assistant:这样的格式来使用。

在模型细节方面,它属于 Stable Beluga 2类型的自动回归语言模型,训练所使用的数据集是内部的Orca风格数据集。训练过程中,模型通过在上述数据集上进行监督微调来学习,采用混合精度(BF16)训练,并使用AdamW进行优化,同时明确了如数据集批处理大小、学习率、学习率衰减、预热、权重衰减、贝塔值等一系列超参数。

然而,需要注意的是,Beluga作为一种新技术,在使用过程中存在一定风险。目前的测试主要集中在英语环境,且无法涵盖所有可能的场景。所以,与其他大型语言模型一样,其对用户提示的潜在输出结果无法提前准确预测,在某些情况下可能会产生不准确、有偏差或其他令人反感的回应。因此,开发者在部署该模型的任何应用之前,应当针对具体应用场景进行安全测试和调整。

虽然目前该模型的活动量尚不足以部署到推理API(无服务器),但可以通过增加其社会知名度后续再进行查看,或者选择部署到推理端点(专用)。总之,StableBeluga2在文本生成等方面有着自身的特点和应用方式,同时也需要使用者充分了解其特性及潜在风险。