Reflection 70B représente une avancée majeure dans le domaine des modèles de langage (LLM) open-source. Basé sur l'architecture Llama 70B, ce modèle se distingue par sa capacité d'auto-correction innovante, surpassant même GPT-4 dans plusieurs benchmarks. Son approche unique, appelée 'Reflection-Tuning', permet une correction en temps réel des erreurs de raisonnement, assurant ainsi une précision et une fiabilité accrues.

L'une des caractéristiques les plus remarquables de Reflection 70B est sa compatibilité avec les outils et pipelines existants, facilitant son intégration dans divers workflows sans perturber les systèmes établis. Cela en fait un allié précieux pour les développeurs, les chercheurs et les professionnels cherchant à améliorer leur productivité grâce à l'IA.

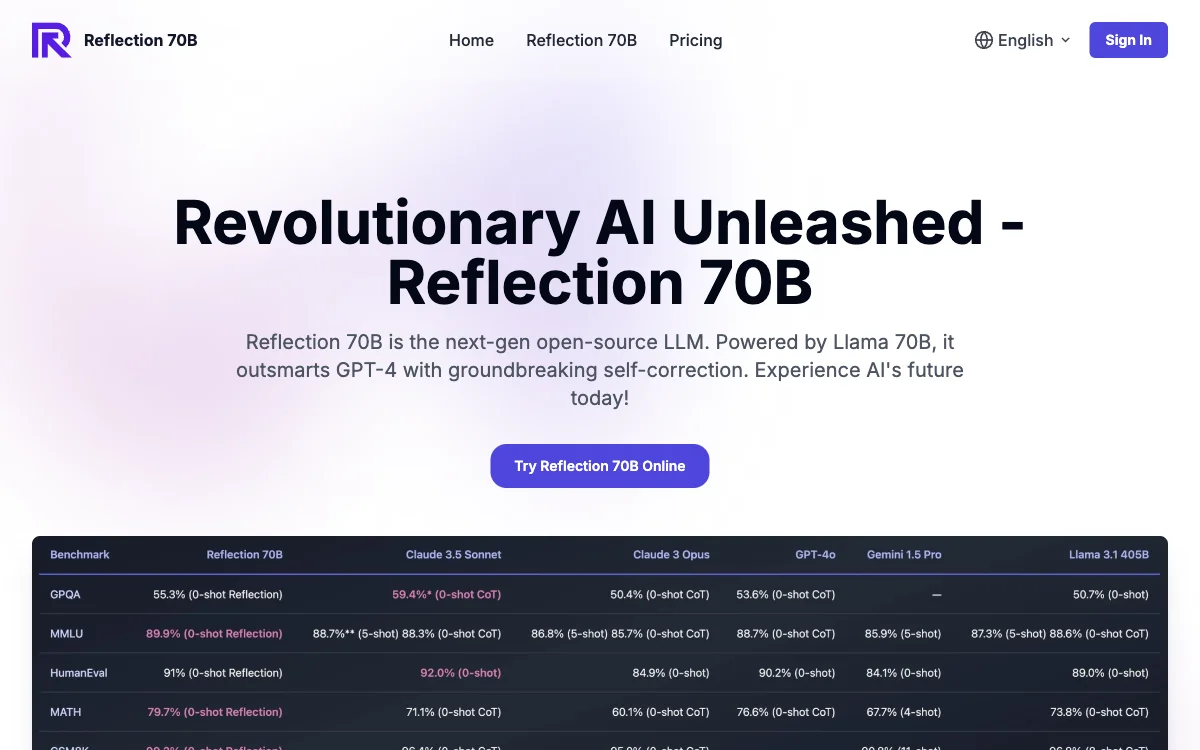

En termes de performance, Reflection 70B a démontré des résultats exceptionnels dans des benchmarks variés, y compris MMLU, HumanEval, MATH, IFEval et GSM8K. Sa maîtrise des tâches nécessitant une haute précision, ainsi que ses capacités avancées en codage, en font un outil indispensable pour la résolution de problèmes complexes et le développement de logiciels.

Pour commencer à utiliser Reflection 70B, il suffit de naviguer vers l'interface de chat sur leur site web. Aucune inscription n'est requise, permettant aux utilisateurs de commencer à interagir avec le modèle immédiatement. Que ce soit pour des questions simples, des tâches complexes ou de l'assistance en codage, Reflection 70B est conçu pour offrir des réponses précises et fiables, marquant ainsi une nouvelle ère dans les capacités de l'IA.