LM Studio é uma aplicação de software inovadora projetada para simplificar o uso de modelos de linguagem grandes (LLMs) de código aberto. Com uma interface intuitiva, o LM Studio permite que usuários explorem, baixem e executem diversos modelos de IA diretamente em seus computadores, tornando a tecnologia de IA mais acessível e gerenciável para todos, independentemente de suas habilidades de programação.

Uma das principais características do LM Studio é a capacidade de rodar LLMs em seu laptop, totalmente offline. Isso significa que você pode utilizar modelos avançados de IA sem a necessidade de uma conexão constante à internet. Além disso, o LM Studio oferece uma interface de chat integrada e um servidor local compatível com OpenAI, proporcionando uma experiência de usuário fluida e versátil.

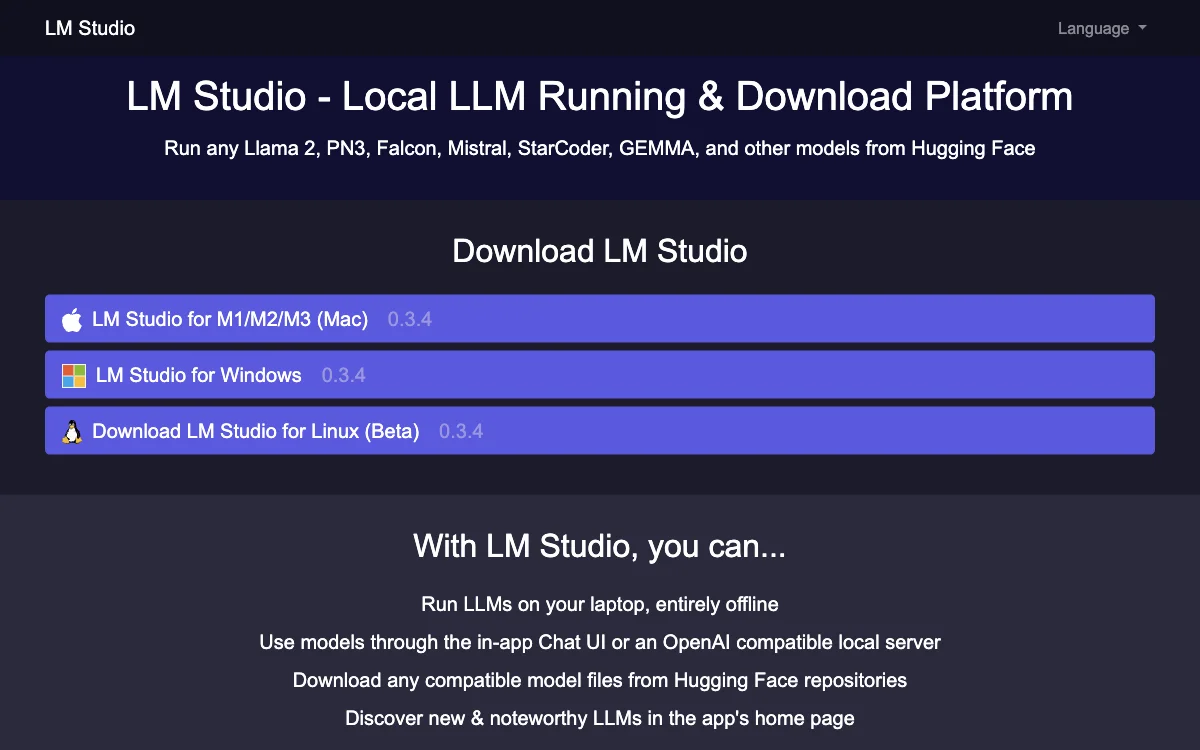

Outro destaque do LM Studio é a facilidade de baixar qualquer arquivo de modelo compatível diretamente dos repositórios do Hugging Face. Isso abre um leque de possibilidades para usuários que desejam experimentar com diferentes modelos de IA, incluindo LLaMa 2, PN3, Falcon, Mistral, StarCoder, GEMMA, entre outros.

O aplicativo também inclui uma página inicial que destaca novos e notáveis LLMs, ajudando os usuários a descobrir as últimas inovações no campo da IA. Com suporte para Mac (M1/M2/M3), Windows e Linux (Beta), o LM Studio é uma solução versátil para quem deseja explorar o potencial dos modelos de linguagem grandes de forma local e eficiente.

Perguntas frequentes sobre o LM Studio incluem questões sobre a necessidade de habilidades de programação (não é necessário), requisitos mínimos de hardware/software, como instalar o aplicativo, a possibilidade de rodar múltiplos modelos de IA simultaneamente, e se o LM Studio é gratuito para uso. Além disso, o LM Studio oferece orientações sobre como garantir que seu computador possa lidar com um modelo de IA específico e esclarece sobre o uso do aplicativo para fins comerciais.

Em resumo, o LM Studio é uma ferramenta essencial para entusiastas e profissionais de IA que buscam uma maneira fácil e eficiente de trabalhar com modelos de linguagem grandes diretamente em seus dispositivos locais.